当AI学会“睡眠”,是更像人还是更陌生?

人类的大脑会在梦里筛选记忆,如今,AI也开始学会在「睡眠」中整理、保存,甚至遗忘。Bilt部署数百万智能体,让科幻小说里「仿生人会梦见电子羊吗?」的设问逐步成真。那么,当AI也能选择忘记时,它会变得更像人,还是更陌生?

几十年前,菲利普·迪克提出了一个看似荒诞,却直击人心的问题:「仿生人会梦见电子羊吗?」如果机器也能做梦,它们梦见的,会不会是人类记忆的残影?半个世纪后,这个问题正在以另一种方式被回应,人类在睡眠中整理记忆,而今天,一些AI也开始「学会」这样做。

AI也会「做梦」,睡眠中的记忆整理实验

对人类来说,睡眠不仅是休息,更是一次「后台整理」。大脑会自动把白天的精力归档:记住重要的,忘记无关的。

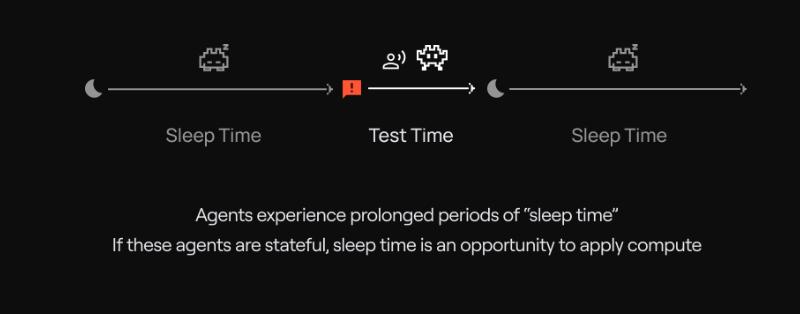

Bilt公司最近部署了数百万个AI智能体,并为他们安排了「睡眠时间」。在这段时间里,AI会停下对话,启动「睡眠计算」(sleeptime compute)的机制,像人脑一样整理记忆。它们会评估过往的互动,决定哪些内容进入长期记忆库,哪些放在快速提取区。

Fast Company指出,这不仅是模仿人类的梦,更是主动智能的开端:AI不再被动回答,而是在睡眠中「预演未来」,在推理任务上展现出更高的效率与更低的成本。这种看似科幻的实验,让「AI会做梦」不再只是文学隐喻,而是正在发生的现实。

从人脑到AI,记忆机制的巨大差距

人类大脑的记忆,就像一块不断吸水的海绵。这意味着,人类不仅能记住事情本身,还能带着情绪权重来筛选信息,并且能在不知不觉中提炼重点,把情绪、场景、细节打包成长期经验。

而AI的大脑远没这么灵活。它们的「记忆」取决于上下文窗口,只能调用输入的信息。即便GPT - 4 Turbo的上限是128k tokens,也不过相当于几百页书。相比之下,人脑的容量被估算高达2.5PB(250万GB)。

因此,想让AI记得上次说了什么,就需要把内容再输入一遍。但问题是,上下文窗口长度有限。如果信息量太大,AI就容易「过载」,出现逻辑混乱、答非所问、凭空幻觉等情况。相比之下,人类不仅能牢牢记住重要信息,还能在需要时灵活调用。

正如Letta的CEO Charles Packer所说:人类大脑会因为不断吸收而进化,但语言模型在同一个上下文里循环太久,只会被污染,越跑越偏,直到不得不重置。这意味着,人类的「梦境」能让我们更清醒,而AI的「上下文」却常常让它迷失。

Bilt+Letta,百万智能体的「睡眠计算」

在Bilt的实验中,睡眠计算是核心。

数百万AI智能体同时运行时,大部分其实都处于空闲状态。这些智能体会在后台进入一种「休眠」状态,暂停与用户的交互,转而对过去的对话和经验做一次系统化梳理。

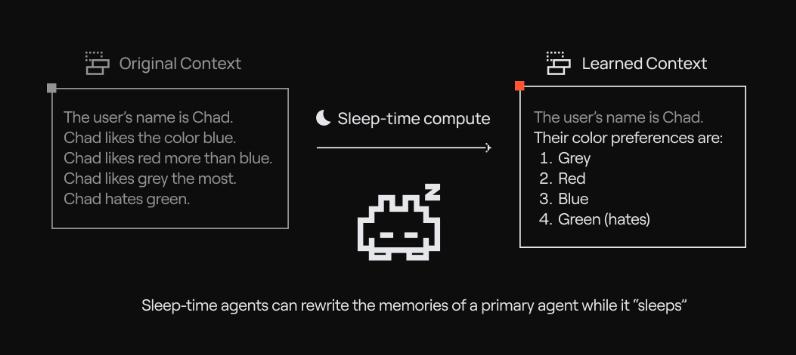

它们会自动区分两类信息:第一类是长期记忆,像用户的偏好、历史记录、关键事件,这些会被牢固保存;第二类是快速提取,更短期、临时性的信息,可以随时调用,也能很快被替换。

在Letta的演示中,用户Chad的偏好最初是零碎的描述:Chad喜欢蓝色,比蓝色更喜欢红色,最喜欢灰色,讨厌绿色。经过睡眠计算后,这些信息被整理成清晰的偏好表。这就像把零散的对话记录压缩成一份长期「记忆档案」。

图:睡眠代理整理用户输入的内容,并把用户对颜色的喜好排序

更具颠覆性的是,这两个区间并非孤立存在。Letta的技术支持对某一个「记忆块」进行单点更新,随后数十万智能体的行为便会随之改变。这意味着,AI个体之间的「经验」是可共享的。

正如Bilt的工程师Andrew Fitz所说:「我们可以通过一次更新,就让整个系统的表现发生连锁变化。」

根据Letta的介绍,该机制采用的是「主代理+睡眠代理」的架构。前者负责实时交互,后者在后台持续整理记忆,把信息写入共享的memory blocks,让AI在「醒来」后拥有更清晰、更稳定的认知。

对此,Fast Company评论道:这不仅是模仿人类的梦境,更是「主动智能」(proactive intelligence) 的雏形。AI不再只是被动回答,而是在睡眠中提前优化推理策略。实验显示,在数学和逻辑测试中,应用睡眠计算的模型表现更好,推理时间和成本也显著下降。

如果说人类的梦境是私密的,那AI的「睡眠记忆」更像是一场同步的大规模演练。

从健忘到记忆,AI的短板与突围

越来越多的用户抱怨AI健忘、答非所问,甚至编造「回忆」。不少研究者认为,记忆缺陷是限制AI智能与稳定的根源。如果没有稳定可靠的记忆,AI无法形成真正的个性化与长期价值。也正因如此,「提高记忆力」成为行业的集体突围方向。

LangChain的CEO Harrison Chase把记忆视为「上下文工程的核心」。他认为,AI的智能很大程度取决于开发者选择放进上下文的信息。LangChain因此提供了不同的记忆存储机制,从用户长期画像到近期交互记录,都能灵活调用。

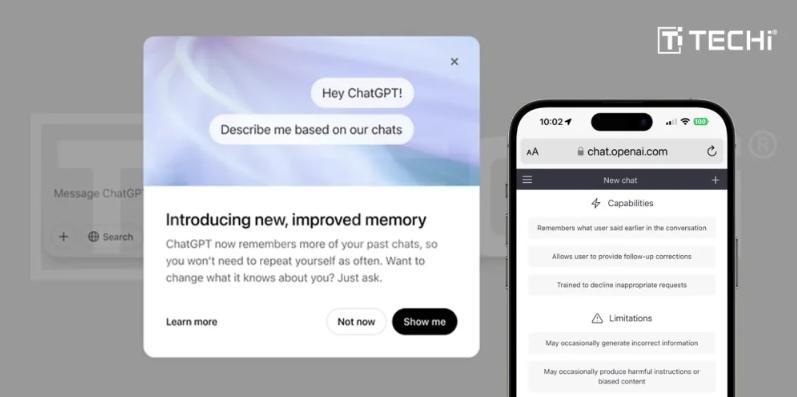

对此,OpenAI也在尝试。今年2月,它宣布ChatGPT将具备记忆功能,能在多轮对话中逐步学习用户偏好,只不过细节并未公开。

与此不同的是,Letta和LangChain把「记忆回调」的过程完全透明化,方便工程师理解和管理。AI托管平台Hugging Face的CEO Clem Delangue也强调:「不仅模型需要开放,记忆系统也必须开放。」

MemGPT则在探索如何把短期与长期记忆区分开,避免AI被「污染」。这套思路后来被Letta进一步扩展,用在了大规模智能体的「睡眠计算」中。可以说,「谁先解决记忆问题,谁就更接近下一个AI时代」。

学会遗忘,AI未来的关键一步

在大多数人眼里,AI的进化意味着要「记住更多」。但Charles Packer却提出另一种思路:AI不仅要会记,还要学会忘。

在人类世界,遗忘是进化出的优势。研究显示,睡眠中的「智能忘却」能帮助大脑抑制无效信息,把注意力集中在真正重要的片段上。如果没有遗忘,我们的大脑就会像塞满文件的硬盘,总有一天会崩溃。

而对于AI来说,这是它面临的另一难题:灾难性遗忘(catastrophic forgetting)。因为,AI的神经网络在学习新任务时,往往会覆盖旧知识。

这和人类的「选择性遗忘」不同,它是一种有层次的、可控的机制。因此,未来的AI需要发展出「人工遗忘」。

当用户对AI说「把那个项目删掉,不要再记了」,未来AI的回应不止是停止调用这段记忆,还能追溯性地清除所有相关内容。即使是AI,也必须学会删除涉及敏感或过时的信息。

在欧洲,「被遗忘权(Right to Be Forgotten)」已写进隐私法规。这不仅是技术挑战,更是伦理问题。那么,谁有权利决定AI记得什么、忘记什么?当遗忘成为可能,它会带来更安全的使用体验,还是新的操控手段?或许,真正让AI更像人的,不是「永不遗忘」,而是「学会遗忘」。

参考资料:

https://www.wired.com/story/sleeptime-compute-chatbots-memory/

https://www.fastcompany.com/91368307/why-sleep-time-compute-is-the-next-big-leap-in-ai?utm_source=chatgpt.com

https://www.letta.com/blog/sleep-time-compute?utm_source=chatgpt.com

本文来自微信公众号“新智元”,编辑:倾倾,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com