单卡还可以跑万帧,智源发布Video-XL-二、速度、效果、长度都打满了。

【简介】智源研究院发布Video开源模型-XL-2.显著提高对长视频的理解能力。该模型全面优化了效果、处理长度和速度,支持单卡处理万帧视频,2048帧编码只需12秒。

长视频理解是多模态大模型的关键能力之一。

尽管OpenAI GPT-4o、Google Gemini等私人模型在这一领域取得了显著进展,目前的开源模型在效果、计算费用、运行效率等方面仍然存在明显的不足。

近日,智源研究院与上海交通大学等机构合作,正式发布了新一代超长视频理解模式:Video-XL-2。与上一个版本相比,Video-XL,该模型在多维度上全面优化了多模态大模型对长视频内容的理解能力:

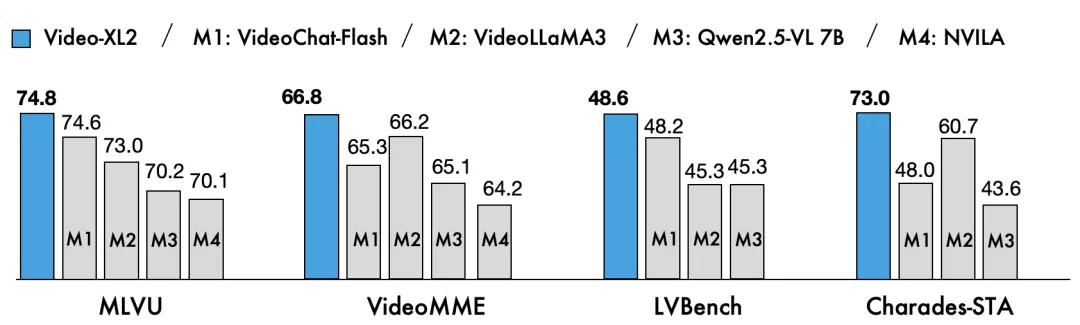

- 效果更好:Video-XL-2MLVU在长视频理解任务中表现出色,、Video-MME、在同参数规模开源模型中,LVBench等主流评价标准处于领先地位。

- 长度更久:新型显著扩展了可处理视频的时间,支持对长达万帧的视频输入进行高效处理。

- 速度更快:Video-XL-2大大提高了处理效率,2048帧视频编码只需12秒,显著加快了长视频理解过程。

目前,Video-XL-2模型权重已经全面向社区开放。未来,该模型有望在影视内容分析、行为问题监测等多个实际场景中展现出重要的实用价值。

项目首页:https://unabletousegit.github.io/video-xl2.github.io/

模型HF链接:https://huggingface.co/BAAI/Video-XL-2

库房链接:https://github.com/VectorSpaceLab/Video-XL

技术简介

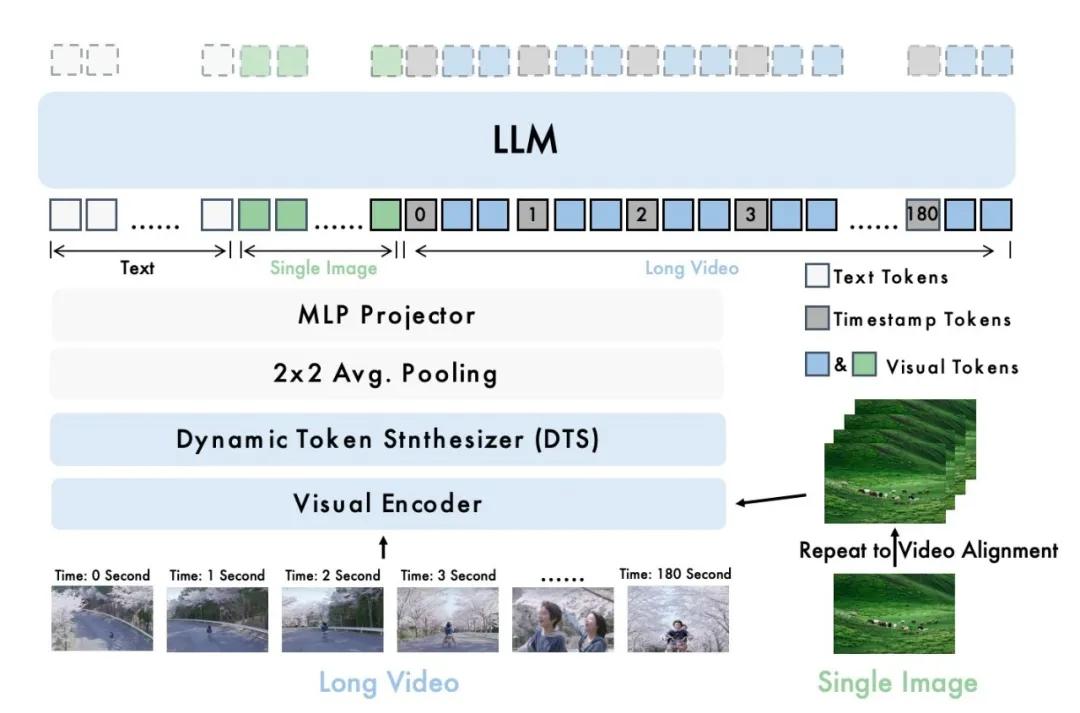

图1:Video-XL-2模型架构示意图

就模型架构模式而言,Video-XL-二是主要由三个核心部件组成:视觉编码器(Visual Encoder)、动态Token生成模块(Dynamic Token Synthesis, DTS)还有大语言模型(LLM)。

具体来说,Video-XL-2选择SigLIP-SO400M作为视觉编码器,逐帧处理输入视频,将每一帧编码为高维视觉特征。

随后,DTS模块将这些视觉特征融合压缩,并对其时序关系进行建模,从而提取更具语义的动态信息。

通过平均池化和多层感知机处理的视觉表征(MLP)进一步映射文本嵌入空间,实现模式对齐。最终,将对齐后的视觉信息输入到Qwen2.5-Instruct,从而实现对视觉内容的理解和推理,并完成相应的下游任务。

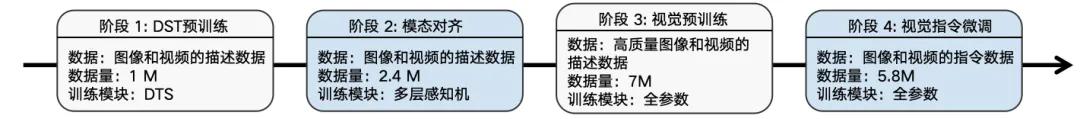

图2:Video-XL-2练习阶段示意图

就实践策略而言,Video-XL-2使用了第四阶段渐进训练设计,逐步构建其强大的长视频理解能力。

前两阶段主要使用图像/视频-文本对,完成初始化和跨模式对齐DTS模块;

三是引入更大规模、更高质量的图像和视频描述数据,初步确定模型对视觉内容的理解能力;

四是对大规模、高质量、多样化的图像和视频指令数据进行微调,使Video-XL-2的进一步提高和强化视觉理解能力,这样就能更准确地理解和响应复杂的视觉指令。

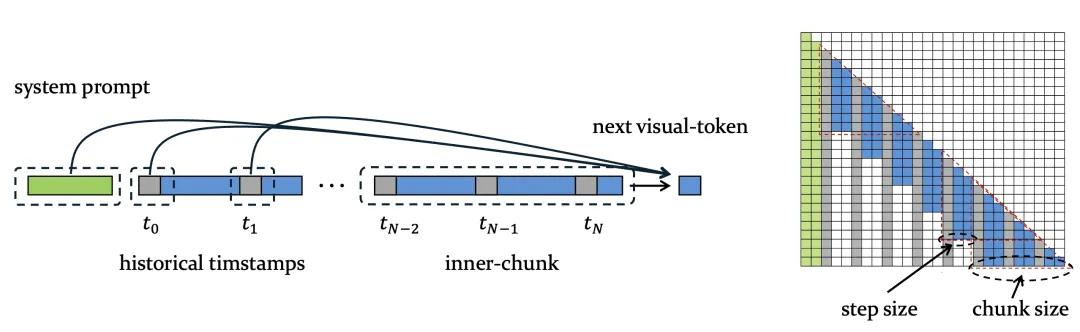

图3. Chunk-based Prefilling

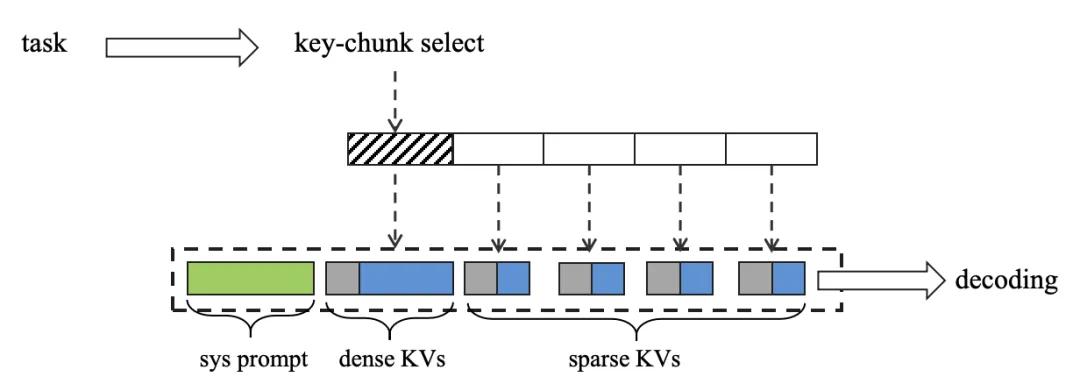

图4. Bi-granularity KV Decoding

此外,Video-XL-2还系统地制定了效率优化措施。。

首先,Video-XL-2引进了分段预装填料策略(Chunk-based Prefilling,如图3所示):将超长视频分成几个连续的片段。(chunk),密集的注意力机制用于每一个chunk内部的编码,而不同的chunk则通过时间戳传递上下文信息。

这种设计显著降低了预装填阶段的核算成本和显存费用。第二,Video-XL-2还设计了基于双粒KV的解码机制(Bi-granularity KV Decoding,如图4所示):在推理过程中,模型会根据任务需要有选择地将完整的KVs载入关键片段。(dense KVs),而且其它次要片段仅载入降降采样后稀疏的KVs。(sparse KVs)。

这种机制有效地缩短了推理窗口的长度,从而大大提高了解码效率。得益于上述策略的协同优化,Video-XL-二是在单张显卡中对万帧级视频进行高效推理,显著提高了其在实际应用场景中的实用性。

试验效果

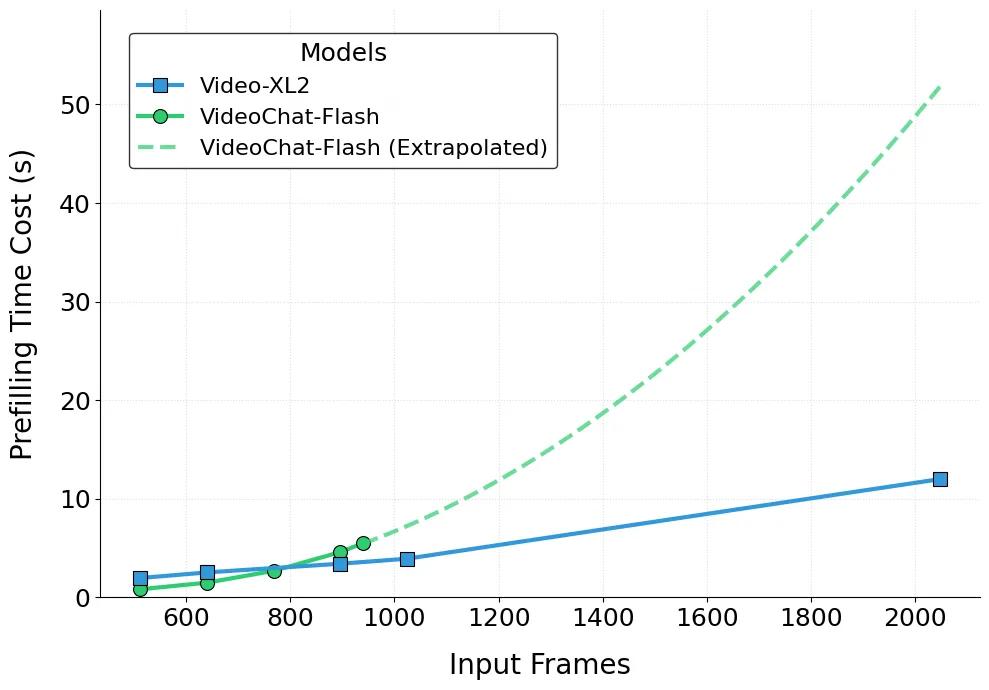

图5:Video-XL-二是主要对比结果

表1:Video-XL-二是全面对比结果

就模型的主要表现而言,Video-XL-2在MLVU、主流长视频评价标准,如VideoMME和LVBench,全面超越当前所有轻量级开源模型,实现当前最先进的性能(SOTA),与第一代Video-XL相比,显著改善。

特别值得注意的是,在MLVU和LVBench上,Video-XL-Qwen2.5-VL-72B和LLaVA-Video-数据规模高达720亿的大模型,如72B。

另外,时序定位(Temporal Grounding)任务时,Video-XL-2在Charades-STA数据方面也表现出色,进一步验证了它在多模态视频理解场景中的普遍适用性和实际价值。

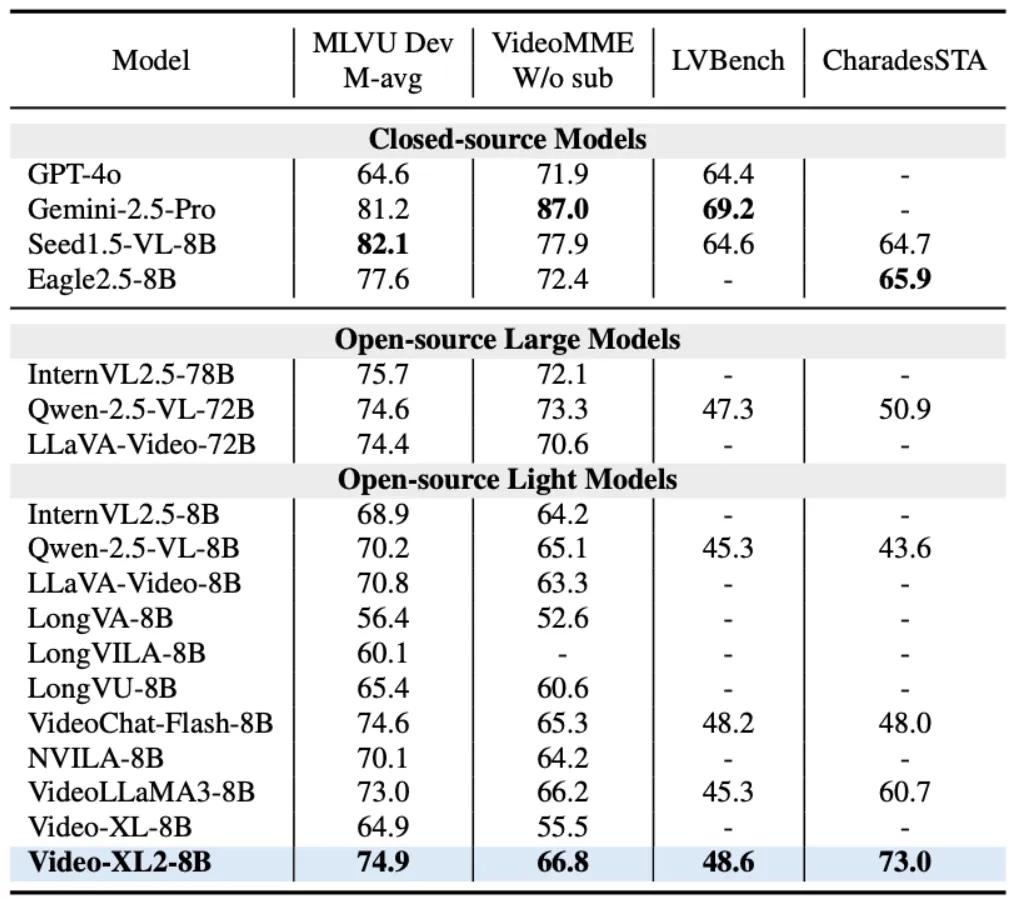

图6:Video-XL-2输入长度对比展示

除提高效果外,Video-XL-2在视频长度方面也表现出显著优势。。

如图6所示,单张24GB消费级显卡(例如RTX) 3090 / 4090)上,Video-XL-2可以处理近千帧的视频;但是在单张80GB高性能显卡(例如A100 / H100)上,模型更支持万帧视频输入,远远超过当前主流开源模式。

与VideoChat-Flash和第一代Video相比,-XL,Video-XL-2视频理解的长度明显扩大,资源需求有效减少,为处理复杂的视频任务提供了有力支持。

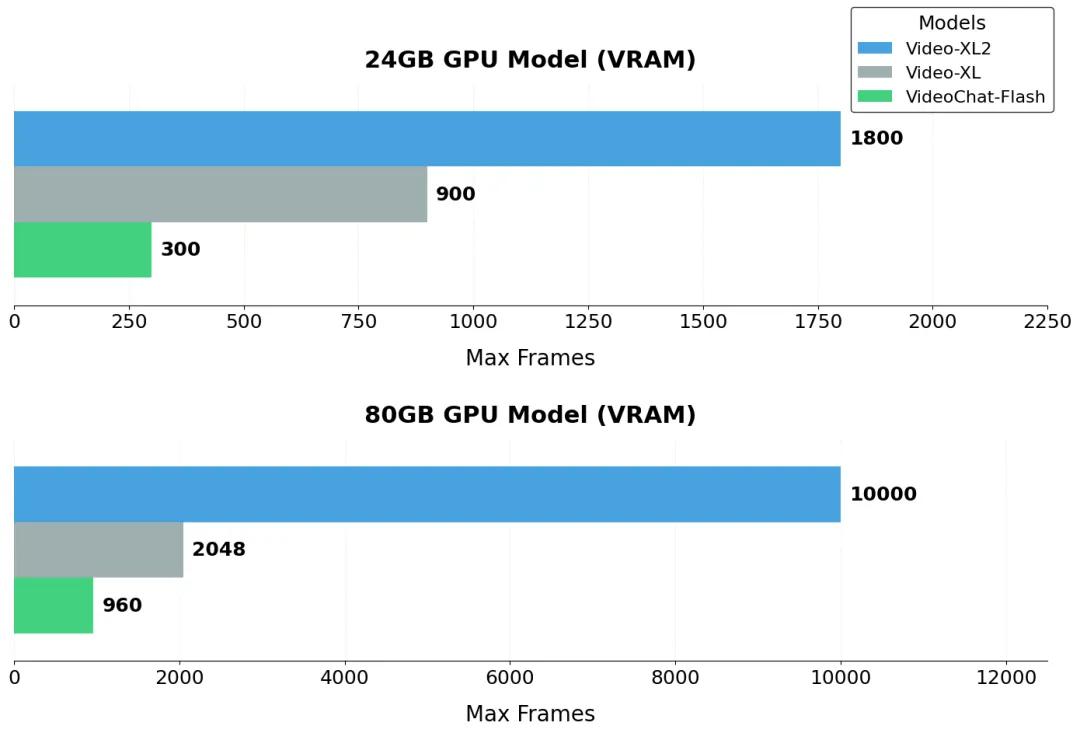

图7:Video-XL-2 对比展示Prefilling速率

图8:Video-XL-2 Prefilling速度和输入帧数之间的关系

最终,Video-XL-2在速度方面也表现出卓越的性能。。如上图8所示,Video-XL-预填2048帧视频只需12秒即可完成。

此外,其预填充时间与输入帧数之间也呈现出类似的线性增长,体现了其优异的可扩展性。

相比之下,Video-XL与VideoChat-在输入长视频时,Flash的工作效率明显落后于Video-XL-2。

应用潜力

下面是一些具体的例子,将显示Video-XL-2在实际应用中的巨大潜力:

Example 1:电影情节问答

Question:A bald man wearing a green coat is speaking on the phone. What color is the phone?

Answer:The phone’s color is red

Example 2:监测异常检测

Question:Is there any unexpected event happening in this surveillance footage?

Answer:There is physical altercation between the customers and the store employees

Example 3: 总结影视剧内容

Example4:总结游戏直播内容

得益于优秀的视频理解能力和高效处理超长视频的性能,Video-XL-2在各种实际应用场景中显示出极大的应用潜力。

例如,它可以广泛应用于影视内容分析、情节理解、监控视频中的异常行为检测和安全预警等任务,为现实世界中复杂的视频理解需求提供高效、准确的技术支持。

本文来自微信微信官方账号“新智元”,编辑:定慧 Aeneas,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com