国家超级计算互联网平台推出长文本、多模式、大模式,帮助AI智能体开发

伴随着越来越多的智能体(Agent)进入应用领域,无论是单个智能体工作时产生的记忆,还是多个智能体合作产生的前后文本,都会对大模型的前后文本窗口长度提出更高的要求。澎湃科技4月15日获悉,国家超级计算互联网平台近日推出了由上海稀宇科技有限公司(以下简称“稀宇科技”)研发的长文本多模式模型,分别为MiniMax-Text-MiniMax和Mini-VL-01。

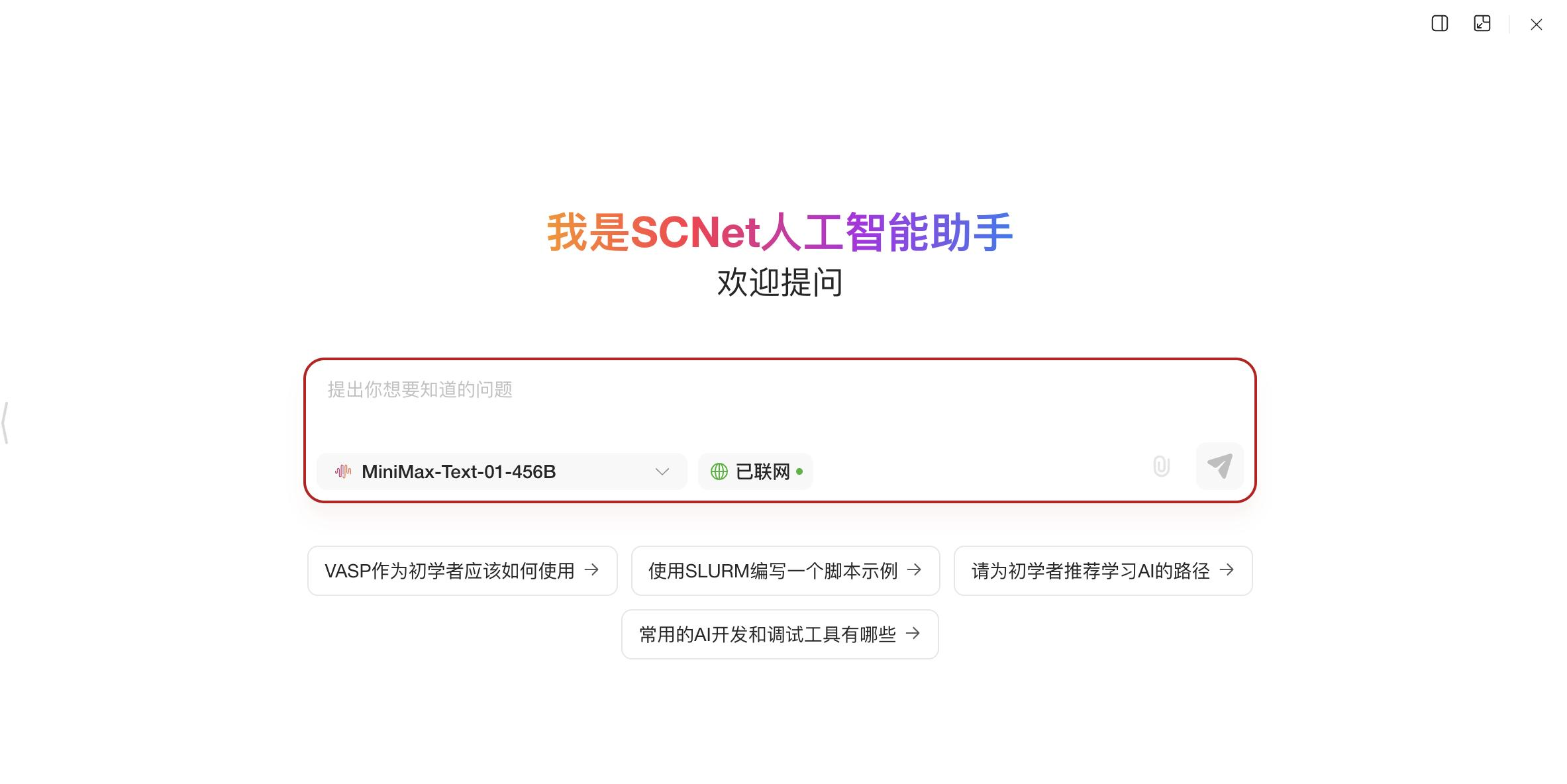

chat页面截图SCNet超算网络平台 来源:MiniMax供图

作为国家计算率服务平台,国家超级计算互联网于2024年4月正式上线。今年2月,“AI生态合作伙伴加快计划”启动,提供3个月的DeepSeek。 通过技术赋能、市场协调、资源帮扶三位一体,鼓励API界面免费使用、千万卡时算率资源池等,加快生态合作伙伴全面发展。

数据显示,自上线一年以来,国家超级计算互联网平台用户总数已超过35万,连接了全国14个省、自治区、直辖市20多个超级计算和智能计算中心,上线计算率超过6500款。澎湃科技注意到,近240款AI模型服务,包括阿里通义千问Qwen、国内开源模型,如DeepSeek,也有Llama、Stable Diffusion、国外AI开源模型,如Gemma。

稀宇科技认为,该企业与国家超级计算互联网平台的合作,可以激发更多关于长期文学技术的创新研究和实践应用。提高长期文学能力和多模态处理能力,有利于智能体为各行业带来更丰富、更高效的解决方案。

"放眼国内外的大模型,‘大脑’虽然大,但是‘记忆’通常是不够的。”稀宇科技R&D负责人表示,“如果让大模型了解一份近1000页的法律合同、一部经典小说或几十万行源代码项目,并给出准确的摘要、潜在的风险发现和结构化建议,大多数大模型都无法完成任务,因为它甚至无法阅读材料,更不用说音视频等多模态信息处理了。而且MiniMax-01可以做到,因为它的前后文窗口大约有700万字,相当于一下子读完了中国四大文学名称和哈利波特全集。”

据悉,MiniMax-01是今年年初发布并开源的新一代系列模型,首次将线性注意机制扩展到商业模型水平,综合能力位居世界第一梯队。特别是在“前后文长度”这一指标上,它达到了国内外一些顶级模型的20-32 在推理过程中,前后文窗口可以达到400万token(词元)。在架构上,MiniMax-Text-练习与推理系统几乎重构,模型参数高达4560亿,每次激活459亿。就注意力机制而言,其80个注意层具有结构创新,使得大型模型在处理长输入时,在保证处理效果的同时达到低延迟。这就是说,这个模型不仅可以一次完成大量的文字分析,而且可以真正理解和有效地处理更长的内容。

MiniMax加入国家超级计算互联网,将充分利用平台强大的计算资源、开放合作的生态模式和一般的开发者网络。稀宇科技认为,“这种合作不仅可以激发更多关于长期和后期文学技术的创新研究和实践应用,促进Agent时代的快速到来,还可以通过开源进一步激励我们开发和创新更深入、更高质量的模型。“未来,公司将继续以开源的方式发布新的旗舰模型,与国家超级计算互联网进行深入合作,共同推动国内人工智能技术的加速发展。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com