谷歌半夜甩出AI芯片野兽!TPU最强计算率飙升,可以运行推理模型,内存飙升。

谷歌称 AI “推理时代”已经迎来。

作者 | 陈骏达

编辑 | 心缘

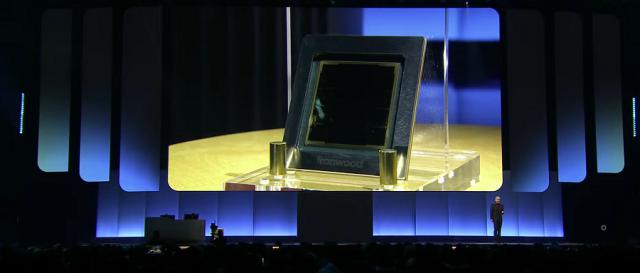

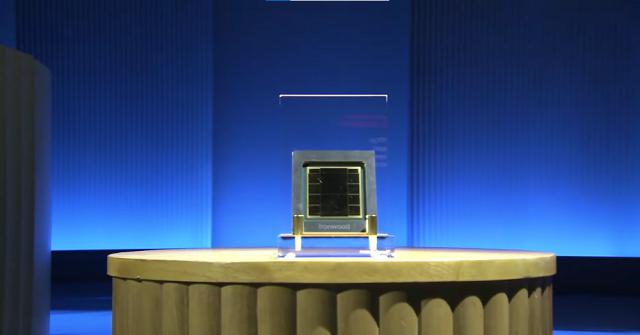

芯物品 4 月 10 日报今天,谷歌云 Next 谷歌在大会上发布第七代 TPU 芯片 Ironwood。谷歌机器学习,系统和云 AI 副总裁兼总经理 Amin Vahdat 称,Ironwood 它是谷歌迄今为止最强大、最节能的。 TPU,专门为支持大规模应用思维、推理模型而设计。

每块 Ironwood 芯片的峰值算率为4614 TeraFLOPS(第六代 TPU 芯片 Trillium 的 5 倍数),内存高达192GB(Trillium 的 6 倍);HBM 带宽达到7.2 Tbps(Trillium 的 4.5 倍);它的每瓦峰值算率为29.3 TeraFLOPS,是 Trillium 的 2 倍多。

通过芯片间的相互连接(ICI)网络,Ironwood 实现1.2 Tbps双向带宽的芯片间,最多可以扩展到 9216 由液体冷却芯片组成 Pod,终于力达42.5 ExaFLOPS,现在是世界上最大的超级计算。 El Capitan 算力的24 倍多。

对谷歌云客户而言,Ironwood 提供两种尺寸:256 芯片配置和 9216 芯片配备。开发者也可以使用谷歌。 Pathways 管理成千上万的软件堆栈 Ironwood TPU 综合计算能力。全面推出的 Cluster Director 使用者可对具有计算、存储和网络功能的大型加速虚拟机集群进行部署和管理。

谷歌称,Ironwood 代表着 AI 从提供实时信息供人类解读的响应式方式来看,基础设施的发展迎来了重大变化。 AI,转化为主动生成解读 AI 模型,迎来“推理时代”。

Ironwood 其目的是“优雅管理”思维模式复杂的计算通信需求,包括大语言模型(LLM)、混合专家模型(MoE)这些需要大规模并行计算和高效访问的场景,如高级推理任务。

具体来说,Ironwood 在实施大规模张量操作的同时,可以最大限度地减少芯片上的数据移动和延迟。

由于顶级思维模式的计算需求远远超过了单个芯片的容量,谷歌是 Ironwood TPU 低延迟、高带宽的配置 ICI 互联网,以支持全部 TPU Pod 协调同步通信规模。

Ironwood 还配有增强版 SparseCore 专用加速器,可以用来处理高级排名和推荐任务中常见的超大嵌入。增强版 SparseCore 从传统的角度来看,可以加快更多领域的任务。 AI 将任务扩展到金融、科学等领域。

在会议现场,谷歌云宣布他们将很快推出。A4X 和 A4 VMs(虚拟机),由英伟达 GB200 NVL72 和 B200 Blackwell GPU 谷歌云也将成为首批提供算率支持的公司 Vera Rubin GPU 云服务制造商。

英伟达创始人兼 CEO 特别是黄仁勋的谷歌云 Next 会议录制了一段视频。他说,英伟达和谷歌云的“非常战略合作伙伴关系”包括计算的各个方面。英伟达将与谷歌云一起推出加密计算服务,面向全球高监管、高风险行业客户。

Ironwood 的发布正值 AI 芯片业的竞争日益激烈。尽管英伟达在这一领域处于领先地位,但是包括亚马逊和微软在内的科技巨头也纷纷推出了自己的内部解决方案。亚马逊通过 AWS 提供了 Trainium、Inferentia 和 Graviton 处理器,而微软则是它的处理器 Cobalt 100AI 芯片提供 Azure 案例。

随着 AI 与行业、场景的融合越来越深入,谷歌正在通过 Ironwood 等待推理情景专用硬件的投资,为这个未来做好充分准备。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com