为什么数据治理比以往任何时候都更重要:网络泡沫破裂对于人工智能时代的教训

当今世界再次陷入技术革命的漩涡。就像20 世纪 90 时代末的互联网热潮希望能改变企业,今天的企业。人工智能爆炸式增长以前所未有的速度重塑行业。创业公司获得的资金创下历史新高,人工智能产品迅速推向市场,组织正以惊人的速度将人工智能融入其运营。

然而 ,历史给我们留下了警告。

互联网时代充满了兴奋、投机和快速增长——直到2000 年度泡沫破裂,市值蒸发 5 亿美元。许多公司因特网不是革命性的,而是因为它们缺乏可持续的基础。

如今,我们看到人工智能领域惊人的相似方法:大规模投资,不受监管的创新,对非结构化、不可靠数据的过度依赖。有什么不同?人工智能完全基于数据。要是没有适当的治理与管理,人工智能不但会失败,而且会引起广泛的发展。金融与法律的道德、金融困境。

问题是:是否会从历史中吸取教训?还是意识到根本的不同?

因特网泡沫期间发生了什么?

20 世纪 90 20世纪90年代末,互联网公司发展迅速。投资者向没有真正商业模式的创业公司倾注了数十亿美元,希望从数字革命中获利。

承诺:因特网将使信息收集民主,改变传统产业,创造新的经济机遇。

现实:到 2000 2008年,炒作远远超过了实际价值。许多企业倒闭了,无法将其推向它的平台货币化,高效地管理数据,或者建立可持续运营。

网络泡沫在现实生活中的失败案例:

1.Pets.com——

这家公司在广告上花费了数百万美元,但是没有真正的策略来管理供应链数据和客户分析。两年之内就破产了。

2.Webvan——

一家在线杂货服务公司,扩张速度过快,缺乏对物流和库存数据的管理。这家公司在破产之前就已经消耗了。 10 亿美金。

3.eToys——

未能有效地管理客户数据,并且由于缺乏治理而做出错误的决定,导致破产。

导致崩溃的关键错误:

数据管理不善

——公司收集了大量数据,但缺乏数据。 数据处理框架 保证质量、可靠性和合规性。

过度炒作的可持续性

——就像今天的人工智能创业公司追求快速应用一样,公司在没有稳定的商业模式的情况下匆忙进入市场。

缺乏监督和认可

——在他们变成灾难之前,隐私和安全漏洞被忽略了。

生存教训:只有将数据视为战略资产,并制定强大的治理结构。公司(如亚马逊和) eBay)可以变得更加强大

人工智能如何重复因特网泡沫?

人工智能是一种新的淘金热。各组织竞相学习机器和大型语言模型 (LLM) 和自动化将其纳入商业战略。但是如果没有强大的在数据治理方面,人工智能可能会陷入与网络时代相同的陷阱。

人工智能和因特网热潮:相似之处和差异

人工智能类似于因特网泡沫。

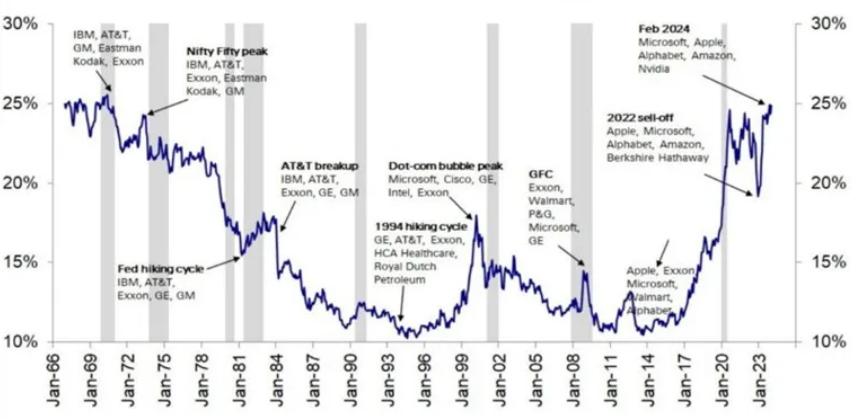

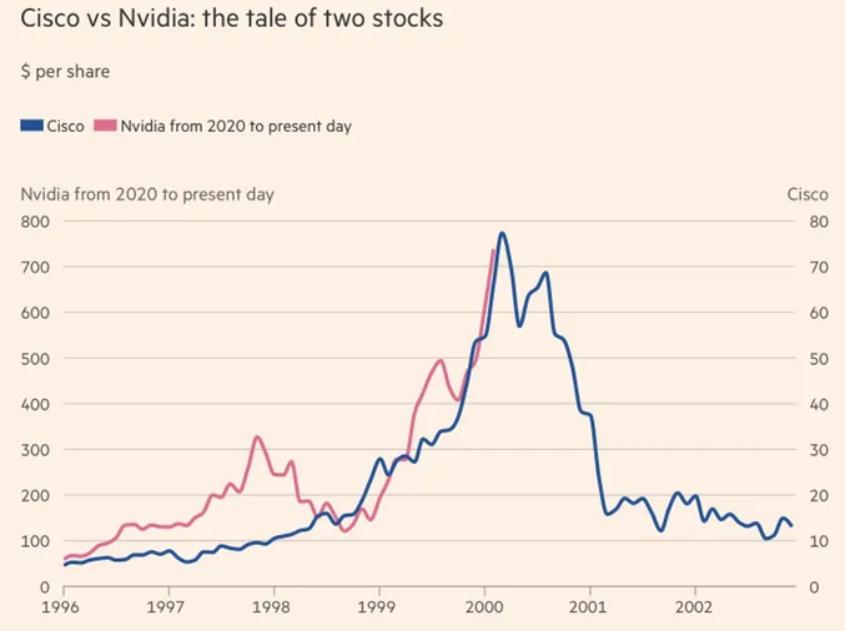

指数增长和市场炒作人工智能和因特网泡沫都经历了投资的迅速涌入,企业估值基于未来的潜力而非实际利润。例如,Nvidia 人工智能领域股价的飙升,反映了互联网时代思科的崛起,两者都被认为是各自繁荣阶段的重要基础设施提供商。

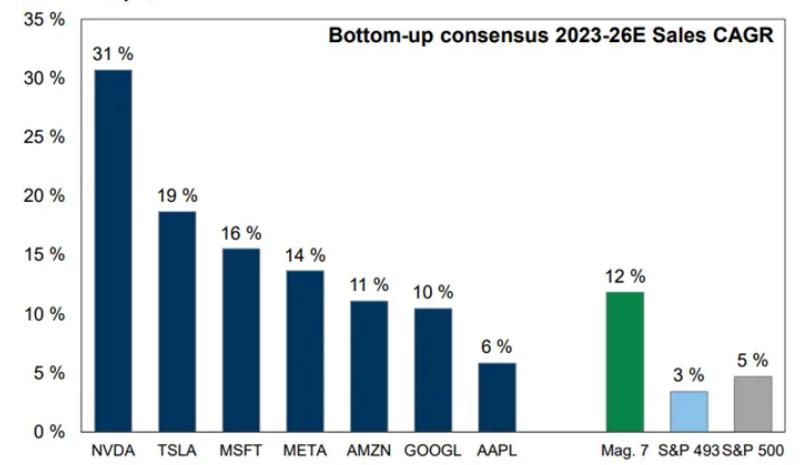

投机投资和市场投机就像纳斯达克一样。 20 世纪 90 年代末飙涨同样,今天由人工智能驱动的企业——尤其是七巨头(苹果,微软,英伟达,谷歌,亚马逊,特斯拉,Meta)——市场反弹正根据未来人工智能的潜力推动。

⚠️控制追求和道德问题20 世纪 90 在时代,各国政府都在努力控制互联网,就像他们现在正在努力解决这个问题一样。与数据隐私法相同,人工智能道德、偏见。在网络泡沫期间,人工智能治理仍是一个不断发展的领域,就像数字法律的滞后一样。

市场崩溃缺乏治理的风险超越投机活动时当真正的创新和可持续的商业模式时,就会产生经济泡沫。目前很多人工智能创业公司在运营过程中没有经过验证的收入模式,导致估值过高,市场潜在调整。担忧。

人工智能与因特网泡沫的主要区别

- 与因特网企业不同,经济和商业模式的成熟程度 Nvidia、微软和谷歌等待人工智能的领导者已经建立高利润的人工智能驱动业务。人工智能不仅是一种新的趋势,也是医疗卫生、金融和自动化产业的重要组成部分。

- AI 可观的收益正在产生。Nvidia等公司因为 AI 与互联网高峰时期的思科不同,芯片需求已经实现了创纪录的收入增长。在云计算、自动化和分析领域 AI 应用程序具有实时盈利能力,而非投机性的未来收益。

- 控制是主动的,而非被动的。全世界的政府都在积极制定人工智能政策,欧盟人工智能法案,美国人工智能权利法案和 GDPR 修订旨在危机发生前避免乱用人工智能,这不同于因特网泡沫破灭期间的缓慢控制反应。

- AI 不只是数字工具,而是行业变革者。虽然因特网已经完全改变了公司的联系方式,AI 行业运作模式正在从根本上改变。从预测分析金融领域到医疗保健领域由 AI 驱动药物研发,AI与因特网时代相比,企业更深入地融入日常运营。

不受监管的人工智能风险日益增加

尽管人工智能的基础比较牢固,但是风险并没有完全消除。保证人工智能长期成功的重要因素仍然是数据治理。

1. 数据质量差将被破坏 AI 模型AI 这取决于数据的训练。若数据有出入、过时或不一致,AI 这个决定会有缺陷。

?例:亚马逊开发了一种人工智能招聘工具,系统地降低了女性候选人的排名,因为培训数据有偏见。如果没有治理,人工智能可能会加剧歧视,而不是消除歧视。

2. 监管当局已经开始严厉查处乱用人工智能行为,合规与法律纠纷不断上升。只是 GDPR 罚款已经超过了 40 亿美元,欧盟的《人工智能法案》也将受到严格控制。

?例子:人脸识别企业 Clearview AI 由于未经同意抓取数据而面临诉讼,导致多个国家处以罚款和禁令。

3. 人工智能的道德和偏见会损害信任。从医疗健康到金融,人工智能正在做出关键决策。如果没有治疗,这些系统可能会产生有害或不道德的结果。

?例子:微软 AI 聊天机器人 Tay 在被客户操纵发布种族主义和攻击性内容之后, 24 在一小时内关闭。由于缺乏实时监控和治理,它变得脆弱。

4. 公司面临竞争和财务风险。人工智能管理不当可能导致顾客不信任,声誉受损,财务损失。没有强大的治理框架投资人工智能组织可能会失去市场声誉。

5. 监管风险:麦肯锡 2023 一项年度研究发现,70% 由于数据治理不善,人工智能模型失败。

为什么数据治理是人工智能成功的关键?

与网络时代不同,我们有机会。正确看待人工智能——但这需要把数据当作战略资产,而非后来考虑的事。

如何避免人工智能的数据治理崩溃:

1. 数据质量和继承控制——组织需要明确治理政策来跟踪 AI 资料来源,如何处理,如何影响决策。

2. AI 合规与风险控制——企业必须使 AI 模型与 GDPR、CCPA 以及即将推出的 AI 为了防止法规保持一致,法律和经济处罚。

3. 人工智能道德与偏见审计——实施偏见检测和透明机制可以保证人工智能的维护公平合理。

4. 持续的人工智能监控与管理——随着时间的推移,人工智能模型必须是监测、审查和改进——而不仅仅是推出后被遗忘。

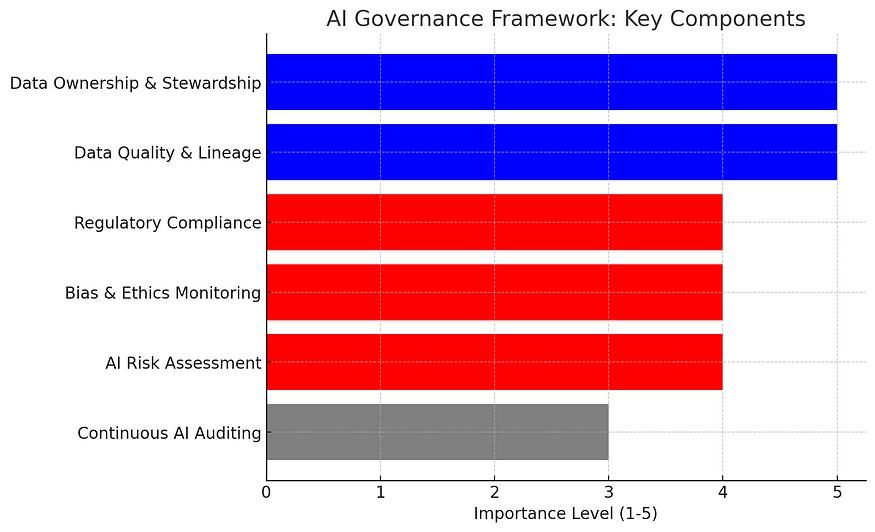

实施 AI 治理框架:1️⃣ 建立一个团队资料所有权和责任制。2️⃣保证数据质量、可靠性和继承跟踪。️⃣实施AI 风险评估与偏见审计。四️⃣使 AI 计划与保持全球法律法规和道德标准一致。5️⃣持续监控、检测和更新AI 保证模型的性能和合规性。

本文来自微信微信官方账号 “数据驱动智能”(ID:Data作者:晓晓,36氪经授权发布,_0101)。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com