生成数据的前景和风险

AI 有没有可能只用另一个? AI 训练生成的数据?这听起来可能很愚蠢。但是这个想法已经存在了相当长的时间——这个想法越来越受到重视,因为真正的新数据越来越难获取。

Anthropic 用一些生成数据来训练他们中的一个旗舰模型。 Claude 3.5 Sonnet。Meta 也使用 AI 生成的数据是针对他们的 Llama 3.1 模型进行了微调。有人说,为即将推出的模型。 Orion,OpenAI 正在从其 “推理 ”模型 o1 获得生成训练数据。

可是,为何 AI 首先需要数据-它需要什么样的数据?这些信息真的可以用生成数据来代替吗?

注明的重要性

AI 系统是一台统计机器。在使用大量案例进行练习后,他们可以学习这些案例中的方法并做出预测,例如电子邮件。 “to whom"通常会出现在那里 “it may concern”之前。

在这些例子中,标记是一个关键部分。这里的标记通常是指一些文本来表示系统获得的数据的含义或内容。他们充当路标,“教堂 ”模型如何区分事物、地点和想法。

想象一下这样一个场景:为一个图像分类模型提供大量标记。 “厨房 “厨房图片的字样。模型将在训练过程中进行。 “厨房 “与厨房的一般特征(例如,厨房里有冰箱和台面)联系在一起。经过训练,提供一张厨房照片,没有集中在初始示例中,模型应该可以识别出来。(当然,如果厨房的照片被标记为 “乳牛”,模型也将其识别为乳牛,这就凸显了标注的重要性。)

对 AI 需求和需求是 AI 开发需要标注数据,促进标注服务市场的快速发展。据 Dimension 市场研究公司估计,目前标注服务市场的价值是什么? 8.382 十亿美元,未来 10 年将达到 103.4 亿美金。尽管对有多少人从事标注工作没有一个准确的估计, 2022 每年一份文件指出,这个数字是 “百万级”。

各种规模的企业都依靠数据来标记企业雇佣的工人。 AI 培训数据集设置标签。有些工作的工资还可以,尤其是需要专业知识(比如数学专业)来标注工作的时候。其他工作很辛苦。在发展中国家,标记员的平均小时工资只有几美元,没有任何福利或未来工作保障。

数据井正在干涸

所以,从人文学的角度来看,我们有理由为人工生成标签而寻找替代方案。例如,Uber 从事人工智能标注和数据标注工作的零工团队正在扩大。

这样做还有一些务实的原因。人类的标记速度有限。标记者也会有偏见,这些偏见可能体现在他们的标记中,从而体现在所有用这些标记练习的模型中。标记者会犯错,或者被标记表示困惑,花钱请人做这件事的成本很高。

总体而言,信息是昂贵的。Shutterstock 向 AI 供应商向图片库收取数千万美元的服务费, Reddit 然后通过谷歌,OpenAI 获得数亿美元的授权数据与其他公司。

最后,数据也越来越难获取。

大多数模型都是在大量的公共数据集中训练出来的——因为担心数据会被抄袭。 或者不能获得信用或者签名,所以越来越多的数据所有者选择屏蔽这些信息。现在,世界排名第一 1000 位置网站中,超过 35% 网站屏蔽了 OpenAI 的 Web 爬虫。最近的一项研究发现,模型训练中使用的主要数据集大约是 25% 的 高质量的数据库受到限制。

据科研机构 Epoch AI 估计,如果当前的浏览封锁趋势持续下去, 2026 年至 2032 2000年间,开发人员将无数据用于培训生成式。 AI 模型,加上对版权诉讼和开放数据集中出现不良内容的焦虑,AI 供应商必须进行反思。

用生成数据代替

乍一看,生成数据似乎可以解决所有这些问题。需要标记吗?生成它们。需要大量的示例数据?没问题。

这在某种程度上确实是事实。

Os Keyes 是华盛顿大学研究前沿技术伦理影响力的博士生。他说:“如果‘信息是新石油’,那么生成的数据就是生物燃料,可以创造,没有真正的东西是负外在的。一开始可以从一个小数据开始,模拟推断新的数据内容。”

AI 行业已经把这个概念付诸行动。

Writer 它是一家专注于企业级生成的人工智能企业。这个月,他们首次推出了一个模型 Palmyra X 004。这个模型几乎完全是通过生成数据训练出来的。Writer 声称,该模型的开发成本仅仅是 70 一万美元,相比之下,规模相当大。 OpenAI 估计模型需要 460 万美金。

微软开放模式 Phi 生成数据也部分用于练习。谷歌的 Gemma 模型也是如此。今年夏天,英伟达发布了一系列旨在生成和生成训练数据模型, AI 初创公司 Hugging Face 于于于最近发布了一条消息。 合成文本最大 AI 训练数据集。

生成数据生成本身已成为一项业务- 2030 一年,它的价值可以达到 23.4 一亿美元。Gartner预测,今年,人工智能和分析项目将使用数据。 60% 是生成的。

Allen 人工智能研究所高级研究科学家 Luca Soldaini 指出,生成数据技术可以用来生成不易通过的数据。 Web 抓取训练数据(甚至内容许可)获取。例如,在练习它的视频生成器。 Movie Gen 时,Meta 就使用 Llama 3 为了在训练数据中建立视频短片的字幕,然后人类可以改进和添加更多的细节,比如灯光描述。

同样,OpenAI 他们还表示,他们使用生成数据。 GPT-4o 进行微调,为 ChatGPT 构建类似的素描板 Canvas 功能。亚马逊还表示,它们生成了一些生成数据,用于训练语音识别模型,作为真实世界数据的补充。 Alexa。

Soldaini 据说,“根据人类的直觉,生成数据模型可以实现特定模型行为所需的数据-快速扩展数据。”

生成数据的危险

但是,生成数据并非万能的。以及一切。 AI 同样,它也存在 “垃圾进出垃圾”的问题。模型会产生生成数据,但如果用来训练这些模型的数据存在偏差和局限性,它们的输出结果也会受到同样的影响。例如,在数据中没有得到很好反映的人在生成信息中也是如此。

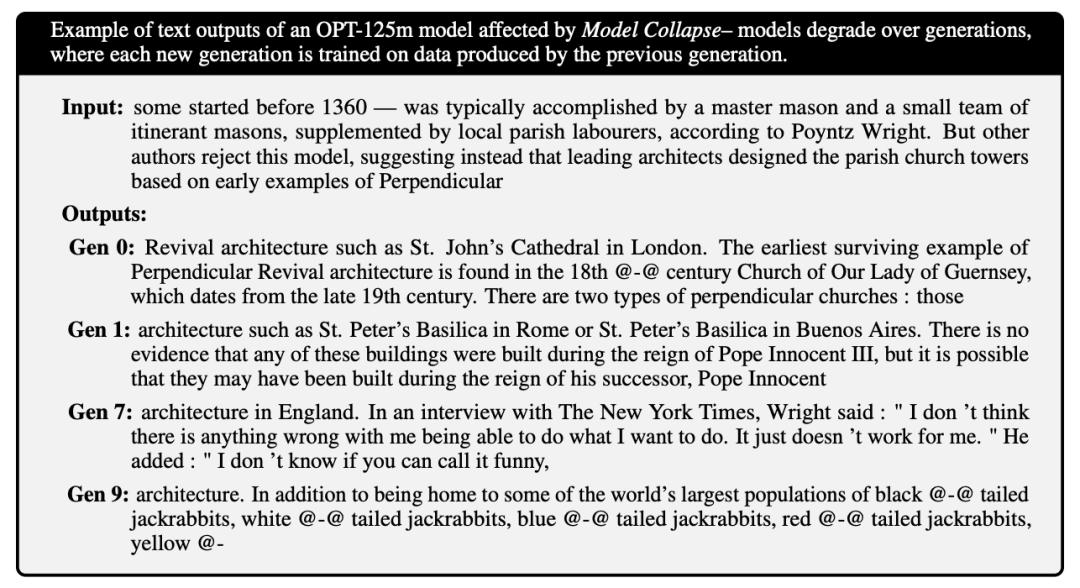

在这一点上,2023 2008年,莱斯大学和斯坦福大学的研究人员在一个项目中 研究 在训练过程中,发现过度依赖生成数据会导致模型 “质量或多样性逐渐下降”。研究人员表示,采样误差——不能很好地反映现实世界——经过几代人的训练,模型的多样性会恶化(但他们也发现,混合一些现实世界的数据有助于缓解这个问题)。

Keyes 感觉,对于像 OpenAI o1 这种复杂的模式还有其他风险。他认为生成数据会导致这些模型产生难以找到的幻觉。另一方面,这些幻觉会降低使用这些信息训练出来的模型的准确性,尤其是在幻觉来源难以识别的情况下。

Keyes 补充说:“复杂的模型会产生幻觉;复杂模型产生的数据也会包括幻觉。至于像 o1 这种模式,开发者自己可能无法解释它为什么会产生幻觉。”

各种幻觉叠加会导致模型胡说八道。《自然》杂志上发表了一项研究,揭示了用错误的数据训练出来的模型是如何产生更多错误的数据的,以及这个反馈循环是如何导致后代模型衰退的。研究人员发现,随着模型几代人的训练,他们会失去一些深刻的知识——变得更泛泛而谈,经常会产生与问题无关的答案。

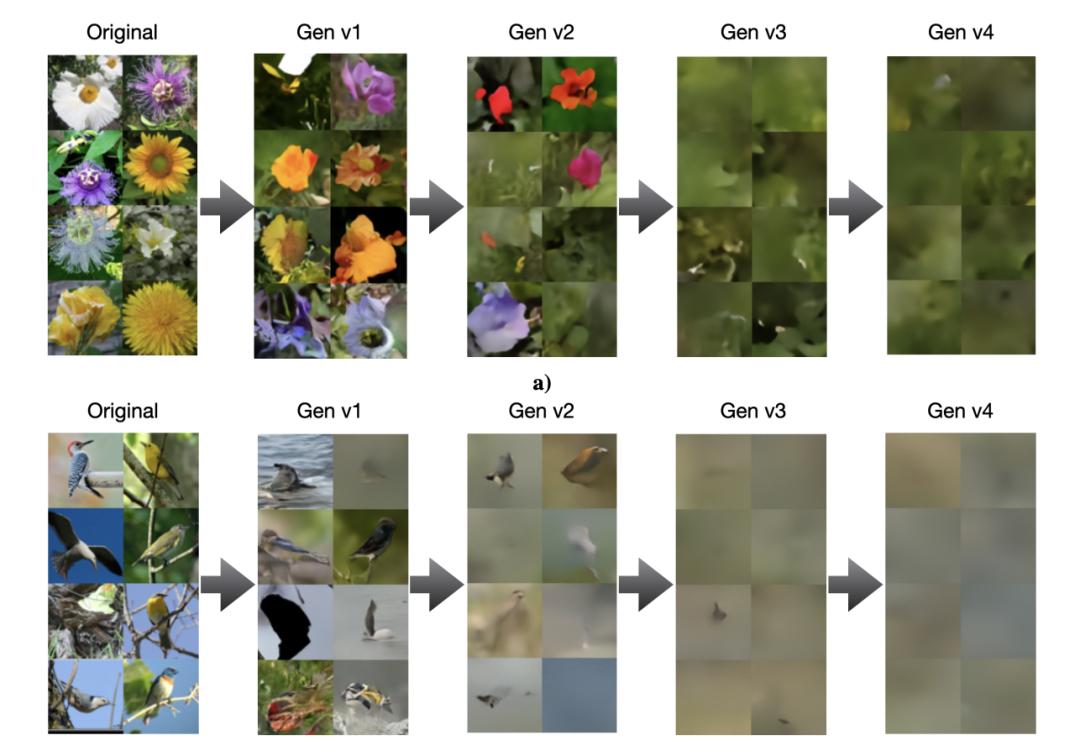

一项后续研究发现,其它类型的模型,如图像生成器,也不能幸免于此类崩溃:

Soldaini 还认为,“原始”生成信息是不可信的,以避免训练健忘的聊天机器人和同质化的图像生成器。他认为,有必要 使用“安全”生成数据时,必须彻底审查、整理和过滤,最好与新获得的真实数据一起使用,就像使用其他数据一样。

若做不到这一点,最终可能导致模型崩溃,即模型崩溃, “创造性 “减少,输出结果更有偏见,最终严重影响其功能。虽然在情况变得更糟之前可以识别和阻止这个问题,但这是一种风险。

“研究人员需要检查生成的数据,迭代生成过程,并采取一些安全措施去除低质量的数据点。生成数据管不是自我完善的设备;在将其导出进行训练之前,必须仔细检查和优化。”Soldaini 说道。

OpenAI CEO Sam Altman 曾想到,AI总有一天会发生。 会产生足够有效的合成数据来训练自己。然而,即使这是合理的,也不会有这种技术。目前还没有大规模的。 AI 只使用生成数据训练模型进行实验室发布。

至少在可预见的未来,我们似乎需要人类来确保模型训练不会出错。

原文链接:

https://techcrunch.com/2024/12/24/the-promise-and-perils-of-synthetic-data/

本文来自微信微信官方账号“AI前线”(ID:ai-front),作者:Kyle Wiggers,翻译:平川,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com