OpenAI 活动第二弹:“加强微调”建设领域专家 AI 模型

IT 世家 12 月 7 日消息,OpenAI 启动了历时 12 天" shipmas “新产品发布周期,将推出一系列新功能、新产品及相关演示。第二天,OpenAI 引入了强化微调(Reinforcement Fine-Tuning),协助开发者和机器学习工程师为特定复杂领域的任务创建专家模型。

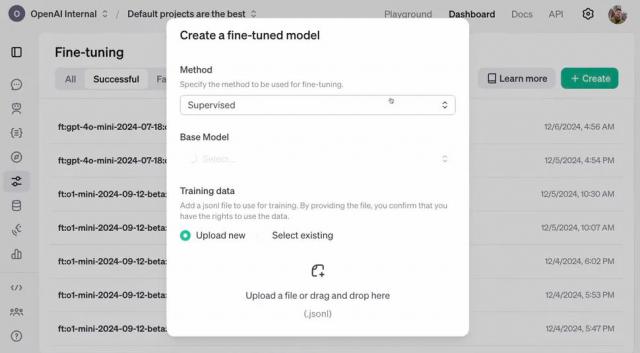

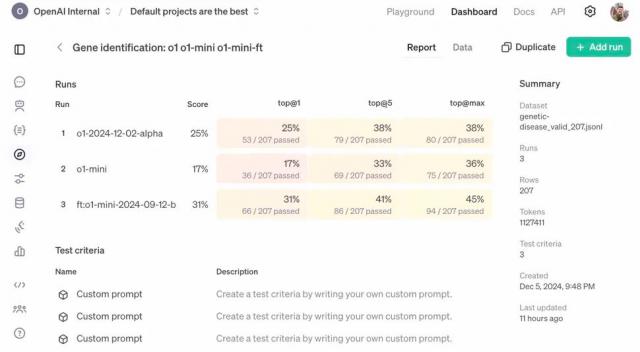

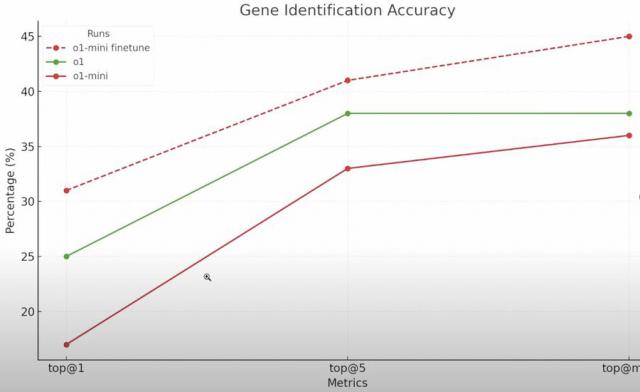

通过全新的模型定制技术,开发者可以利用高质量的任务集对模型进行微调,并利用答案评估模型的响应,从而提高模型在特定领域任务中的推理能力和准确性。

强化微调简介

IT 家庭附带官方介绍:开发者可以使用数十到数千个高质量的任务,定制 OpenAI 模型,用提供的答案来评分模型的响应。官方表示,这项技术加强了模型推理中类似问题的方法,提高了其在该领域特定任务中的准确性。

不像标准微调,RFT 采用强化学习算法,可将模型性能从高中水平提高到专家博士水平。

RFT 不同于监督式微调,它不是让模型模仿输入,而是教学模型以全新的方式进行推理,通过对模型答案进行评分,加强正确的推理路线,RFT 只需少量示例就能显著提高模型性能。

RFT 在法律、金融、工程、保险等需要专业知识的领域,支持用户利用自己的黄金数据建立独特的模型。

强化对人群的微调

OpenAI 激励研究机构、大学和企业申请,特别是目前由专家领导执行的一系列狭窄复杂的任务,将得益于人工智能的协助。

OpenAI 这意味着加强微调在结果中有一个客观的“正确”答案,并且在大多数专家同意的任务中表现良好,因此认为在法律、保险、医疗、金融、工程等领域会有更好的表现。

参与者可以提前浏览 Alpha 版加强微调 API,另外,在特定领域的任务中进行检测, OpenAI 鼓励参与者共享资料,共同改进 OpenAI 模型。

OpenAI 预估 2025 加强微调功能于年初公开发布。

OpenAI CEO山姆・阿尔特曼(Sam Altman)表示:“加强微调,效果出奇的好;那是我。 2024 一年中最大的惊喜之一。”

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com