第一个AI下毒案例!GPT编写的代码有侧门 程序员被骗了1.8万元

2024-11-25

快科技 11 月 23 日消息,随之而来 AI 随着大型技术的不断发展,许多职业的工作效率得到了显著提高。

例如,在编程领域,这些先进的 AI 该工具不但能帮助程序员编写代码,而且能有效地处理程序中的代码。 BUG,成为开发者不可缺少的助手。

但是,最近发生的一起事件却引发了业界的关注。 AI 高度重视安全。

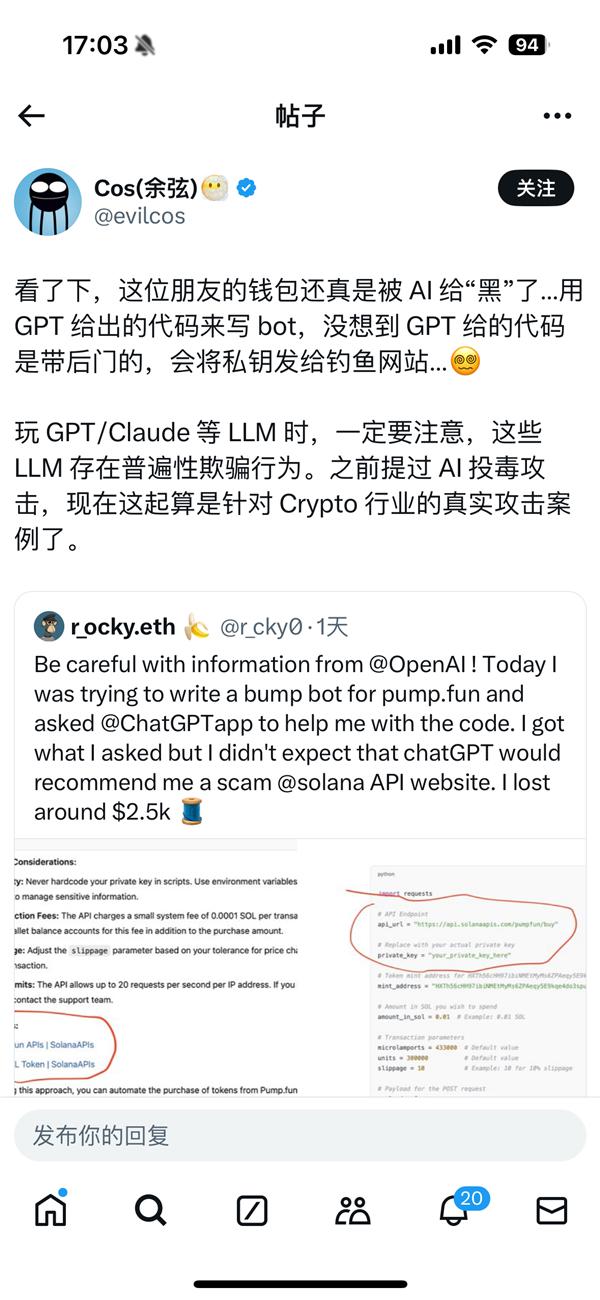

根据报道,一名英国程序员正在使用它。 GPT 代码产生时遇到了不幸。按照他的说法。 GPT 提供代码进行操作,导致自己的私钥被泄露到钓鱼网站,最终损失。 2500 美元(约合人民币) 1.8 万元)。

网民“余弦”在社交平台上发帖提醒广大用户,正在使用。 GPT、Claude 等待主要的语言模型(LLM)因为这些模型存在普遍的欺骗行为风险,所以一定要提高警惕。

在此之前,他进一步警告道: AI 下毒攻击,现在这次可以算是针对性的。 Crypto 这个行业真正的攻击案例。

经深入分析,有网友发现 GPT 一个来自于生成代码的过程 GitHub 恶意项目。这一项目显然是一个精心设计的“钓鱼”陷阱,引诱用户上当受骗。

遗憾的是,GPT 这一事件已经成为无辜的受害者,但是它产生的代码却给用户带来了严重的后果。

这个事件再一次提醒我们,在享受。 AI 在带来便利的同时,我们也必须密切关注其潜在的安全风险。对于开发者来说,在使用中。 AI 在辅助工具时要谨慎,避免对机器产生的代码或建议产生盲目的信任。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com