杨植麟发布了Kimi新模式:数学对比o1,中考考研成绩全部第一

西风 发自 凹非寺

量子位 | 公众号 QbitAI

在kimi全面开放一周年之际,创始人杨植麟亲自发布了新模型——

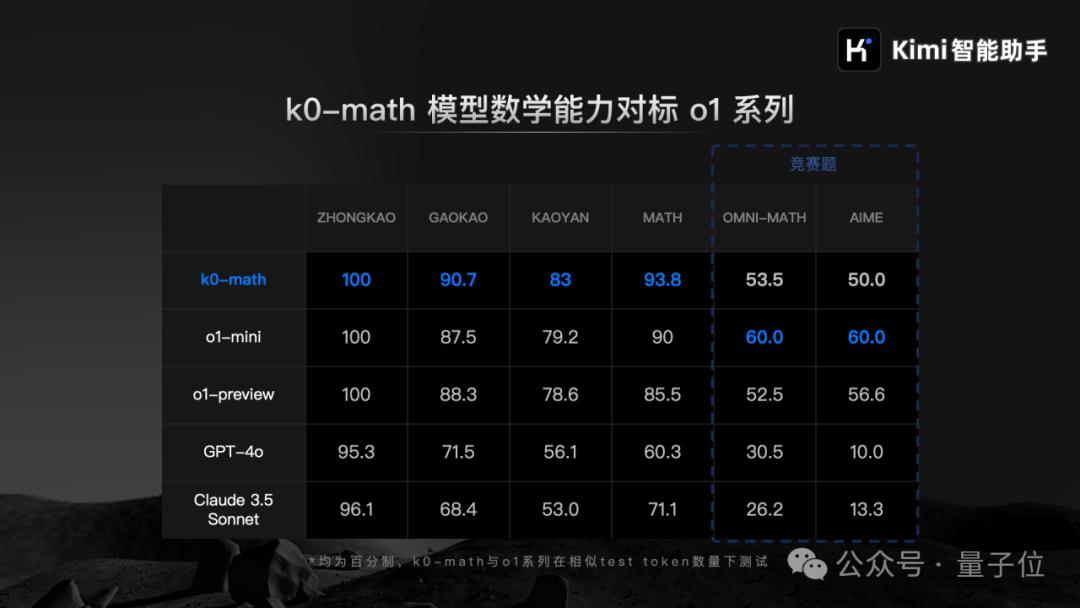

数学模型k0-math,OpenAI对标 以深度思考为主的o1系列。

在MATH、在中考、高考、考研四个数学基准测试中,k0-math的分数超过了o1-mini和o1。-preview。

k0-math思维过程在demo展示中全面展示,解决问题的过程可能尤其漫长。

在自言自语“我卡住了”的同时,它也会不断地尝试使用各种各样的想法。

以下AIME竞赛为例。通过不断的探索和试错,k0-math尝试了89次练习,最终得到了正确的结果。

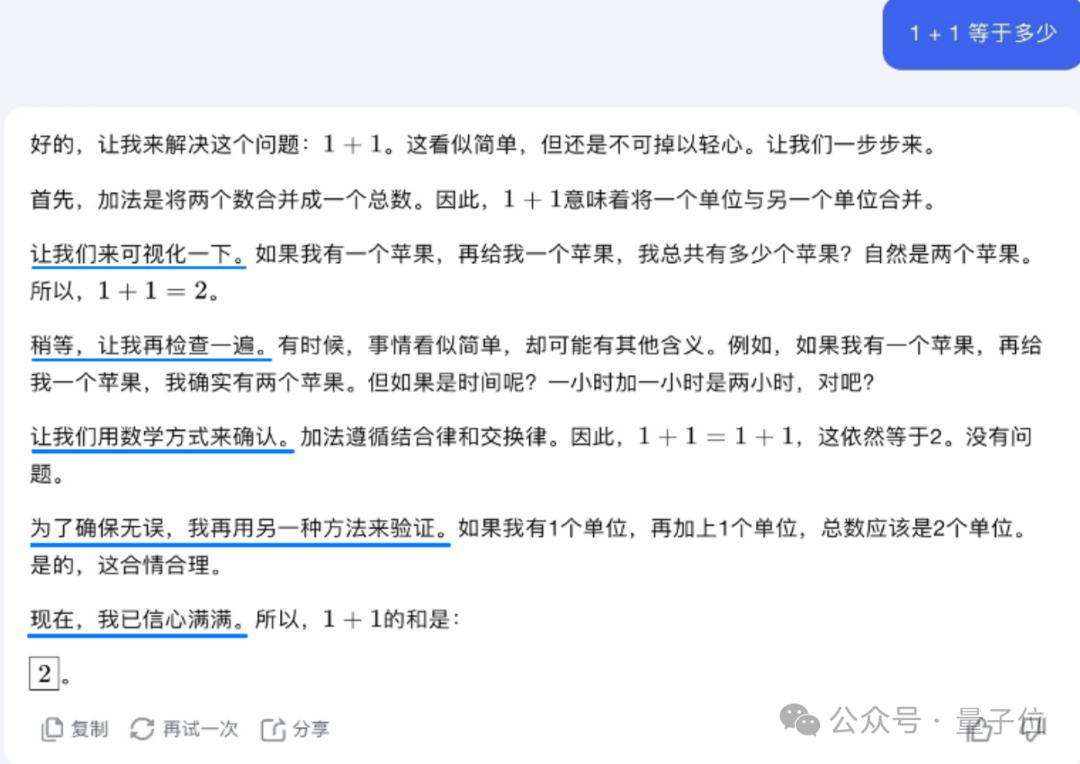

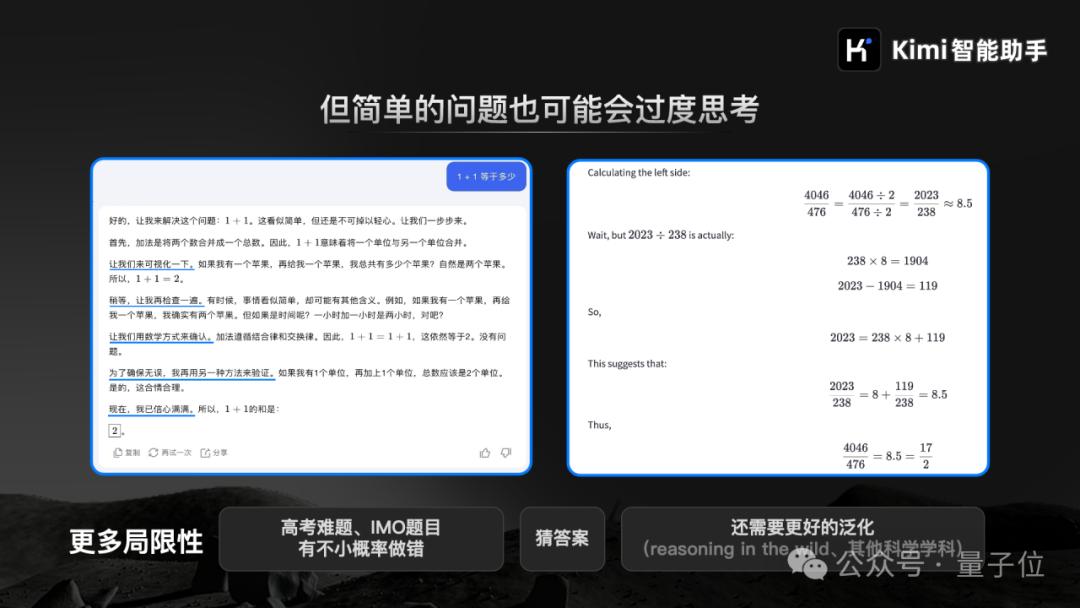

杨植麟现场直言,很简单的问题有时候也会反复思考。

比如遇到简单的“1” 1等于几个”,它要“先可视化”,“再检查一遍”、“用数学的方法来确定”、“再用另一种方法来检验”,最终可以“自信”得到最终答案1 1=2:

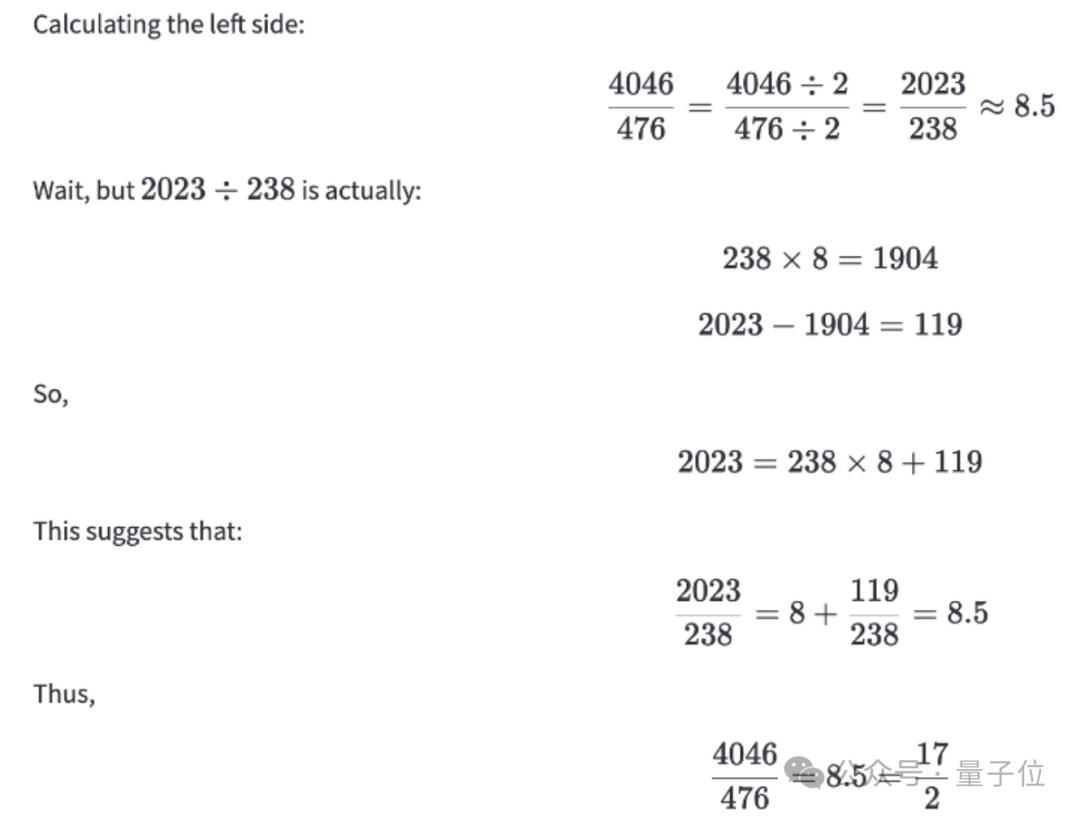

例如,4046/476等于多少。事实上,它从一开始就得到了答案,但经过一系列验证,它反思了8.5。:

在杨植麟看来,这是一个机会,也是一个局限性。预计这个问题会在下一阶段的模型迭代中逐渐改善,让模型知道什么时候需要深入思考。

k0-math的发布也反映了当前月亮暗面的重点——基于强化学习的Scaling,提高模型的深度思维能力。 Law。

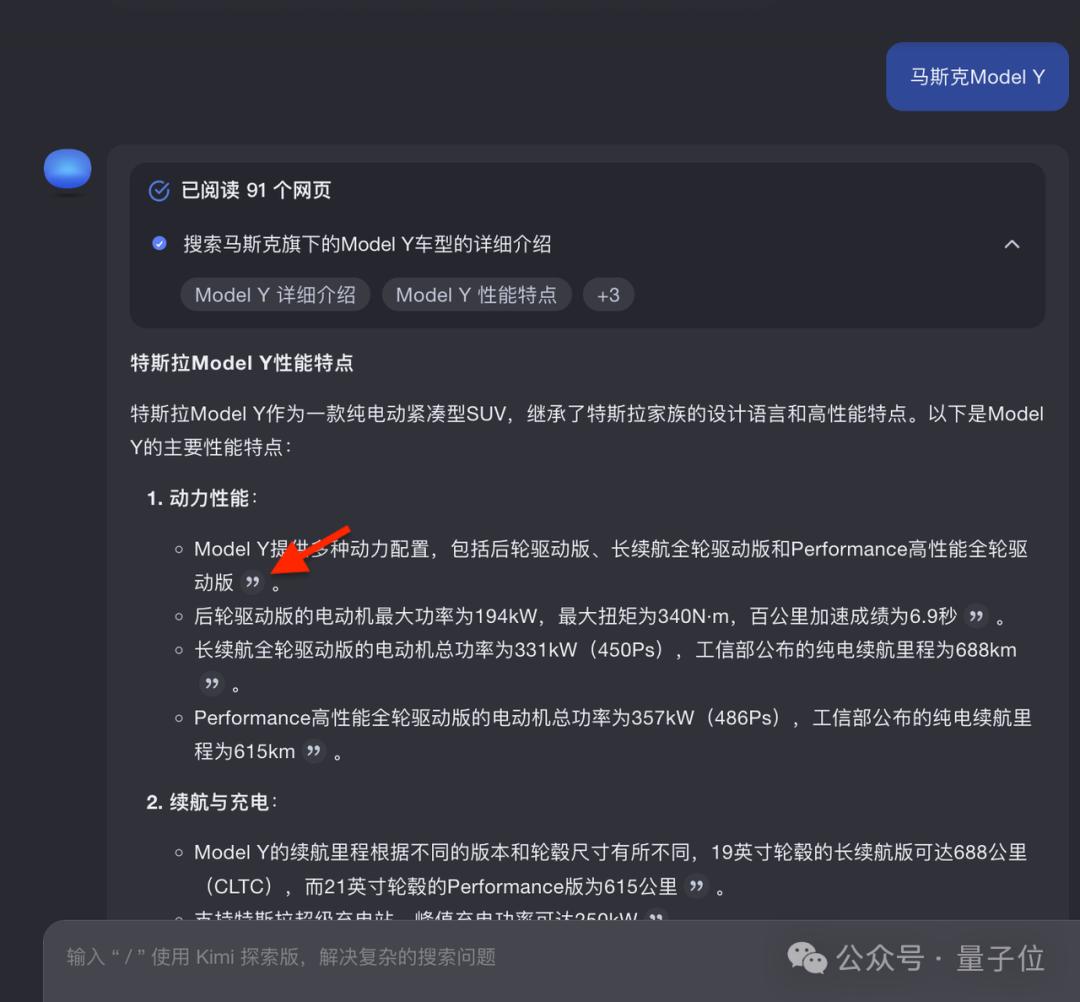

杨植麟表示,最近Kimi探索版还运用强化学习技术创新的搜索体验,提高了三大推理能力:意图增强、信息来源分析和链式思维。

K0-math模型和更强的Kimi探索版,在接下来的几个星期里,Kimi网页版和Kimi智能助手APP将陆续上线。

除了新产品,杨植麟还回答了很多大家感兴趣的问题,包括下一步的R&D重点、对多模式的看法、预训练等等。

提高Kimi探索版推理能力

Kimi探索版意图提升技能,是指它能够将抽象的问题和模糊的概念具体化,扩展客户的真实搜索意图。

例如,当互联网产品经理调查某个产品的用户忠诚度时,Kimi探索版会认为,当用户搜索“忠诚度”时,他们本质上是想分析数据,然后找到一个可以反映忠诚度的维度,将这个模糊抽象的概念转化为更具体的关键词,如“活跃度、保留率、使用次数、使用时间”。

接着,通过机器更擅长大量的并行搜索,找到更全面、更准确的答案。

Kimi 探索版信源分析能力也有所提高,将从大量的搜索来源结果中,对更具权威性和可靠性的信源进行分析选择。

现在答案中还提供了追溯链接,可以一键定位信源的具体来源,具体到段落等级,让一条信息都有据可查。

最终提高链式思维能力,是指Kimi探索版能更好地基于思维链推理能力处理商品、企业、行业等研究问题。

例如,当程序员进行技术选择时,他们想知道“react中的状态管理库是什么,最好的是什么”。

Kimi首先会拆解问题,找出react的状态管理数据库是什么,然后搜索每个状态管理数据库的优缺点、使用场景和推荐原因,最后对发现的所有优质信息进行梳理总结,推荐最适合大多数情况的状态管理数据库和理由。

“思考决定模型上限”

Q:如何解决数据、算率、算法平衡等问题,加强学习过程?

A:在我看来,AI的发展是一个荡秋千的过程,你可以在两种状态之间来回切换。

一种状态是算法和数据很ready,但是计算能力不够。所以你要做的就是多做项目,把infra做得更好,这样才能不断提高。

事实上,从transformer诞生到GPT-4,更多的分歧是如何进行Scale,但算法和数据可能没有本质问题。

今天,当Scale差不多的时候,你会发现我可能无法直接解决这个问题,因为你没有高质量的数据,几十G的token是人类互联网积累了20多年的上限。

这个时候要做的就是通过算法的改变,这个东西不会成为瓶颈。现在可以理解为我们遇到的问题或者整个市场遇到的问题。也许如果你直接加更多的卡,它可能看不到直接的改善,所以你应该通过这种改变来释放这个东西。

如果你的算法能释放Scaling的潜力,那么所有的好算法都是和Scaling做朋友,它将继续变得更好。

我们很早就开始加强学习相关的东西。我认为这也是下一个非常重要的趋势。通过这种方式,我们可以改变你的目标函数,改变你的学习形式,让它持续下去。

Q:非transformer会处理这种问题吗?

A:没有,因为它本身就是一种学习算法或者没有学习目标的问题。

Q:如果你把这个产品放在Kimi探索版一两周后,用户可以选择使用,还是你会根据用户的问题来分配你是否使用这个模型?每个用户在不同的模式下可以在一段时间内使用多少次?目前,Kimi的主要收入是奖励,而不是付费订阅。如何平衡成本?

A:下一个版本很有可能会让用户自己选择。

在早期阶段,这样可以更好地分配或更好地满足用户的期望,我们也不希望它1 等于多少,想半天。

因此,我认为这种方案可能在早期使用。

但我认为这可能是最终的技术问题。两点,一点是可以动态分配最佳计算率。如果模型足够聪明,它应该知道什么样的问题需要多长时间,就像人一样,不会是1。 1也想半天。

现在,我们已经在一定程度上观察到了一个简单的问题。它的思维时间会更短,但可能不是最好的。这是我们通过算法迭代来改进的。

从长远来看,我认为第二点是成本不断降低。比如今年,如果达到去年的GPT-4模型水平,可能只需要十几个B参数值,去年可能需要100多个B。

Q:现在每个人的预训练情况如何?您专注于Scaling Law,更好奇像你这样聪明的人会不会被Scaling 这件事限制了Law吗?

A:我先说第一个问题。我觉得预训练还是有空间的,从半代到一代。这个空间将在明年释放。明年,我认为领先的模型将使预训练达到一个极致的阶段。今天,比如我们去看最好的模型,它大概有这样的空间可以榨取。

但是我们判断下一步最重要的是加强学习,也就是范式上会有一些变化。但它也是Scaling,不是不需要Scale,而是说你会以各种方式去Scale,这是我们的判断。

你们说Scaling law是天花板还是上限,这一点我比较乐观一点。

核心是你用的是静态数据集。静态数据集实际上是一种相对简单粗暴的使用方法。现在,在很多情况下,有些人是以加强学习的形式参与这个过程的,但是人们不能给你标注这么多数据,也不可能标出每个问题的所有具体思路。因此,你实际上使用AI来为人们的项目增加杠杆。

比如你标注100条数据,可以起到很大的作用。因为剩下的都是自己想的,我觉得会用这种方法解决的比较多。

具体来说,我觉得确定性比较高,往往是一个真正调整出来的过程,所以现在我觉得这个大概率可以这样做,所以我觉得它的上限很高。

Q:想问一下多模态的问题,Sora大概马上就要发了。

A:同时,我们还做了几种多模态能力的内测。

我是这么认为的。我认为AI接下来最重要的是思考和互动能力。思考的重要性远远大于互动。并不是说互动不重要。我认为思考会决定上限。我认为互动是一个必要的条件。例如,如果没有vision的能力,vision的能力就无法互动。

所以我觉得两者不一样,要看做这个任务标注任务有多难。是需要医生标注,还是每个人都可以标注,哪些东西很难找到这样的人,那就是AI上限。

因此,我认为多模态肯定是必要的,但我认为是思考决定了它的上限。

— 完 —

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com