介绍人工智能数据中心介绍

神译局是36氪旗下的编译团队,重点介绍海外新技术、新观点、新趋势,重点介绍科技、商业、职场、生活等领域。

编者按:人工智能的发展如火如荼,但大多数人只看到应用的普及。真正的支撑很少为人所知,人工智能的发展离不开巨大计算能力的支撑。如今,每五个为人工智能而生的数据中心消耗的电相当于纽约市的消耗。本文将介绍一些关于AI数据中心的基础知识。文章来自编译。

现在美国这波计算基础设施,被认为是历史上最大的规模之一。

100多年前,我们见证了类似电网的建设(具有讽刺意味的是,这是当今美国基础设施建设的瓶颈)。在电网建立之初,我们目睹了电厂的规模(尽可能多地建设电厂,以提高性能)。、资本支出“天文数字般”(CapEx)投入,以及电力成本的急剧下降。

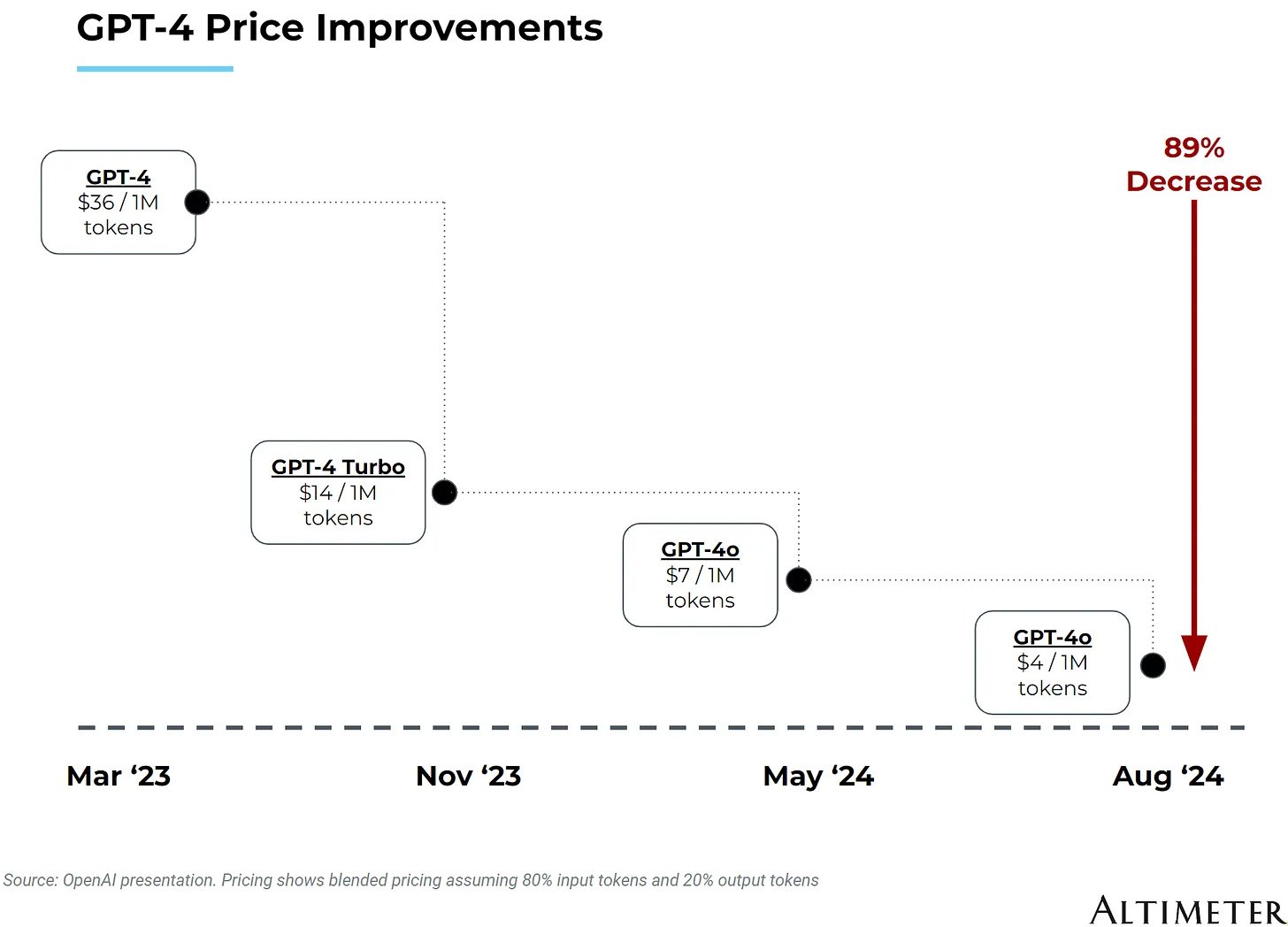

如今,我们正在见证数据中心的规模化,超大型云计算公司的高额资金支出,以及AI核算成本的急剧下降:

本论文的重点是构建AI专用数据中心所需的基础设施。

1. AI数据中心简介

“数据中心”这个词不能完全描述这些“AI工厂”的巨大规模。最大的数据中心在土地、电力和冷却设备、建设成本、GPU和其他计算基础设施方面的成本可以达到数十亿美元。

这还没有包括能源成本。新的、最大的超大型数据中心耗电1GW。要知道,纽约市的耗电量只有5.5。GW。换言之,每五个这样的超级数据中心,就等于增加了纽约市的电力负担。

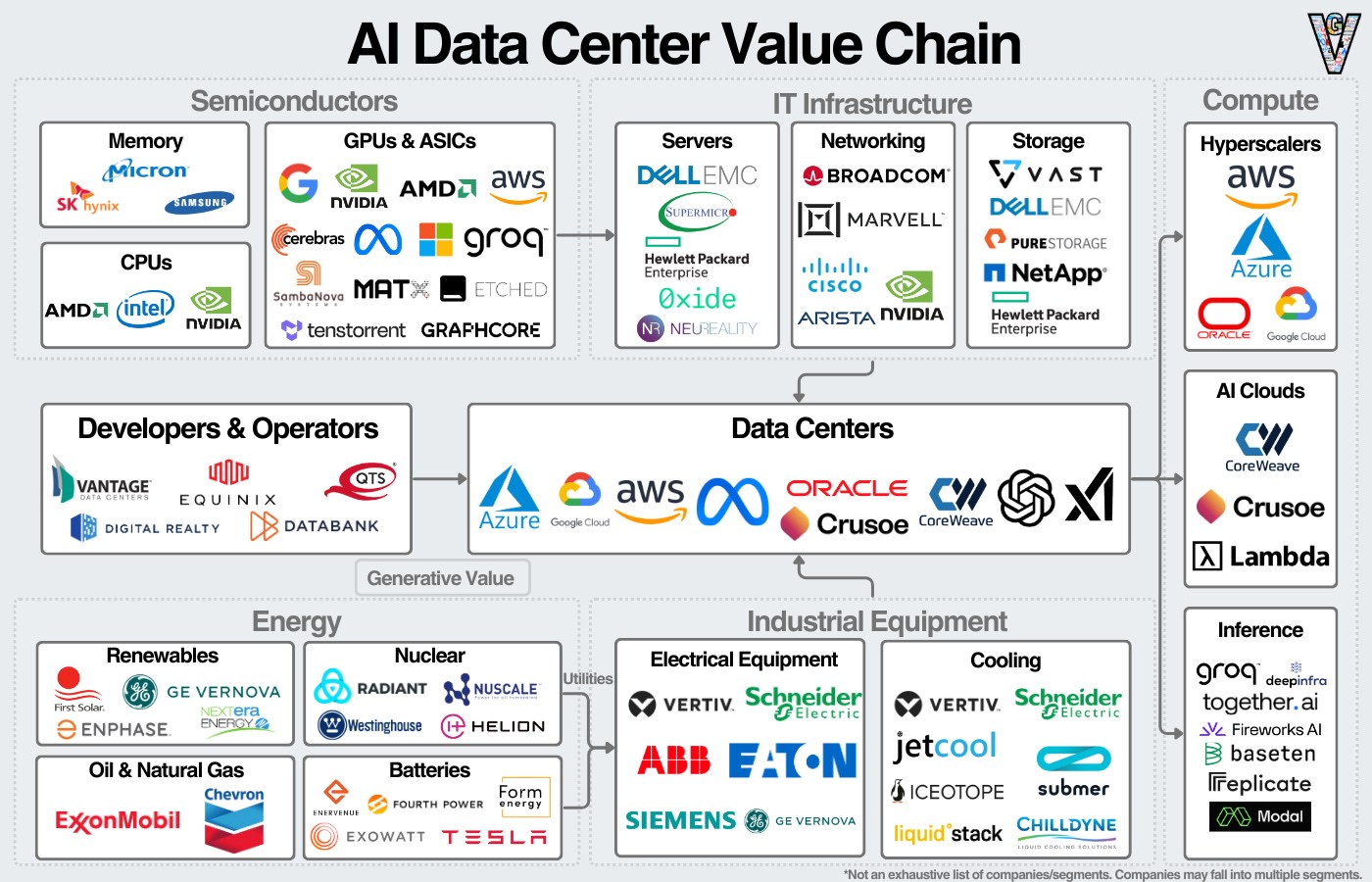

数据中心的价值链大致可以分为几个部分:数据中心的初始建设、支持数据中心的工业设备和计算基础设施,以及为数据中心供电的能源。此外,一些公司还拥有或租用数据中心,为用户提供最终服务。

AI数据中心价值链

我们应该先了解一下数据中心的历史,然后再进行深入研究。

2. 简史的数据中心

在很大程度上,数据中心伴随着计算机和互联网的兴起。下面介绍一些趋势的历史概述,以及我们是如何走到今天这一步的。

最初的数据中心历史

最早的计算模式类似于今天的数据中心:有一台集中式计算机,主要用于处理计算密集任务和关键任务。

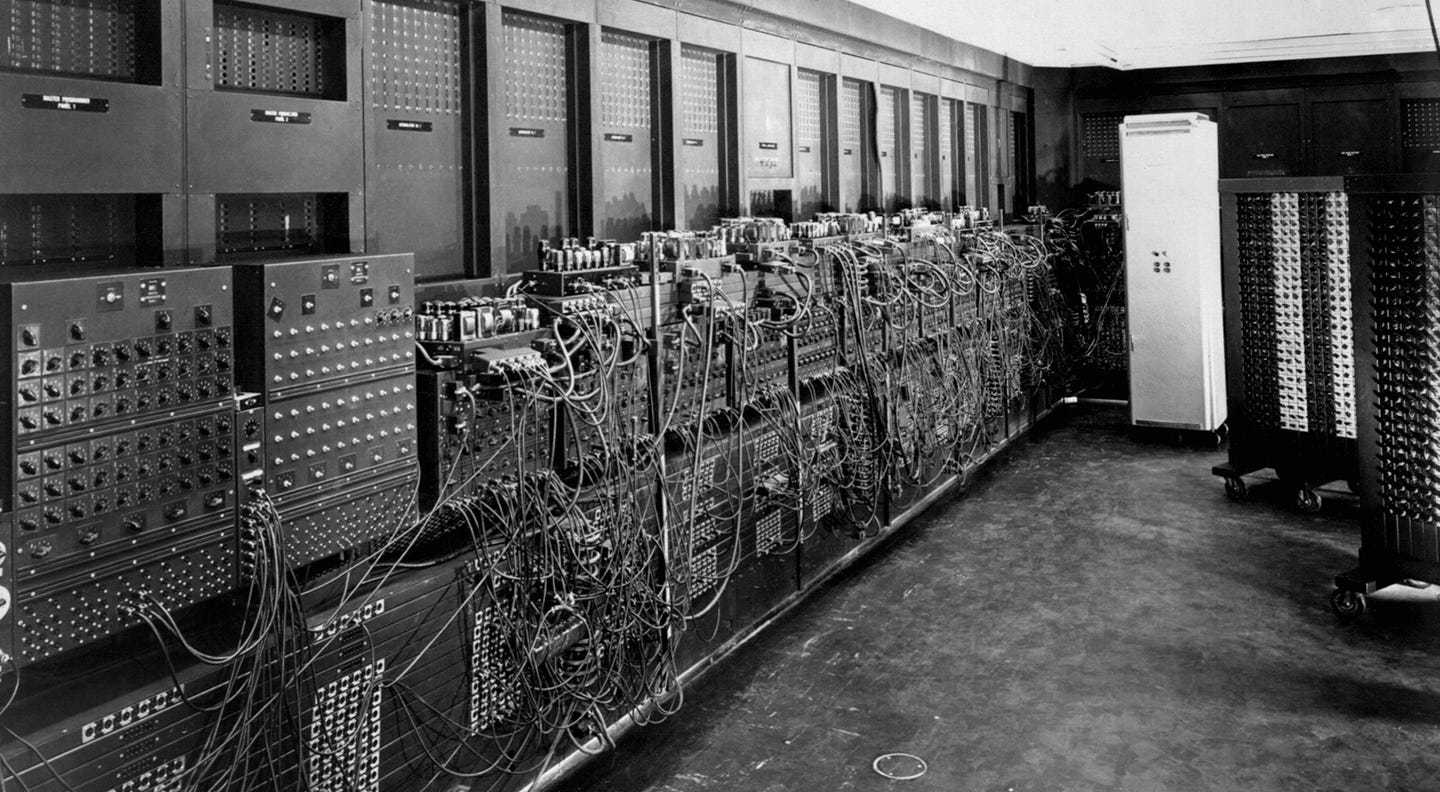

这是两个早期的例子:

巨人计算机(Colossus):阿兰·图灵(Alan Turing)计算机是为了破解Enigma机而建造的。(注:图灵也被称为人工智能和计算机科学的鼻祖。去年,ChatGPT通过了这个测试,他提出了图灵测试,以检测AI是否具有真正的智能。

ENIAC:这台电脑是由美国军方在二战期间设计的,但是直到1946年才完成。尽管巨型计算机是在ENIAC之前建造的,但是ENIAC通常被认为是第一台计算机,因为它的机密性。

两者都位于设施中,可视为“最早的数据中心”。

20世纪50年代,IBM崛起并统治了计算领域。公司推出了大型计算机,引领了其在科技领域的几十年主导地位。AT&T是另一家占据主导地位的科技公司。

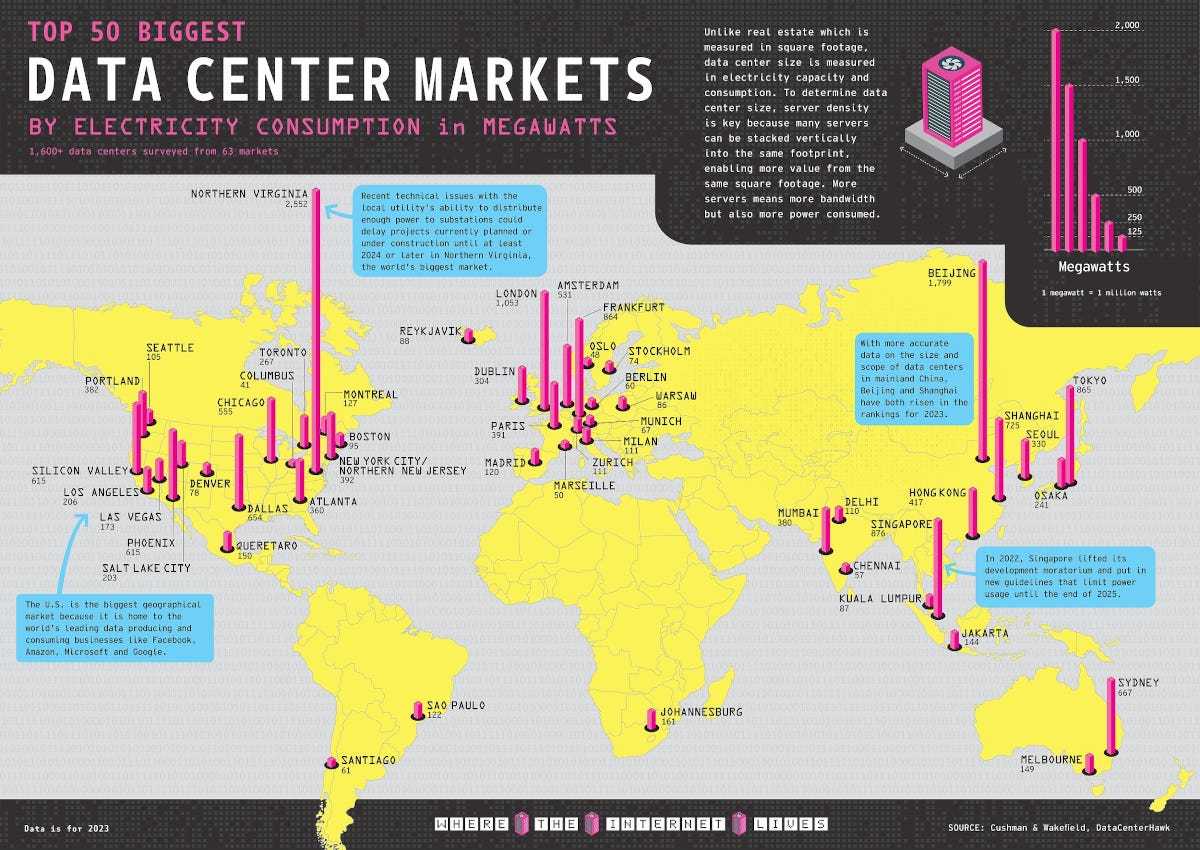

ARPANET于1969年发布,该网络的目的是将美国计算机连接起来。ARPANET现在被称为互联网的早期版本。由于是一个政府项目,它最密集的连接位于华盛顿特区周边。

全球50大数据中心(按电耗)

因特网和云计算的兴起

20世纪90年代,随着互联网的发展,我们应该越来越多的物理基础设施来处理快速增长的互联网数据流量,其中一些需求是作为节点的数据中心来满足的。像AT&T这样的电信公司已经建立了通信基础设施,数据中心业务的扩大对他们来说是合乎逻辑的。

然而,在数据传输方面,这些电信公司的关系与目前垂直整合的云服务提供商的“竞争”有些相似。AT&T不仅拥有基础设施上传输的数据,还拥有传输数据的设备。所以,在传输容量有限的情况下,AT&T会优先传输自己的数据。其它公司对此非常警惕,因此后来才有了Digital 数据中心企业的崛起,如Realty和Equinix。

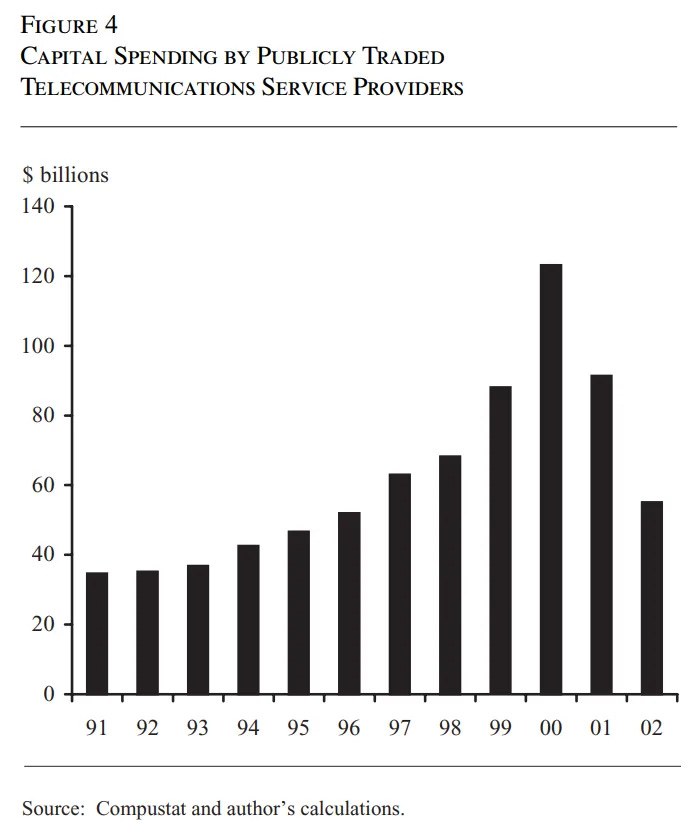

在互联网泡沫期间,数据中心获得了大量投资,但随着泡沫的破裂,这种增长明显放缓(这也是我们在推断未来数据时应该牢记的一课)。

直到2006年,随着AWS的发布,数据中心的需求逐渐恢复。从那以后,美国的数据中心规模一直保持稳定增长。

随着AI数据中心的兴起

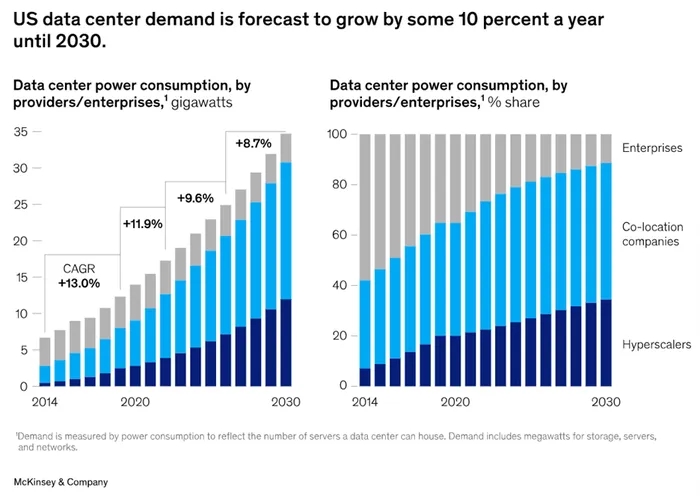

这一稳定增长一直持续到2023年,今年AI热潮席卷全球。根据估计,到2030年,数据中心的容量将会翻一番(要记住,这只是估计)。

AI的工作负荷训练引起了对数据中心规模的新关注。计算基础设施之间的距离越近,性能越好。此外,当数据中心设计成计算单元,而不仅仅是安装服务器的设施时,企业还可以获得额外的整合收入。

最后,由于AI训练不需要接近终端用户,所以数据中心可以随时建立。

综上所述,今天的AI数据中心注重规模、性能和成本,几乎可以随时建立。

3.建设AI数据中心的要素

建立AI数据中心

计算提供商(超大型提供商、AI公司或GPU云提供商)要么建立自己的数据中心,要么与Vantage合作、与QTS或Equinix等数据中心开发商合作,寻找电力充足的土地。

然后,他们会雇佣总承包商来管理建设过程,而总承包商会雇佣几个承包商来负责各种功能(如电力、管道、暖通空调等)。)并购买原材料。在项目期间,工人将转移到该地区。建筑主体结构完成后,下一步是安装设备。

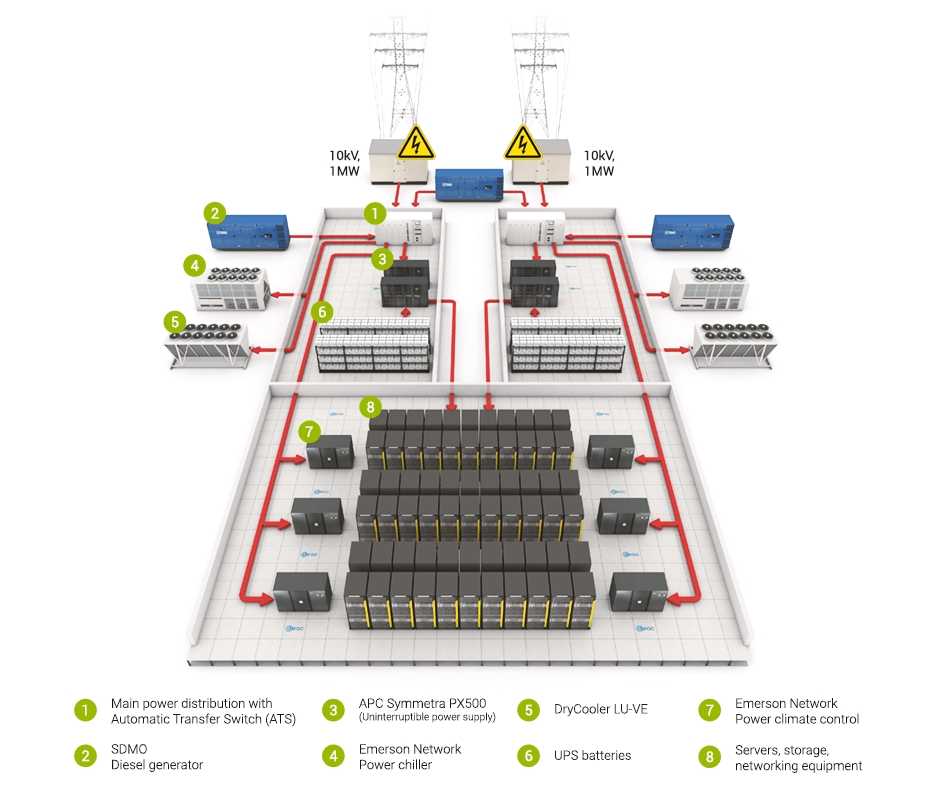

数据中心的工业设备可以主要分为电气设备和冷却设备。电气设备从主开关柜开始,用于连接外部电源,然后连接到配电单元和不间断电源。(UPS)以及连接服务器机架的电缆。大多数数据中心也会配备柴油发电机,以便不时断电。

其次是机械和冷却设备,包括冷水机、冷却塔、暖通空调设备以及连接到服务器的液体或蒸发冷却系统。

AI数据中心的计算设备

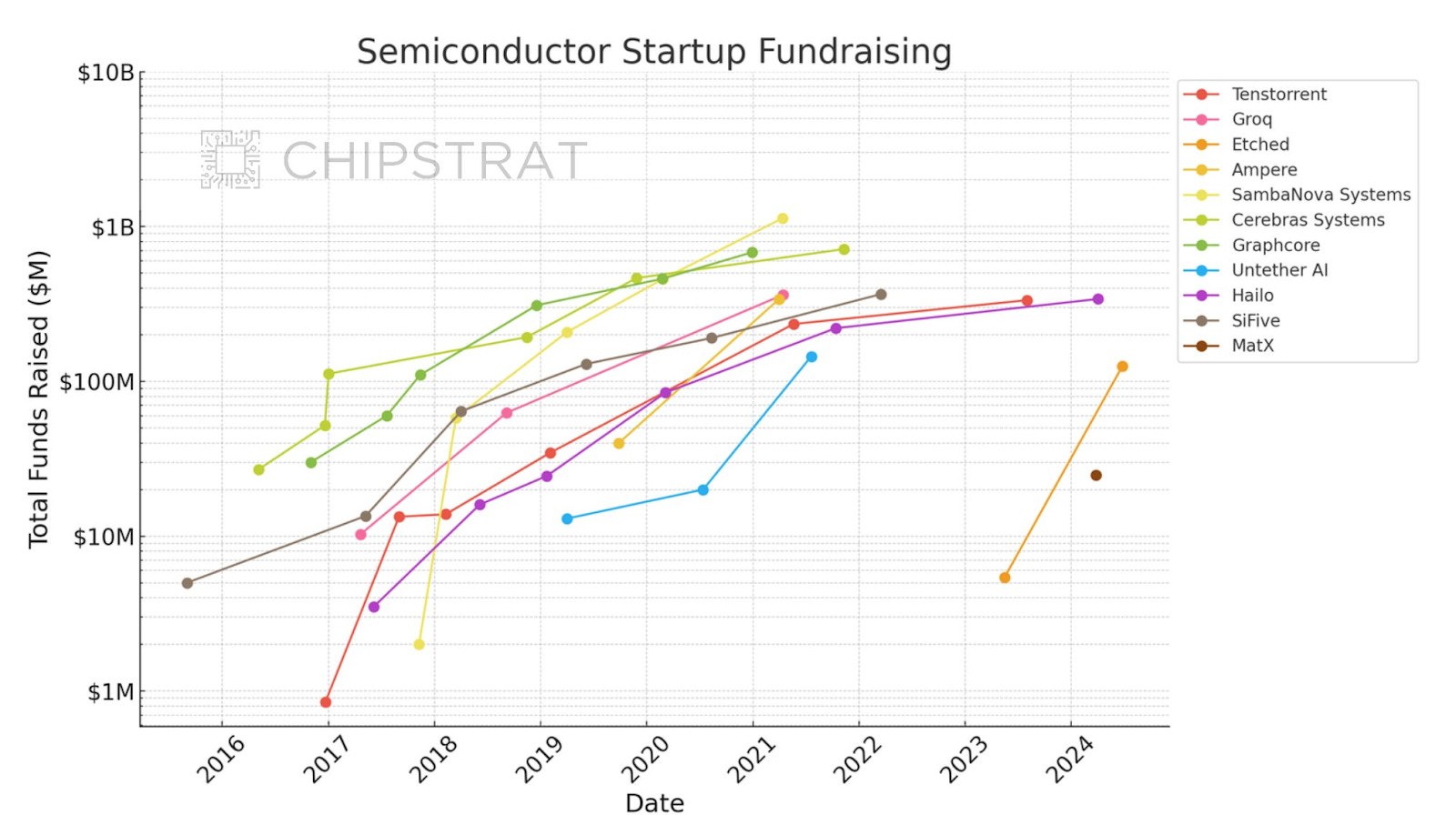

计算基础设施包括运行AI练习和推理工作负荷的设备。GPU或加速器是关键设备。除了Nvidia、除了AMD和超大型供应商之外,许多创业公司也在争夺AI加速器的市场份额。

半导体创业公司的融资情况

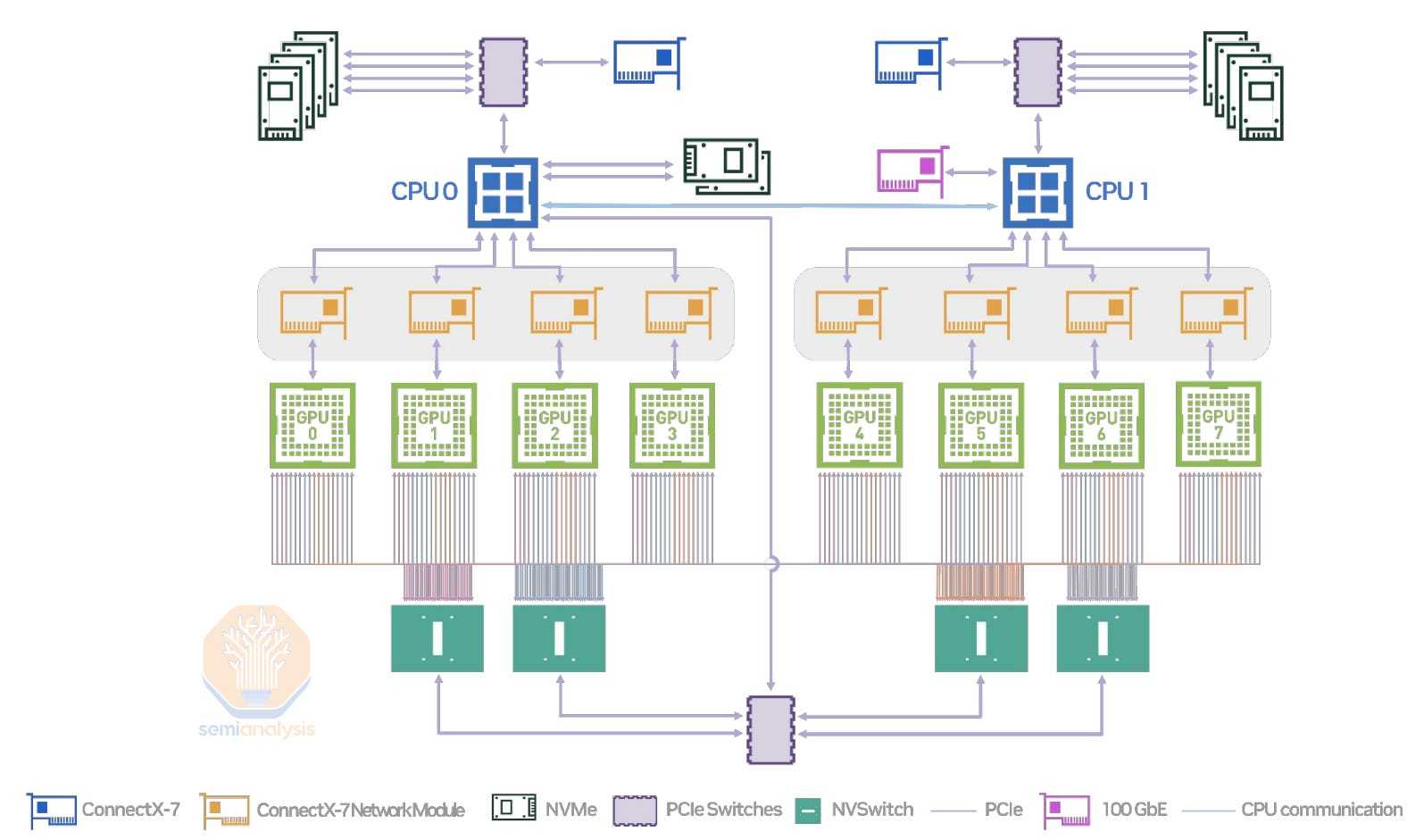

虽然CPU的重要性不如以前,但它们在完成复杂的操作和任务分配方面仍然发挥着重要作用。存储设备用于存储芯片以外的数据,而内存用于存储需要频繁访问的数据。网络负责连接所有部件,包括服务器内部和外部的连接。

最后,这些设备将安装在数据中心服务器中。

为AI数据中心提供能源

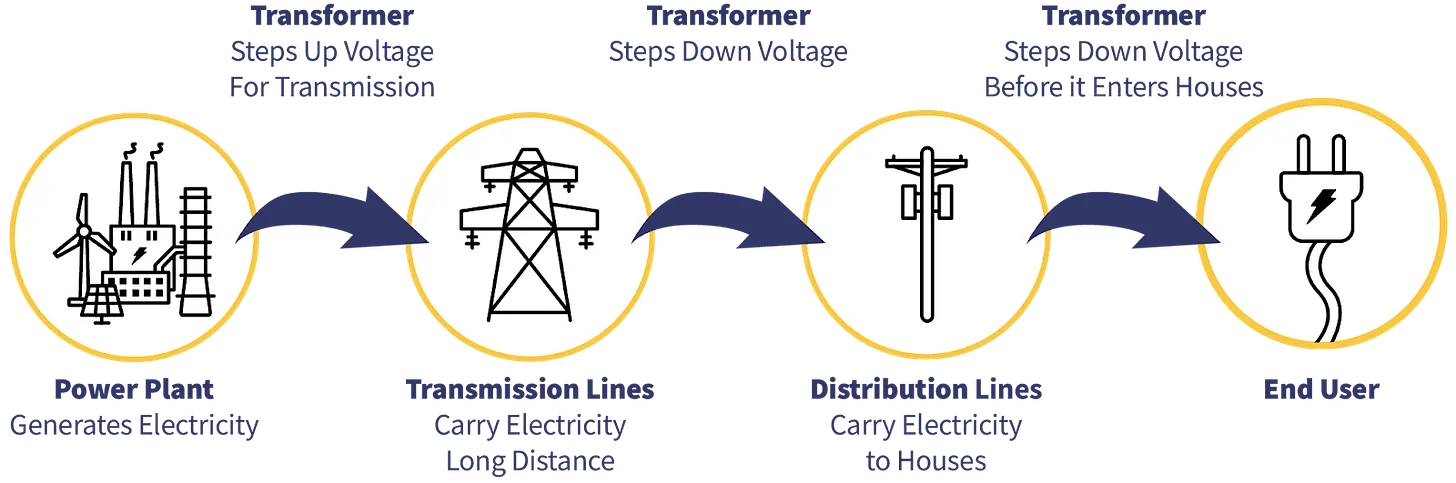

能源供应链可以分为以下几个部分:

能源来源 - 化学燃料,可再生能源和核能,能带来电能。

发电 - 发电站将化石燃料转化为电能;而可再生资源则在更接近能源源的地方发电。

输电 - 电力通过高压线路传递到目的地周围。变压器和变电站将高压电力降低到适合消耗的电压。

公共事业/配电 - 最后一公里的配电由公用事业公司管理,并通过电力购买协议(PPA)电力输送的管理。

一般而言,所谓的“电网”是指由当地管理的传输和配电系统。这两个地方都有可能成为电力传输的瓶颈。

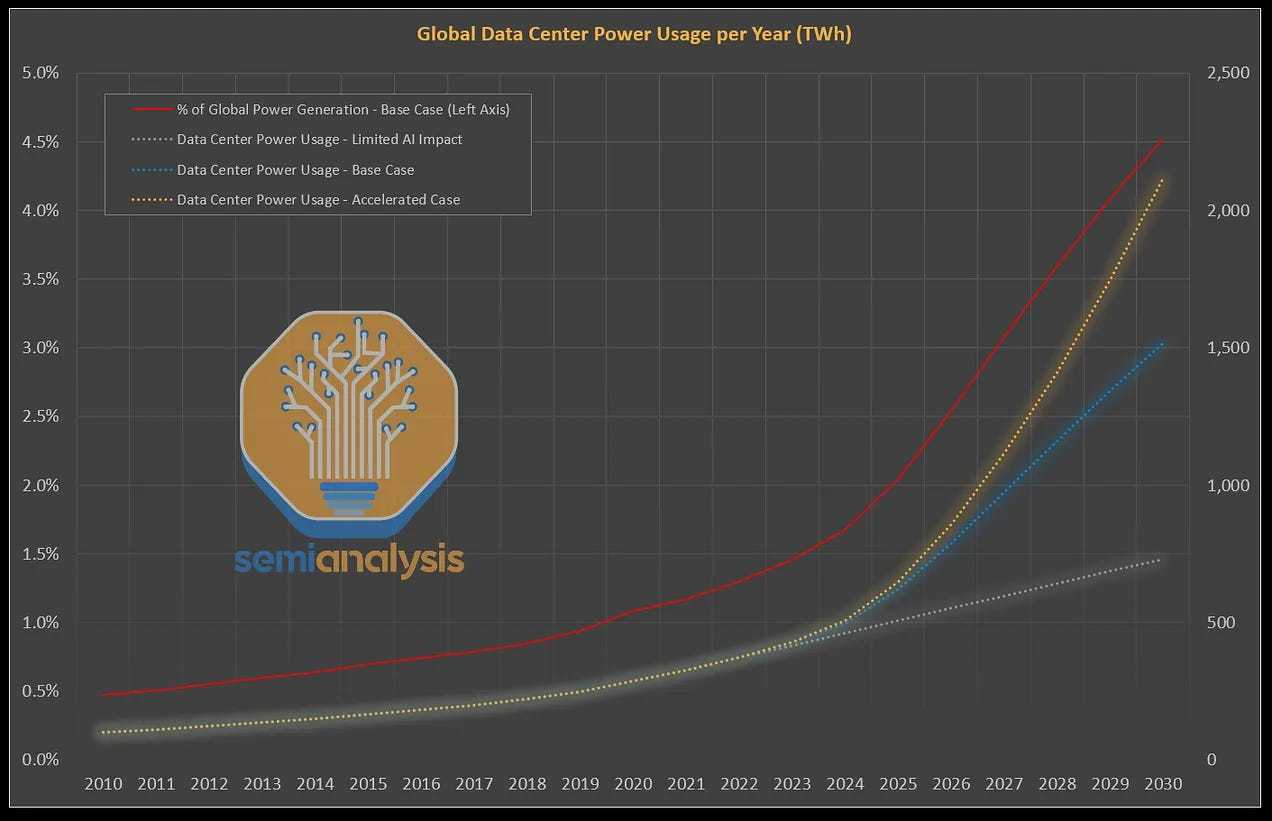

能源已成为AI数据中心扩展的关键瓶颈。

扩展电力并不容易。数据中心有两种选择:并网和离网。并网由公共事业公司通过电网输电分配。离网时避开电网,如现场使用太阳能、风能和电池。更理想的情况是,在2.5 一个GW级数据中心建在GW核电厂旁边!

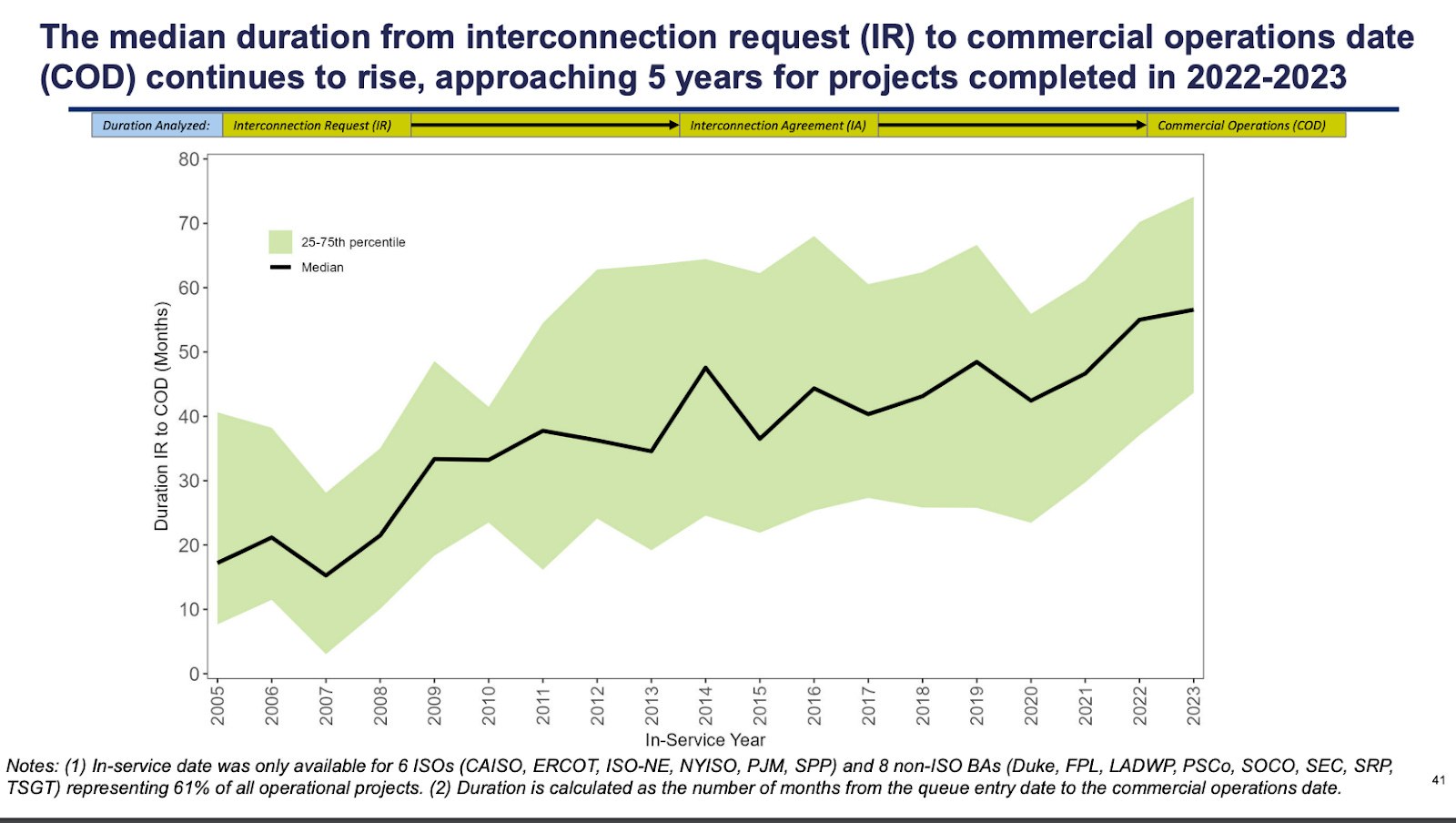

并联网的问题是电力扩展所需的时间。下面的图表显示了从源头申请电力到实际投入使用所需的等待时间。

获得动工许可证的时间(月数)越来越长

很难避免这些挑战需要采用多种组合方案。在最后一节中,我们将进一步讨论。

4.AI数据中心的新特征

在规模、密度、速度和能耗方面,新一代数据中心得到了显著提高。

“超大规模”数据中心不是一个全新的概念。几乎每隔几年,就会有关于数据中心规模扩张的报道,从2001年的几兆瓦到2010年代的50兆瓦,再到2020年的“巨型120兆瓦”数据中心,现在已经发展到数吉瓦的超大规模。

这些吉瓦级数据中心不仅规模大,而且密度高。这样的系统应该从系统的角度来设计。核心问题是摩尔定律放缓,即半导体在晶体管密度方面的性能提升难度逐渐增加。因此,解决办法是尽可能地将服务器和整个数据中心的部件集成在一起。

实际上,这意味着数据中心被设计成一个集成系统,而非由单太服务器组成的机房。这类服务器也应该设计成紧密结合的集成系统。

因此,英伟达也出售服务器和POD系统,因此超大型企业需要建立系统级数据中心,这可能解释了AMD应该做出收购ZT系统的战略选择。

看看英伟达的DGX H100系统,它不仅可以用作独立的服务器,还可以连接到其它GPU形成POD,甚至可以连接到SuperPOD以增加连接数:

英伟达还引领了“加快计算”的趋势,即将任务从CPU转移出去,从而提高GPU。、组件的作用,如网络和软件。

此外,AI的独特需求需要处理大量数据,因此数据存储能力(内存/存储)和大量数据(网络)的快速传输变得尤为重要。就像心脏需要泵血一样,GPU就是心脏,信息就是血液(所以谷歌TPU架构也叫“脉动阵列”)。

这些趋势共同构成了世界上最强大的计算设备。这种计算能力为每台服务器带来了更大的能耗、更多的热量和更高的冷却需求。随着我们对计算能力的需求越来越大,这种能耗只会越来越大。

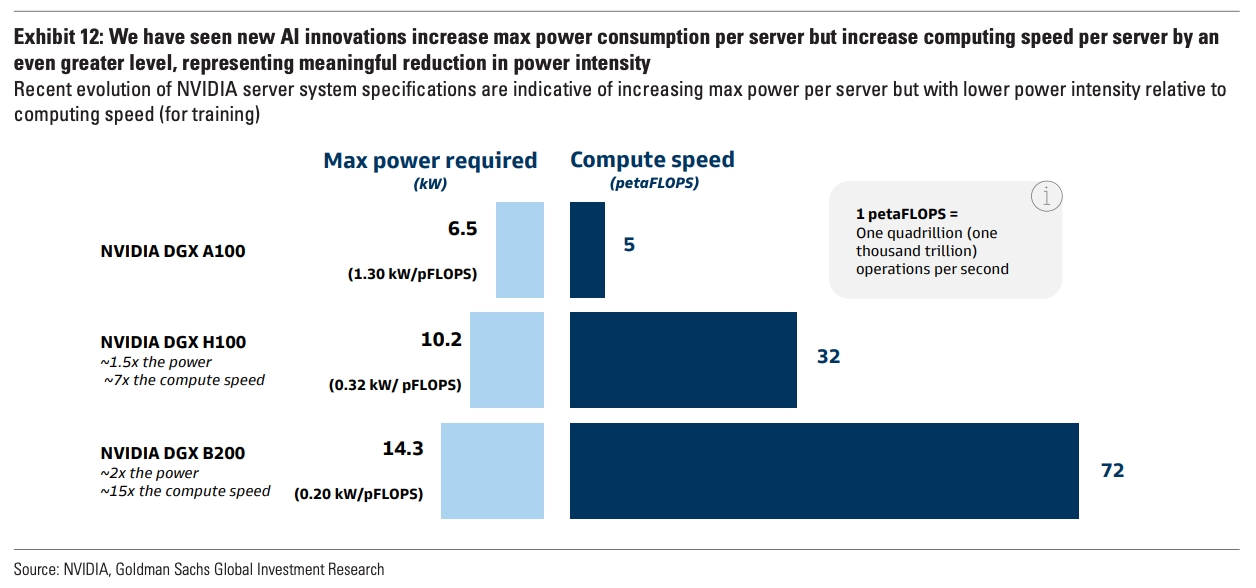

虽然最先进的设备耗电量较大,但能效比却有所提高。

5.瓶颈和受益者

下面列出了会从中受益的名单(不详细)和一些目前备受关注的领域。从变压器施工中技术工人短缺到许可过程的自动化,各方面都存在瓶颈,整个供应链非常紧张。

电网扩展还是避免电网扩展?

显然,为了支持这种扩张,能源基础设施需要改进。几乎每个科技公司都倾向于使用并网方式:这种方式更可靠,管理更方便。但是,如果并网电力不能使用,超大型公司会考虑自给自足。例如,AWS正在印第安纳州设立一个数据中心公园,投资110亿美元,建设四个太阳能发电场和一个风力发电场(600兆瓦)供电数据中心。

从中长期来看,我最看好两种能源瓶颈方式:核能和电池。两者都可以为数据中心提供更可持续的能源来源。

核能的优势是众所周知的:干净稳定。然而,如何经济可行地建设核能是一个巨大的挑战。目前,一些潜力巨大的创业公司正在解决这个问题。

长期电池创新将是可再生资源发展的重要一步。太阳能和风能的缺点在于它们的间歇性,只有当风速或阳光充足时才能发电。长期电池可以通过储存多余的电力来缓解这个问题,在电力短缺时释放能量。

液体冷却技术建设许可证和施工许可证

在工业领域,有两种趋势特别值得关注:许可证管理的自动化和液体冷却技术。许多人反映,获得施工许可证是扩张的瓶颈之一。

如果你想扩大数据中心和电力,开发商需要获得建筑、环境、城市和噪声的许可,也可能需要地方、州和国家各级机构的批准。此外,他们还需要法律规定优先购买权。在能源基础设施领域,这个过程更加复杂。PermitFlow等许可管理软件公司在缓解这些问题方面取得了巨大成就。

AI数据中心新一代技术的显著差异之一是服务器产生的热量增加。因此,新一代数据中心将采用液体冷却技术,下一代可能会选择更先进的浸入式冷却技术。

向计算企业脱帽致敬

我们不得不承认,(1)英伟达在构建生态系统方面取得了巨大的成就,(2)AMD在巩固其作为替代方案的地位方面也取得了显著的成就。从应用到软件基础设施,再到云计算、系统和芯片,英伟达在建设AI技术浪潮方面做得非常好。

Crusoe提供AI运算能源服务将是另一家将处于有利地位的企业。

最终,得益于数据中心的扩展,计算企业应该能够在价值链中继续获得可观的利润。如果能提供从网络、存储到服务器的顶级性能,公司将从这次扩张中受益。

最终思考

最后对数据中心扩展的思考是:尽管这看起来是一种新的趋势,但实际上这只是计算发展历史较长的一部分。AI、数据中心和运算不应被视为分割的问题。

正如山姆·阿尔特曼所说:

“人类的历史可以简化为:经过几千年的科学发现和技术进步,我们终于学会了如何熔化沙子,加入一些杂质,以极其准确的方式安排在微尺度中,形成计算机芯片,用电驱动,从而创建一个越来越强大的人工智能系统。”

阿兰·图灵不仅是现代计算机的奠基者,也是计算机科学和人工智能的奠基者,这绝不是偶然的。这一趋势在过去100年创造智能方面一致。今天,数据中心正处于这一趋势的中心。

译者:boxi。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com