OpenAI华人VP翁荔辞职:北大同学,执掌安全,最近哔哩哔哩分享被热议。

就在刚才,那个执掌 OpenAI 北大安全学生,OpenAI 研究副总裁(安全)翁荔,离职了。

翁荔是 OpenAI 华人科学家,ChatGPT 其中一个贡献者。

翁荔在北大毕业后 2018 年加入 OpenAI,后来在 GPT-4 该项目主要从事预训练、强化学习与对齐、模型安全等工作。

最着名的 Agent 她还提出了公式,即:Agent= 大模型 记忆 主动规划 工具使用。

而且就在不久前,她也刚刚出现2024 Bilibili 很科学的晚活动,主题演讲已经发表。

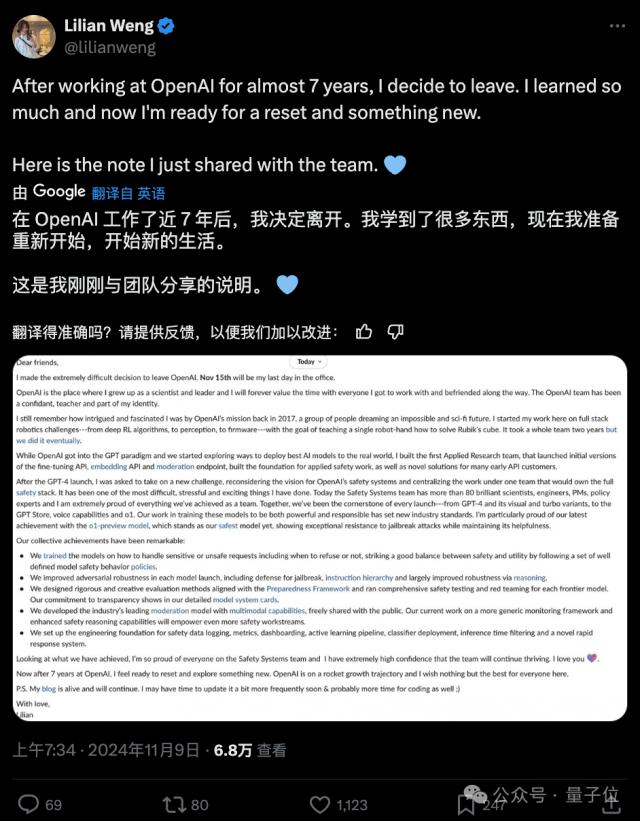

包括她宣布辞职的消息后, OpenAI 包括许多同事在内的祝福:

翁荔的离职信

翁荔还在推文中分享了他与团队的最后告别。

下面是离职信的完整内容。

亲爱的朋友们:

我已经做出了一个非常困难的决定,将会 11 月 15 日离开 OpenAI,那将是我在公司的最后一天。

OpenAI 这是我成长为科学家和管理者的地方,我将永远珍惜在这里与每一位合作伙伴共度时光。OpenAI 团队一直是我的知己、导师和身份的一部分。

我仍然记得 2017 年初加入 OpenAI 那时候的好奇和热情。那时候我们是一群抱着不可能和科幻未来梦想的人。

我在这里开始了我的全栈机器人挑战之旅——教一个简单的机械手如何解开魔方,从深度强化学习算法到感知,再到固件开发。这需要整个团队两年的时间,但最终我们成功了。

当 OpenAI 进入 GPT 在这个领域,我们开始探索如何把最先进的 AI 模型应用于现实世界。我成立了第一个应用研究团队,推出了微调初始版本。 API、嵌入 API 以及审核节点,为应用安全工作奠定了基础,也为早期工作奠定了基础。 API 顾客开发了许多新颖的解决方案。

在 GPT-4 发表之后,我被要求承担新的挑战,慎重考虑 OpenAI 安全系统愿景,并将各种工作集中在一个负责整个安全系统的团队中。

这是我经历过的最困难、最紧张、最刺激的事情之一。现在,安全系统团队拥有超过 80 一位优秀的科学家、工程师、项目经理、政策专家,我为我们作为一个团队所取得的一切成就感到非常自豪。

我们见证了每一次发布的关键—— GPT-4 及其视觉和 Turbo 版本,到 GPT Store、语音功能和 01 版本。为了达到负责任和有益的目标,我们在实践这些模型时设定了新的行业标准。

我特别给了我们最新的成就。 o1 预览版本感到自豪,它是迄今为止我们最安全的模型,在保持模型有用性的同时,表现出优异的抗破解能力。

我们的集体成就引人注目:

我们的训练模型如何处理敏感或不安全的要求,包括什么时候拒绝或不拒绝,遵循一套明确的模型安全行为政策,实现安全与实用的良好平衡。

在每一次模型发布中,我们都提高了对抗性鲁棒性,包括针对破解的防御、指令层次结构,并通过推理大大提高了鲁棒性。

我们制定了严格而富有创意的测试方法,使模型与准备框架一致,并对每一个前沿模型进行了全面的安全测试和红队测试。

在详细的模型系统卡中,我们加强了对透明度的承诺。

我们开发了行业内领先的审批模式,具有多模式能力,并免费与公众分享。目前,我们正在朝着更通用的监控框架和增强安全推理能力的方向工作,这将赋能更多的安全工作流程。

我们为安全数据日志、测量、仪表盘、自主学习管道、分类器布局、推理时间过滤和新的快速响应系统奠定了基础。

回顾我们的成就,我为安全系统团队中的每一个人感到非常自豪,我非常确信这支团队将继续蓬勃发展。我爱你。

在 OpenAI 七年后,我准备重新起航,探索一些新的领域。OpenAI 正沿着火箭般的轨迹前进,我衷心祝愿这里的每个人一切顺利。

注意:我的博客将继续更新。或许我会有更多的时间更新它。 & 也许还会有更多的时间编写代码。 。

爱你们的,

Lilian

铁打的 OpenAI,安全主管流水

自 OpenAI 自成立以来,安全主管这一关键职位经历了多次更换。

最早在 2016 年,OpenAI 安全主管由达里奥 · 阿莫代伊(Dario Amodei)在他的带领下,安全系统团队致力于降低当前模型和产品的滥用风险,尤其是围绕着当前模型和产品, GPT-3 对安全性进行了深入研究。

由阿莫代伊主导 GPT-3 为确保模型在发布前经过层层安全测试和评估,全面安全评估,最大限度地降低隐性乱用风险。

他在 OpenAI 后来,人工智能安全管理为工作奠定了重要保障。

2021 2008年,阿莫代伊离开 OpenAI 创立了 Anthropic 公司继续致力于人工智能安全研究,推动建设更可信、更安全的企业 AI 模型。

继阿莫代伊之后,还有短暂的工作。 2 月度安全主管,亚历山大 · 马德里(Aleksander Madry)。

为了识别和缓解潜在的安全风险,他在职期间主要专注于评估新模型的能力,并进行内部红队检测。

尽管他的任期很短,但是他在红队检测和威胁预测方面的重要推动, OpenAI 安全实践提供了新的视角和方法论。

在 2023 年 7 月亮过后,马德里继续致力于“ AI 推理“相关工作,离开安全主管岗位。

后来他的第三位安全主管是杨 · 莱克(Jan Leike),在 2023 年 7 月至 2024 年 5 每月担任这个职位,和 Ilya 共同领导“非常对齐”项目,目标是在四年内处理超智能项目。 AI 对齐问题。

这段时间,杨 · 利用小模型监督和评估大模型的研究,莱克开辟了一种新的方法来实证和对齐超人能力模型。

这一方法对高级人工智能模型的理解和应对有着深远的影响。

但是,杨因为与公司在安全和产品优先方面的矛盾, · 莱克于 2024 年 5 月亮宣布辞职。

即便如此,他在对齐研究方面的贡献,为后续人工智能可控性研究奠定了理论和实践基础。

而且翁荔是于 2024 年 7 月担任 OpenAI 安全主管。

关于翁荔

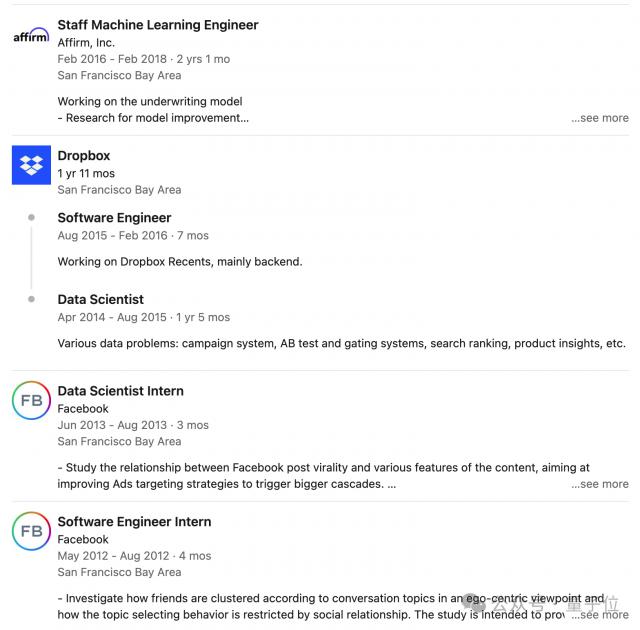

翁荔是 OpenAI 华人科学家,ChatGPT 其中一位贡献者,毕业于北大,在印第安纳大学伯明顿分校攻读博士学位。

翁荔毕业后,首先是短暂的。 Facebook 经过一段时间的实习,第一份工作就是在那里工作。 Dropbox,担任软件工程师。

她于 2018 年加入 OpenAI,在 GPT-4 该项目主要从事预训练、强化学习与对齐、模型安全等工作。

在 OpenAI 在去年年底成立的安全顾问团队中,翁荔领导安全系统团队(Safety Systems),减少当前模型的处理 ChatGPT 乱用等问题。

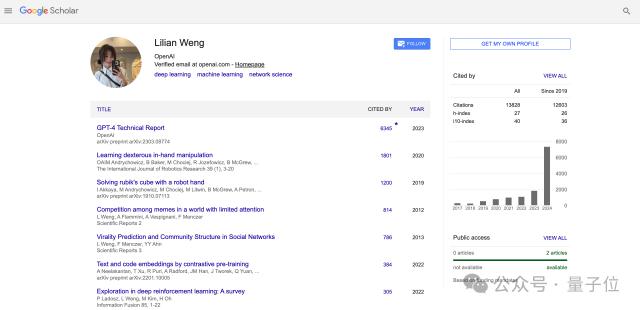

翁荔在 Google Scholar 引用量也达到了 13000 次。

她之前提出的建议LLM 外在幻觉(extrinsic hallucination)博文也很受欢迎。

翁荔专注于外部幻觉,讨论了三个问题:幻觉的原因是什么?幻觉测试,抵抗幻觉的方法。

有关研究细节,可以点击此处查看:万字 blog 详细说明抵抗方法,产生幻觉的原因和检测方法。

对翁荔离职后的去向,量子位将继续受到重视。

参考链接:

[ 1 ] https://x.com/lilianweng/status/1855031273690984623

[ 2 ] https://www.linkedin.com/in/lilianweng/

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com