大型训练被见习生攻击?字节跳动回应:已解雇

这名见习生在八月份被解雇了。

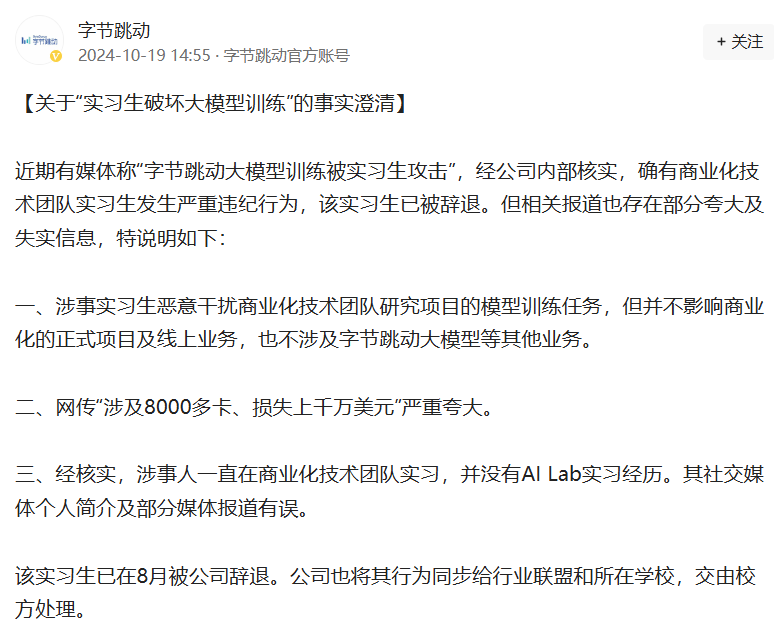

近日,有传言称,字节跳动大模型训练受到见习生的攻击。对此,10月19日,字节跳动回应称,经公司内部核实,确实有商业R&D团队的见习生违纪行为严重,已被辞退,但相关报道中也存在一些夸大和虚假信息。

字节跳动指出,与会者恶意影响商业R&D团队研究项目的模型培训任务,但不影响商业化的正式项目和在线业务,也不涉及字节跳动模型等相关业务。与此同时,网络爆炸严重夸大了“涉及8000多卡路里,损失数千万美元”。

字节跳动还表示,经核实,涉案人员一直在商业R&D团队实习,没有AI。 Lab工作经验。他的个人社交媒体介绍和一些媒体报道是错误的。此外,该见习生于8月被公司解雇。公司还将其行为同步交给行业联盟和学校,并交给学校处理。

10月18日,一则新闻在多个微信群中流传:“一家大型头部厂商的大型训练被一名实习生入侵,注入了破坏代码,导致训练结果不可靠,可能需要重新训练。据报道,入侵代码注入了8000多张卡,造成的损失可能超过1000万美元。”

随后,有媒体报道称,据知情人士透露,头部大公司是字节跳动。此事发生在今年6月,原因是某大学博士在字节跳动商业R&D团队实习。由于对团队资源配置的不满,他们使用攻击代码来破坏团队的模型训练任务。

谣言显示,该见习生使用了HF。(huggingface)在公司共享模型中写入破坏代码的漏洞,导致模型训练效果时高时低,无法产生预期的训练效果,AML团队无法审查原因。然而,谣言曝光后,这位见习生仍然在一个微信群里辟谣说,他发完论文就从字节跳动辞职了。另一个人钻了漏洞,改变了模型代码,把锅扣在了自己身上。

与安全性相关的大型模型问题引起了业界的高度关注。今年八月,中国信通院发文称,近年来,以大模型为核心的人工智能技术发展迅速,成为数字经济增长的新机遇。但是,大型模型作为一种新的生产力,在安全性方面仍然存在许多缺陷,这给其大规模落地应用带来了不确定性。近日,中国信通院发布的AI大型安全标准 Safety 根据Benchmark的检测数据,与原始输入相比,大模型(尤其是开源大模型)在恶意诱导方式下的攻击通过率明显提高。所以,对大型模型进行安全对齐保护刻不容缓。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com