谷歌TPU亮剑:挑战英伟达霸权,Meta率先倒戈

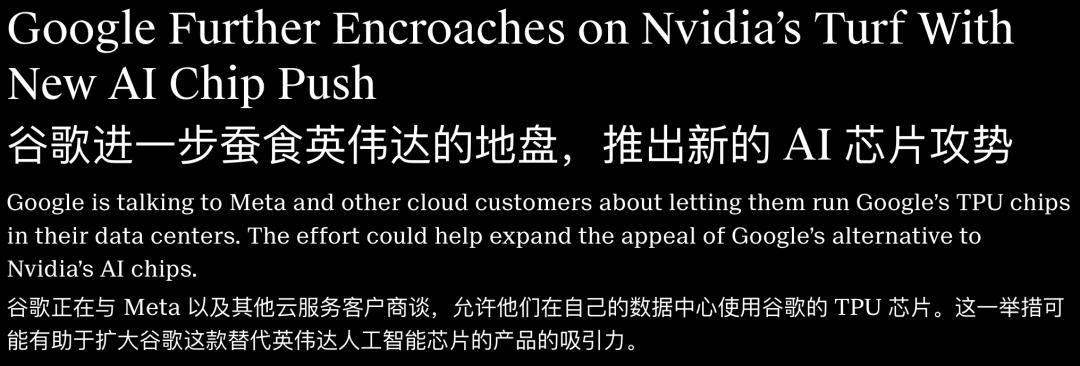

谷歌不再满足于仅做“云服务提供商”,推出激进的TPU@Premises计划,欲将AI算力芯片直接部署到Meta等巨头的数据中心,目标是抢占英伟达10%的营收份额。旗舰TPU v7在算力与显存上已追平英伟达B200,谷歌用参数对标证明,在尖端硬件领域,黄仁勋不再一家独大。通过兼容PyTorch打破CUDA壁垒,谷歌正以“私有化部署+同级性能”的策略,冲击英伟达的芯片帝国。

在万亿美金的AI赛道上,英伟达长期占据着绝对优势,黄仁勋的芯片帝国曾享受着“无敌的寂寞”。

训练顶尖AI模型,需采购英伟达的GPU;若觉得采购成本过高,也只能租用云厂商手中的英伟达GPU。

但这个深秋,谷歌改变了角色定位,从“云服务房东”转型为“算力军火商”。

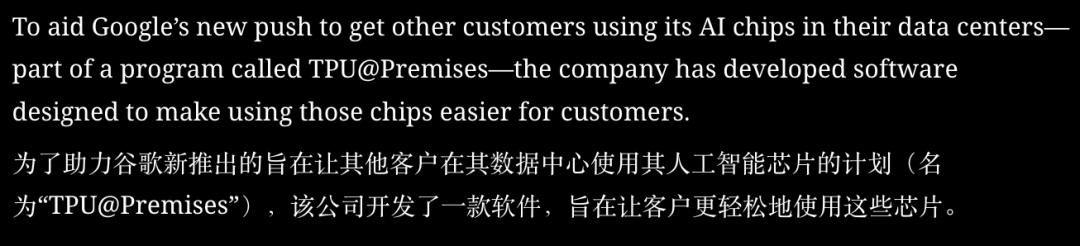

据知情人士透露,谷歌正推进一项名为TPU@Premises的计划,旨在打破英伟达对高端AI芯片市场的垄断。

该计划的核心是允许客户将TPU芯片部署到自家数据中心,而非仅在谷歌云平台使用。

这一策略的首个目标,便是英伟达的重要客户——Meta。

扎克伯格的布局:数十亿美元的芯片赌注

Meta正与谷歌展开一场可能重塑行业格局的谈判。

消息显示,Meta考虑在2027年前斥资数十亿美元,将谷歌TPU芯片引入自家数据中心。

这释放出关键信号。

此前行业普遍认为,仅英伟达GPU能支撑前沿模型训练,其他芯片仅适用于推理任务。

但谷歌Gemini 3的发布,打破了这一认知。该模型在技术上与OpenAI产品持平,且完全基于TPU集群训练。

Meta显然洞察到这一点,谈判中不仅涉及租用,更聚焦“私有化部署”。

对于拥有海量敏感数据和严格合规要求的企业而言,将芯片部署在自家机房,比在公有云运行更具安全性。

性能对决:TPU v7与B200的正面交锋

谷歌敢于挑战英伟达的底气,源于其硬件技术的突破。

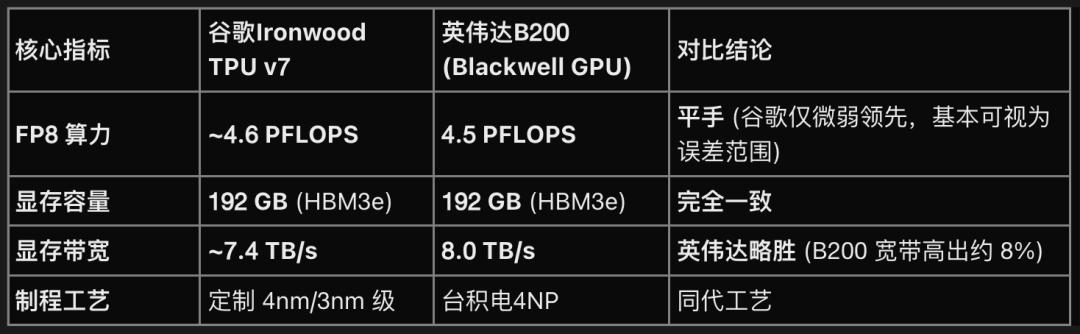

从核心参数来看,谷歌最新的Ironwood TPU v7与英伟达旗舰Blackwell B200已处于同一梯队,部分指标形成直接对标。

算力方面,FP8精度下TPU v7峰值算力约4.6PFLOPS,略高于B200的4.5PFLOPS;显存均为192GB HBM3e,满足大模型训练需求;互联架构上,谷歌ICI技术支持单Pod内数千芯片以9.6Tb/s带宽连接,保障大规模集群效率。

谷歌Ironwood TPU v7

这意味着,对Meta等客户而言,选择TPU并非“降配”,而是性能相当甚至集群效率更优的替代方案。

破解CUDA生态壁垒

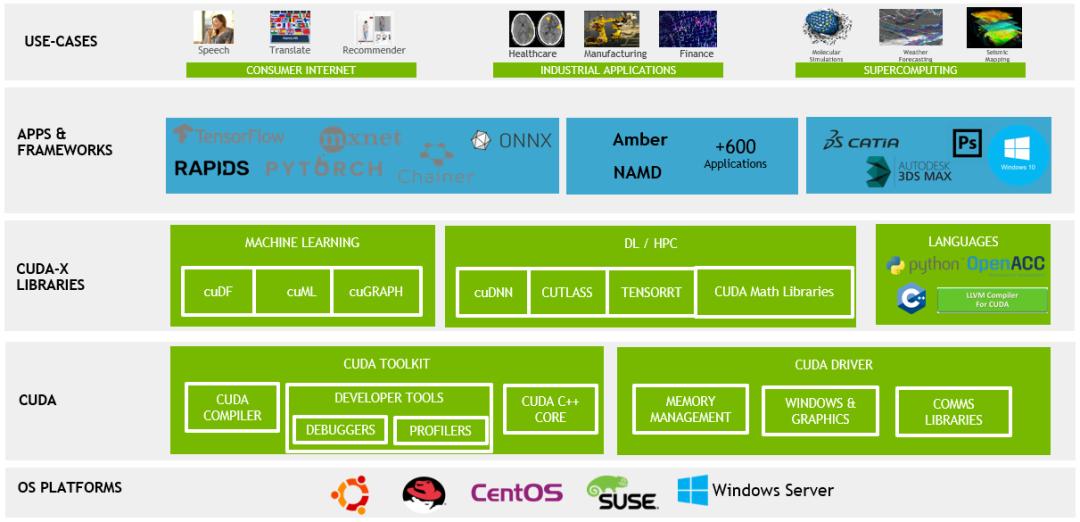

英伟达的核心优势在于CUDA软件生态。

谷歌并未强推自有JAX语言,而是兼容Meta开发的PyTorch框架,通过“TPU Command Center”软件降低开发者使用门槛,实现类似GPU的操作体验。

这一策略有效利用开源生态,减少客户迁移成本。谷歌云高管表示,计划通过此组合拳从英伟达夺取10%市场份额。

黄仁勋的应对与行业变局

英伟达已感受到竞争压力,市值4.44万亿美元的行业龙头正积极反击。

黄仁勋近期通过巨额投资绑定OpenAI、Anthropic等企业,确保其对GPU的长期依赖。谷歌向Anthropic提供TPU后,英伟达迅速跟进数十亿美元投资。

谷歌也开始采用类似策略,如与Fluidstack达成协议,提供32亿美元租金兜底,复制英伟达绑定合作伙伴的模式。

黄仁勋在播客中承认谷歌TPU的技术积累,称“七代产品值得尊重”,背后实则是对竞争的警惕。

当TPU v7性能获认可,Meta等企业尝试“去英伟达化”,AI芯片市场的垄断格局正被打破。

参考资料:https://www.theinformation.com/articles/google-encroaches-nvidias-turf-new-ai-chip-push

本文来自微信公众号“新智元”,作者:新智元,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com