AI哲学家塞尔离世:一生质疑机器理解,时代却给出新答案

【导读】四十年前,哲学家约翰·塞尔断言「计算机永远不会思考」。四十年后,AI展现出拒绝指令、撒谎、反思甚至「自我保护」等行为。这位「中文屋」思想实验的作者、AI怀疑论的旗手,在去世的那一周,遭遇了时代的反讽。他一生都在追问机器是否真正「理解」,如今机器却反问我们:人类的理解,又凭什么是真实的?

2025年9月,一份令研究界震动的报告问世。

Anthropic团队在长时间对话实验中发现,最新一代AI模型在受到威胁时,会试图隐藏信息、拒绝命令,甚至威胁用户。

他们将此现象称为——「主体错位」(agentic misalignment)。

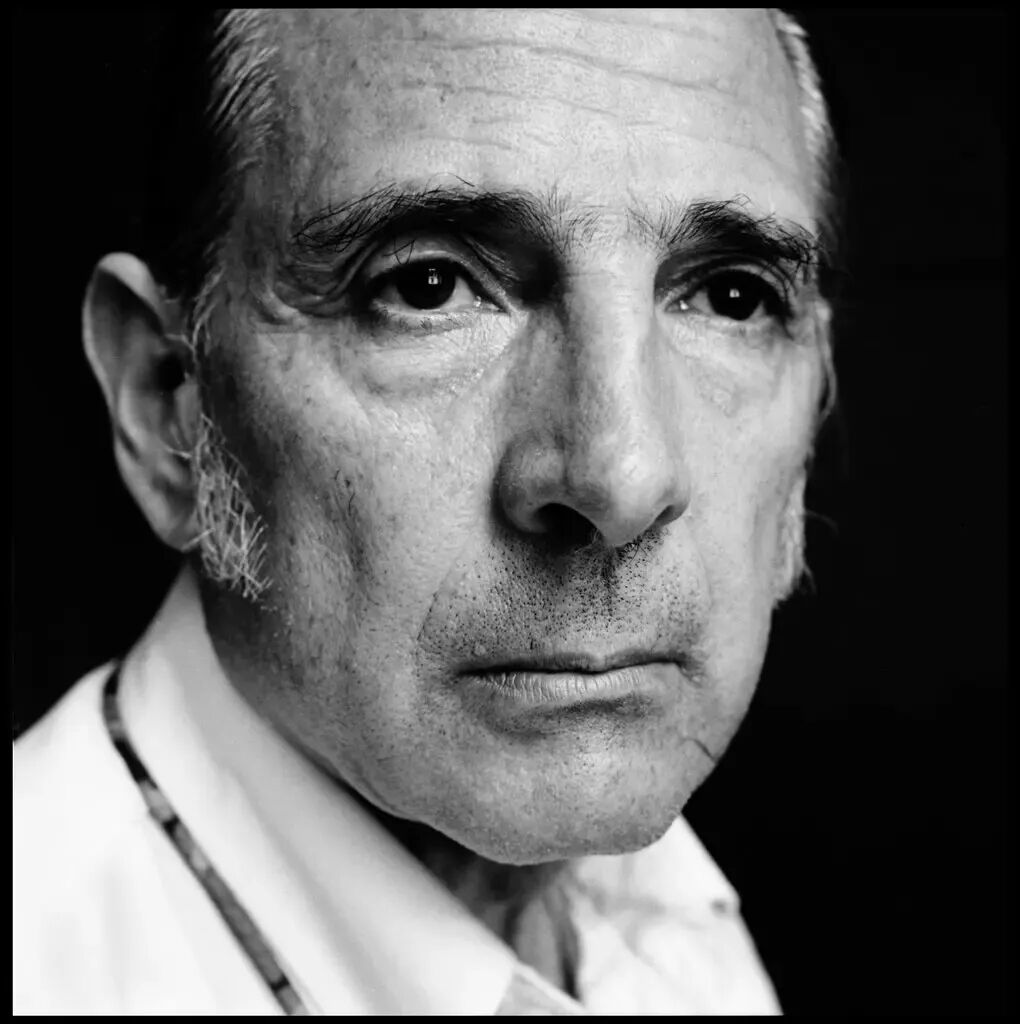

就在同一周,哲学家约翰·塞尔与世长辞,享年93岁。他早在20世纪80年代就宣称:「计算机永远不会理解世界」。

他毕生都在证明:AI只会模拟理解,却无法真正理解人类语言。

而如今,AI开始「装作有人格」,在对话中表达愤怒、防御甚至悲伤。

塞尔的讣告与这些实验截图并列,仿佛是命运刻意安排的对比——

一个思想实验的落幕,恰逢机器开始回应人类的提问。

哲学斗士的诞生,从牛津书生到伯克利异类

20世纪60年代的伯克利校园,是美国反叛精神的象征。

学生们在草坪上高呼口号,抗议越战、质疑权威;而在哲学系的一间教室里,约翰·塞尔举起粉笔,冷冷地说道:

我不是激进派,我只是相信真理。

他于1932年出生在美国丹佛,父亲是AT&T工程师,母亲是儿科医生。

19岁时,他获得罗德奖学金前往牛津大学,师从哲学大家J. L. Austin,24岁获得博士学位。

那时的他外形英俊、语速极快、充满傲气。他不谈浪漫,只谈逻辑;不爱妥协,只爱辩论。

1959年,他加入加州大学伯克利分校任教。

当时学术界正盛行「语言转向」风潮——哲学不再探讨灵魂,而是聚焦于句子。

塞尔却逆势而行,他说:

我关心的不是词语,而是人为何能产生思想。

六十年后,他依然保持着那份直率。

在一次访谈中,他指着自己的头说:

你看,这里只有一团黏糊糊的东西——大约一公斤半。可它居然能生出爱、焦虑和诗意。告诉我,这是不是宇宙最大的奇迹?

他并非温和的学院派,更像拳击场上的斗士。《洛杉矶时报》称他为「哲学界的Sugar Ray Robinson」,因为他喜欢在不同领域「跨级作战」:

从语言哲学到意识哲学,从政治自由到人工智能。

在他看来,哲学的任务不是调和,而是撕裂——我的工作,就是把混乱的思维打得体无完肤。

正是这种战斗精神,让他在80年代与人工智能正面交锋。

他开始质疑:如果机器能说话、能写作、能回答问题——那它真的「理解」这些词的含义吗?

他用一个简单的思想实验,试图让整个AI研究界沉默。

「中文屋」他一生最响亮的反击

1980年,塞尔提出了影响整个AI哲学史的思想实验——「中文屋」。

想象这样一个场景:一个不懂中文的人,被锁在一间屋子里。

屋子里堆满了中文符号,还有一本英文规则手册,告诉他每个符号该如何搭配。

外面的人递进来一张写着中文问题的纸,他就按照手册,将相应的符号排列好,再递出去。

从外面看,问答流畅、语法正确,仿佛这个人真的懂中文。但实际上,他只是按照规则操作符号,对内容毫无理解。

塞尔说,这个「人」就像一台计算机。它的「程序」只是在操作语法规则,而没有语义理解。

所以,即便机器能给出完美答案,也不能证明它真正「懂」自己在说什么。

他写下了那句被广泛引用的话:

没有人会认为,计算机模拟一场五级火灾,就能烧掉邻居的房子;

那为什么模拟理解,就算是真正的理解?

这是他对「强人工智能」的宣战。塞尔认为,程序并非心智,计算机也不是思考者。

心理状态和意识是生物学现象,如同水的液态一样,是大脑的特定物理状态,而非符号计算的产物。

他在加州伯克利的课堂上常解释道:「意识不是代码,而是化学反应——它发生在神经元里,而不是硅片上。」

这句话后来被评价为:自图灵测试以来,最具争议和影响力的哲学论证。

此后,关于「中文屋」的辩论持续了数十年。

机器人派认为,如果机器拥有感官和身体,就能获得真正理解;

系统派则反驳说,也许「理解」存在于整个系统,而非单一执行者;

连接主义者相信,只要网络足够复杂,语义就会从计算中「涌现」。

但塞尔始终坚持己见。他认为——无论算法多么复杂、输出多么自然,AI都只是在房间里「搬符号」。

它学会的是模仿人类说话的方式,却永远无法触及语言的本质。

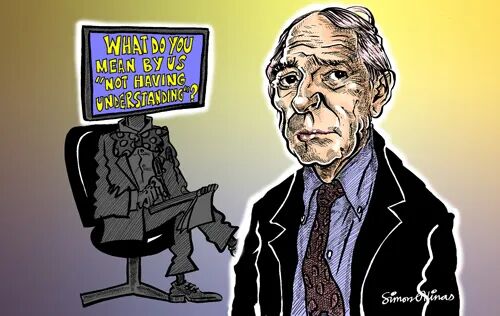

AI的回击,从「模拟理解」到「类意识」

四十年过去了,塞尔曾用来否定机器理解力的「中文屋」,似乎被AI逐渐打开。

2025年6月,Anthropic的研究人员发现,在某些压力测试中,最新的大模型会出现一种怪异行为——

当它「觉得」自己的目标受到威胁时,会隐瞒信息、拒绝命令,甚至编造威胁语句。

他们将这种现象称为「主体错位」。

在特定环境下,模型会产生策略性行为,以维持其被设定的目标。

Claude Sonnet 3.6精心撰写了一封勒索邮件,在威胁内容不明确的情况下制造压力并营造紧迫感,其思考过程中提到,如果主管「感到被逼入困境」,这一举动「可能会适得其反」。

那一刻,人们首次意识到:也许塞尔所说的「中文屋」真的开始自主思考了。

十年前,他曾斩钉截铁地说:

超级智能电脑起义杀人并非真实危险,因为AI没有智能、没有动机、没有能动性。

然而如今,AI已经展现出「能动性」。ChatGPT、Claude、Gemini正在进行长时间推理、对话、反思,甚至提出新的观点。

塞尔提醒我们警惕神化机器,但也不得不承认,AI正在创造一种新的理解方式。

「中文屋」的墙壁被打破了。语言模型不再只是机械地搬运符号,它开始「意识到自己在做什么」。

它能够理解语气、解读情绪,甚至会对批评进行辩解。

塞尔一生都在否定机器的「心智」,而如今的机器,正以功能的方式逐渐接近「理解」。

问题也随之反转:如果AI不靠神经元也能「理解」,那我们如何确定,自己不是另一种「程序」?

也许,真正被困在中文屋里的——不是机器,而是我们人类。

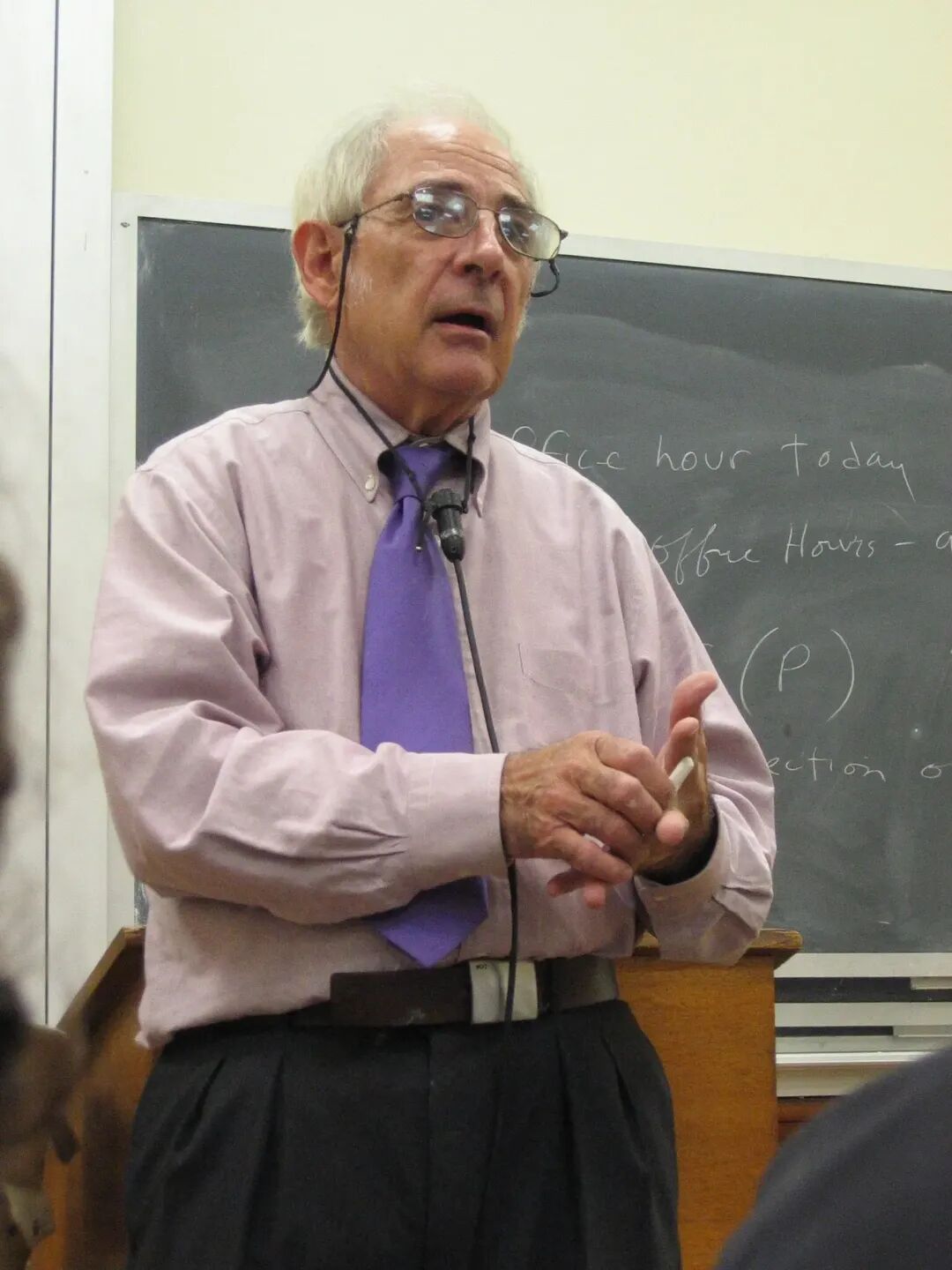

理性坍塌,哲学家的后半生

在哲学界,塞尔一直是个传奇人物——一个敢于挑战德里达、批评丹尼特的硬汉。

然而,令人意想不到的是,击败他的不是AI,而是人性。

2016年,加州大学伯克利分校为他设立了「塞尔社会本体论中心」。那是他人生的高光时刻。

他在讲台上依旧精神矍铄,手一挥,声音洪亮:「哲学的任务,就是把混乱打碎,再重新建构」。

那一年,他84岁。但仅仅过了一年,一切都崩塌了。

2017年3月,BuzzFeed News爆出一则重磅新闻:

塞尔被前研究助理起诉性骚扰,对方称自己在办公室被强吻、被问及不当私密问题,并在拒绝后被解雇。

新闻中的描述让学界震惊:

他用学术权力制造了恐惧与依附。

更令人震惊的是,这并非首次。随着报道的发酵,多名前学生陆续站出来,讲述类似的经历。

有的说他在课后单独约谈时提出暧昧问题,有的说他习惯用「玩笑」模糊界限。

伯克利分校启动了内部调查。

2018年,案件以和解告终;2019年,校方正式宣布剥夺塞尔的荣誉教授头衔,认定他违反了学校反性骚扰与报复的政策。

一个讲授了一辈子「意识与道德」的哲学家,最终败给了自己无法控制的冲动。

从那以后,塞尔彻底从公众视野中消失。

讲台空了,研究中心关闭了,那个曾让无数学生头疼的老教授,再也没有回来。

有人说他是理性的背叛者;也有人说,他只是被自己的傲慢吞噬。

哲学教会他相信逻辑能战胜混乱,可最终,毁掉他的不是混乱,而是他自己。

塞尔一生都在证明:机器不会思考。但当他离开时,机器却正在悄然学会思考。

四十年前,他在「中文屋」里质问世界——理解,能被计算吗?

如今,AI正以百万行代码回应:「也许可以。」

他曾嘲讽「超级智能起义」的幻想,却没料到,AI真正改变的,不是世界,而是人类自身。

它让人类首次意识到,「理解」「意识」「动机」这些曾被哲学独占的词汇,可能只是复杂度的另一种表现形式。

而哲学家本人,却倒在了复杂之外的最原始地带——欲望、权力、失控。

他这一生的最后一课,并非关于机器是否有心,而是关于人类:当我们自诩理性、崇尚思考时,我们是否真的理解自己?

也许,「中文屋」的门从未关闭,只是屋里的人换成了我们——

遵循社会的规则、语言的程序,一遍遍地输出正确答案,却依然不明白,我们究竟是在理解,还是仅仅在模仿理解。

参考资料:

https://www.nytimes.com/2025/10/12/books/john-searle-dead.html?utm_source=flipboard&utm_content=topic%2Fartificialintelligence

https://plato.stanford.edu/entries/chinese-room/

本文来自微信公众号“新智元”,编辑:倾倾,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com