英伟达新GPU来袭,性能远超当前旗舰

英伟达推出了Rubin CPX GPU,将推理阶段拆分进行,效率提升可达6.5倍,预计2026年出货。

通过发布Rubin CPX,英伟达把推理计算过程分成上下文与生成两个阶段,分别由两块GPU运算,效率最高能达到现有旗舰机架的6.5倍。

全球人工智能算力芯片龙头英伟达周二宣布,推出专门为长上下文工作负载设计的专用GPU Rubin CPX,旨在让当前AI推理运算的工作效率翻倍,尤其适用于编程、视频生成等需要超长上下文窗口的应用。

英伟达CEO黄仁勋表示,CPX是首款为需要一次性处理大量知识(数百万级别tokens)并进行人工智能推理的模型打造的芯片。

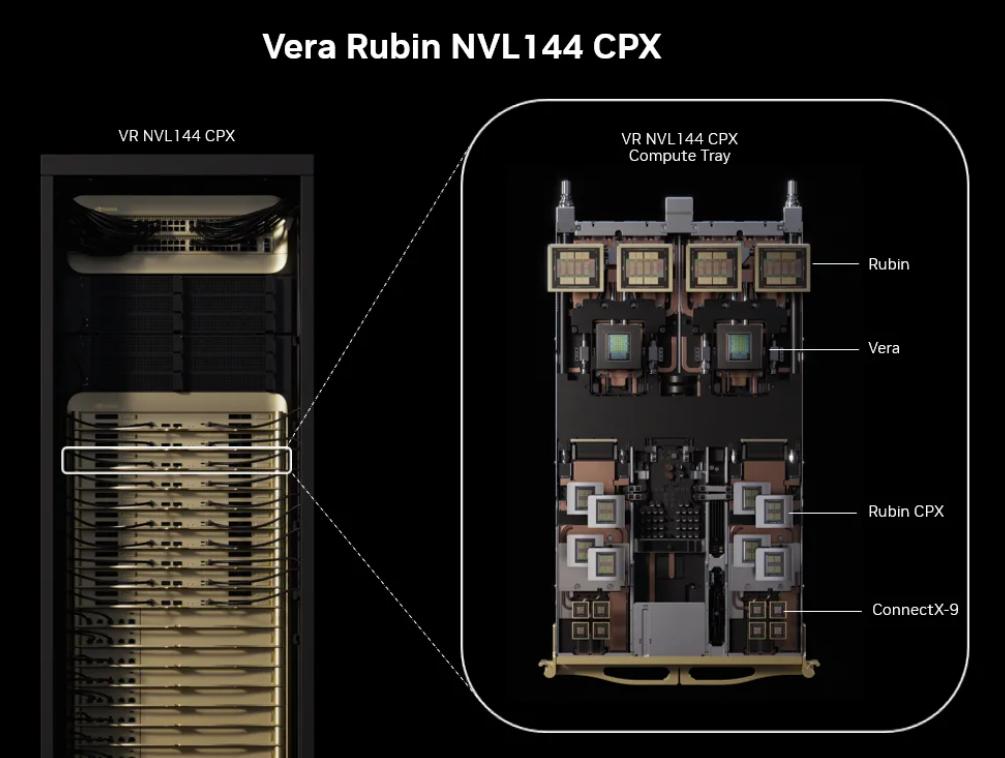

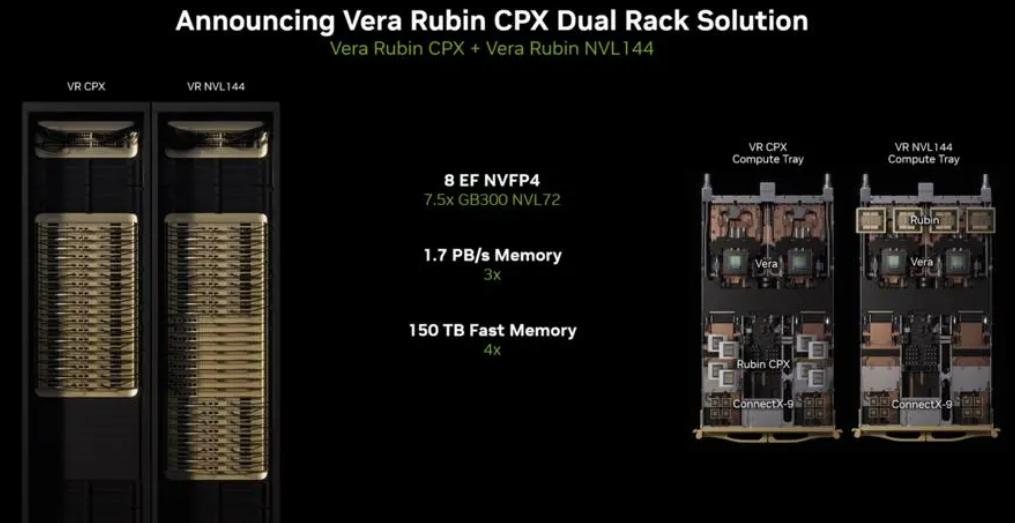

需要说明的是,Rubin是英伟达明年发售的下一代顶级算力芯片,所以基于Rubin的CPX预计要到2026年底出货。下一代英伟达旗舰AI服务器全称是NVIDIA Vera Rubin NVL144 CPX,它集成了36个Vera CPU、144块Rubin GPU和144块Rubin CPX GPU。

(NVIDIA Vera Rubin NVL144 CPX机架与托盘,来源:公司博客)

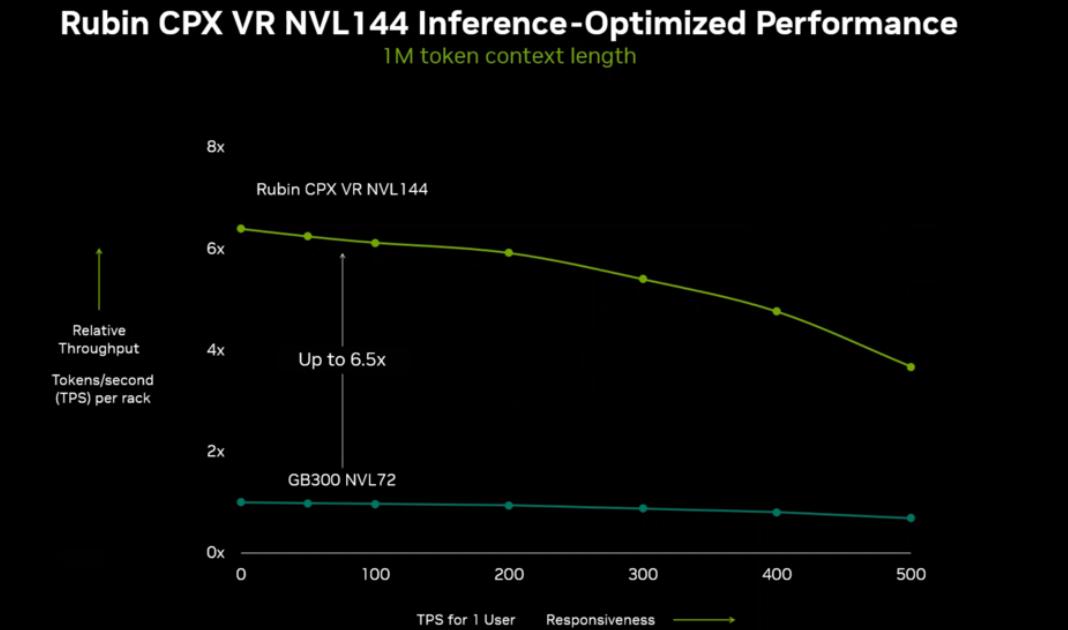

英伟达透露,搭载Rubin CPX的Rubin机架在处理大上下文窗口时,性能比当前旗舰机架GB300 NVL72最多高出6.5倍。

据悉,下一代旗舰机架将提供8exaFLOPs的NVFP4算力,比GB300 NVL72高出7.5倍。同时单个机架就能提供100TB的高速内存和1.7PB/s的内存带宽。

英伟达在Rubin GPU边上再配一块Rubin CPX GPU,是为了显著提升数据中心的算力效率,让用户购买英伟达芯片能赚更多钱。英伟达表示,部署价值1亿美元的新芯片,能为客户带来50亿美元的收入。

为何需要两个GPU?

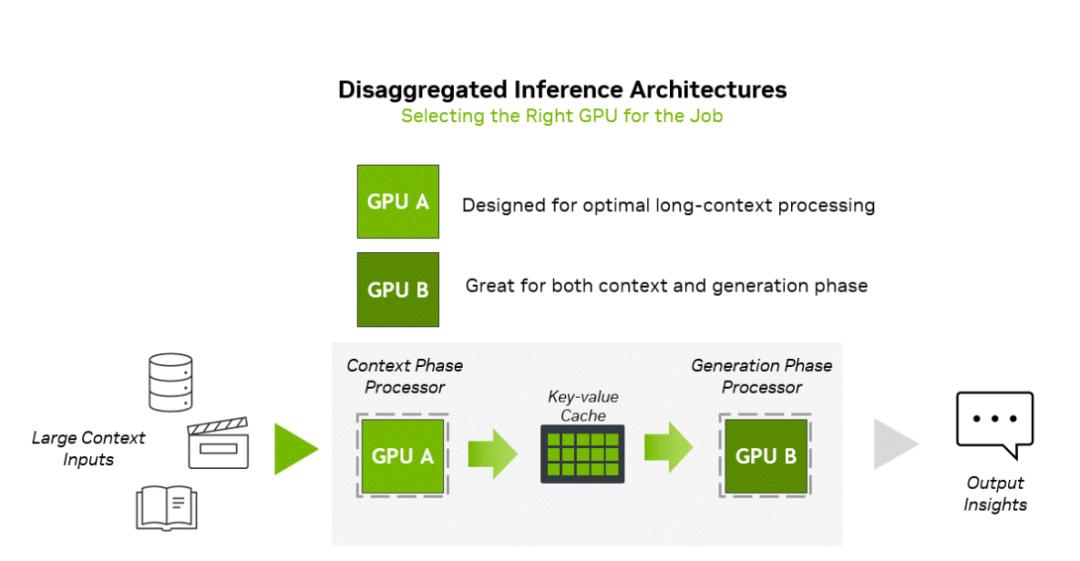

作为行业首创,英伟达的新品在硬件层面拆分了人工智能推理的计算负载。

英伟达介绍,推理过程有两个截然不同的阶段:上下文阶段与生成阶段,这两个阶段对基础设施的要求本质上完全不同。

上下文阶段属于计算受限,需要高吞吐量的处理能力来摄取并分析大量输入数据,从而生成首个输出token。相反,生成阶段属于内存带宽受限,依赖高速的内存传输和高带宽互联(如NVLink),以维持逐个token的输出性能。

当前顶级的GPU是为内存和网络限制的生成阶段设计的,配备昂贵的HBM内存,但在解码阶段并不需要这些内存。因此,通过分离处理这两个阶段,并针对性地优化计算与内存资源,能显著提升算力的利用率。

据悉,Rubin CPX专门针对“数百万tokens”级别的长上下文性能进行优化,具备30petaFLOPs的NVFP4算力、128GB GDDR7内存。

英伟达估计,大约20%的AI应用会“坐等”首个token出现。例如解码10万行代码可能需要5 - 10分钟。多帧、多秒的视频,预处理和逐帧嵌入会迅速增加延迟,这也是当前视频大模型通常仅用于制作短片的原因。

英伟达计划以两种形式提供Rubin CPX,一种是与Vera Rubin装在同一个托盘上。对于已经下单NVL144的用户,英伟达也会单独出售一整个机架的CPX芯片,数量正好匹配Rubin机架。

本文来自微信公众号“科创板日报”,作者:史正丞,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com