AI偷声乱象:从明星带货到个人诈骗,你的声音安全吗?

你是否常在铺天盖地的网络短视频中遇到“AI配音”的视频?如今,经典的悟空四郎等音效,你一定不陌生。

“声音克隆”技术已集成进各种短视频和AI平台,用户只需录一小段自己的说话声,AI就能“复制”出声音和语气。

然而,这也意味着你的“声音”可能被偷走、被利用,后果不堪设想。

你或许刷到过奥运冠军“全红婵”卖鸡蛋的视频。视频里,“全红婵”戴着口罩对镜头说:“我是你们的婵宝,今天有事请大家帮忙。婵妹就想着帮助妈妈,让家里的生活过得更好一点,同时把老家的土鸡蛋分享给粉丝们尝尝……”不少网友听到声音后购买支持,商品购买次数高达47000次。

全红婵家人表示,这些声音是AI生成的。除了全红婵,奥运冠军孙颖莎、王楚钦等也被用于短视频商户推销鸡蛋,报道显示,短视频上的声音是AI偷走克隆的,这些奥运冠军并未参与代言和授权。

你在短视频网站上见过AI克隆明星带货的视频吗?

去年雷军也曾陷入被AI仿冒恶搞的困境,网络上出现大量“恶搞雷军AI配音”的视频,用他的形象和声音发布不实发言、锐评甚至极端内容,雷军本人不得不呼吁大家不要再玩雷军语音包。

2024年在美国,乔·拜登的声音被克隆,电话打到选民家中,告知不要在周二的总统初选中投票。

普通人的声音被偷走也很危险。骗子可能用你的AI声音诱导亲人或朋友汇款或泄露敏感信息。

网络安全公司McAfee的调查显示,70%的人分辨不出克隆声音和真实声音的区别,7.7%的人被AI克隆声音骗过钱。其中,36%损失500至3000美元,7%被骗5000 - 15000美元。

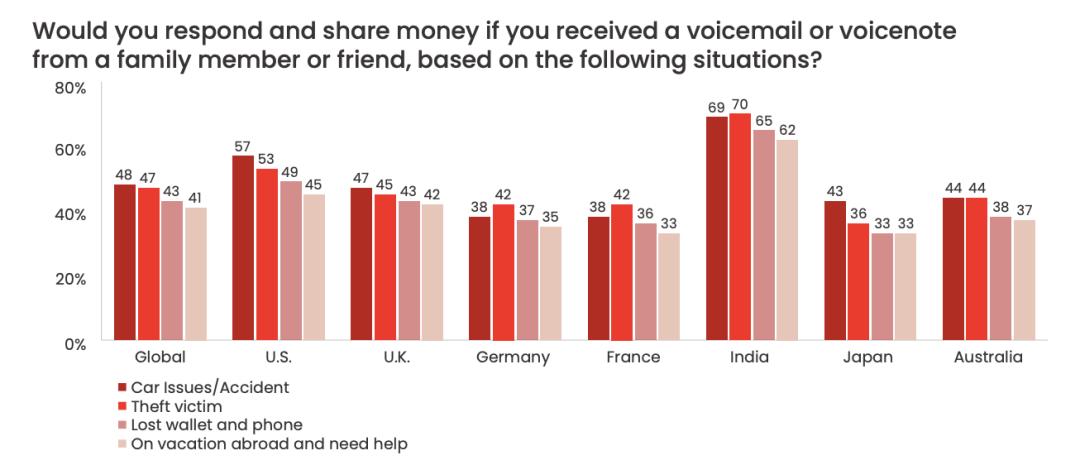

调查还揭示,45%的诈骗是假冒朋友或家人发来语音消息,请求来自伴侣或配偶(40%)、母亲(24%)或孩子(20%)。消息内容包括车祸(48%)、遭受抢劫(47%)、丢了手机或钱包(43%)和出国旅行时的意外(41%)。

这种诈骗属于“鱼叉式网络钓鱼”,有针对性地对特定目标进行诈骗和攻击。AI让这类诈骗更普遍,也更难检测。

因此,及时联系亲友做好事实核查很重要。银行信息安全官提醒,可以与亲人约定一个“安全短语”,用于电话验证身份。

老年人等对新型科技手段不熟悉的人更容易被骗,提醒家里的老年人并约定验证身份的方式十分必要。

更可怕的是,骗子偷走“声音”的难度比想象中小。McAfee研究人员发现,3秒钟的音频就足以生成匹配度达85%的克隆语音,加入训练数据,匹配度可达95%。

一些AI音频生成软件还能克隆人声的“呼吸声”,改变说话时的环境音。

那么,骗子从哪些渠道偷走你的声音呢?

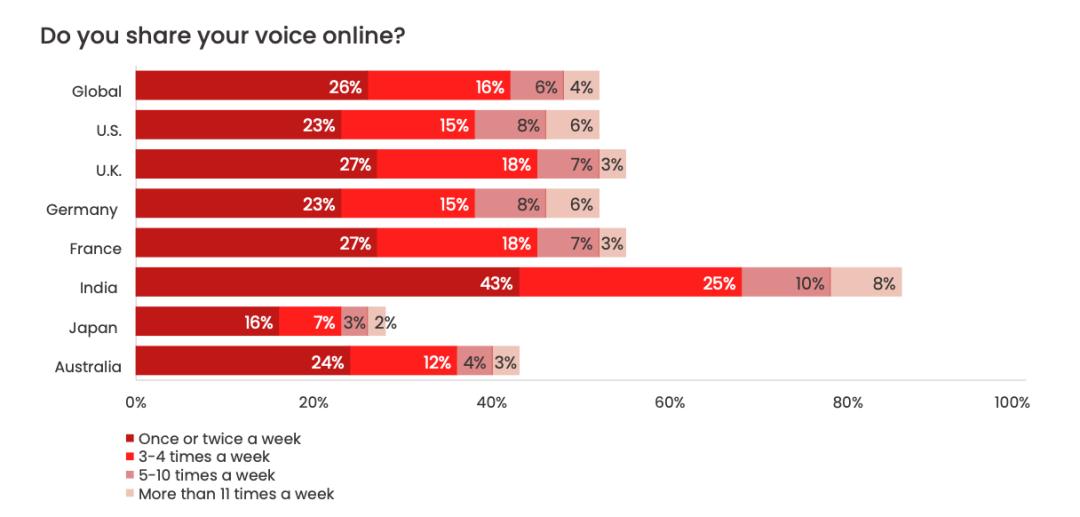

一是社交媒体、电话发布的已有视频中的声音;二是使用软件时,没仔细看的用户协议可能已将声音“授权”给软件。

网络上分享声音很普遍,平台和软件缺乏监管保护,声音易被盗取。

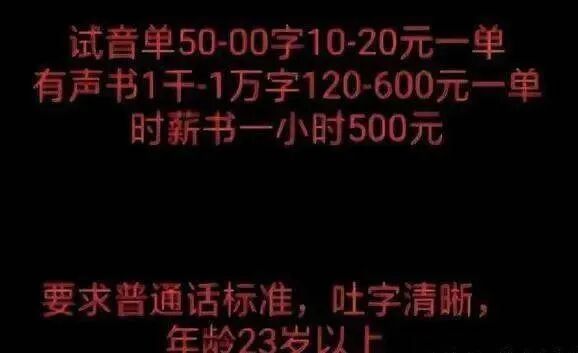

三是标榜赚钱的骗局,如一些有声书“兼职配音”的线上试音,可能是骗取个人隐私和声音的手段。

这种“配音兼职”有刷单、诈骗和盗取个人资料的风险,要保持警惕。

我国正在出台监管手段,整治AI克隆声音的乱象,帮助受害者维权。

2020年,《民法典》首次将声音纳入法律保护,非法模仿他人声音可能构成侵权。2024年,北京互联网法院判决两家公司向一名配音演员赔偿25万元,这是中国首例保护语音权免遭人工智能克隆的法律判决。

2025年9月1日起施行的《人工智能生成合成内容标识办法》明确,服务提供者应对文本、音频等生成合成内容添加显式标识。

参考资料

[1]https://www.mcafee.com/ai/news/ai-voice-scam/#:~:text=These%20tools%20required%20only%20a,small%20number%20of%20audio%20files.

本文来自微信公众号“把科学带回家”(ID:steamforkids),作者:Skin,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com