OpenAI研究员:提示词工程已到尽头,新范式引发辩论

07-16 06:57

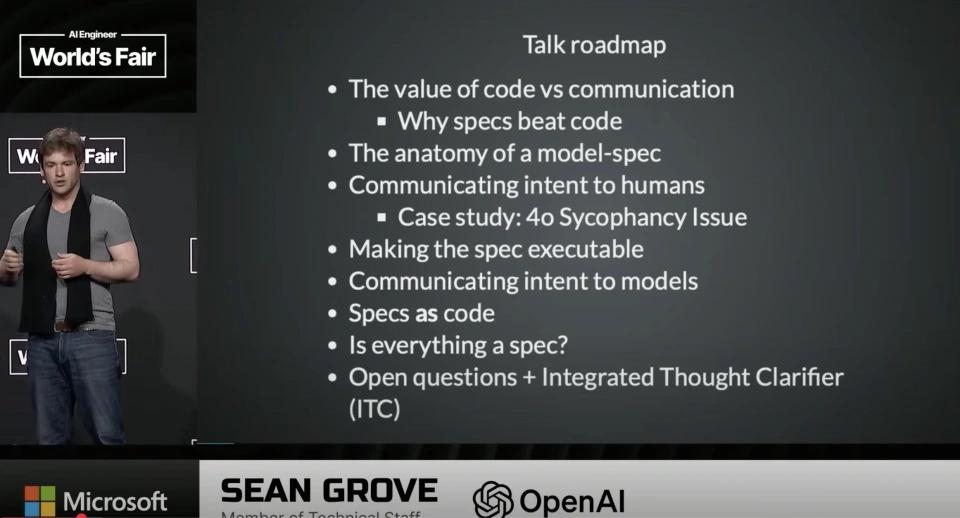

目前,硅谷正就AI开发范式展开一场激烈辩论。继AI大神安德烈・卡帕西(Andrej Karpathy)力推“上下文工程”(context engineering),宣告提示词工程(prompt engineering)过时后,OpenAI顶级对齐研究员肖恩・格罗夫(Sean Grove)也提出相同观点,认为提示词工程确实过时了,同时他指出未来应属于“规范化编程”(spec - writing)。

两条路径,一个共识:提示词工程的末日

两种方法的本质区别

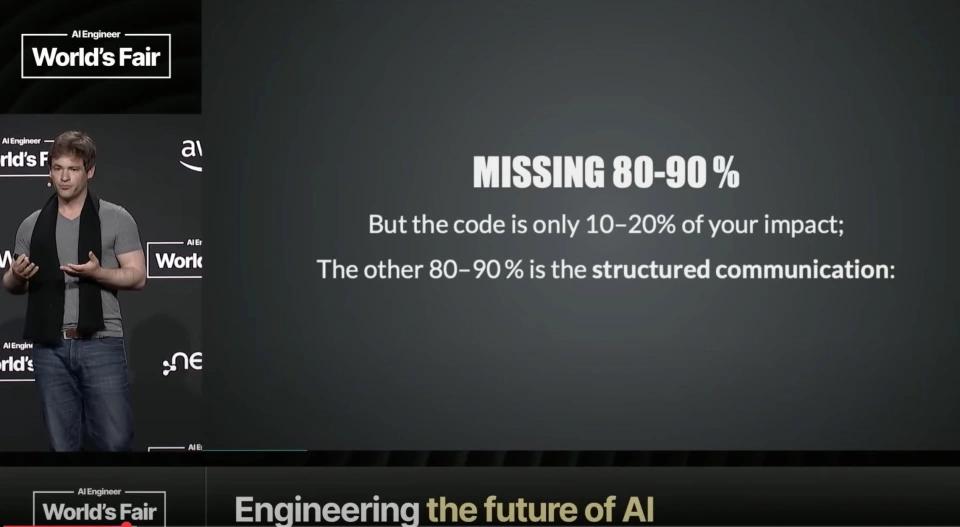

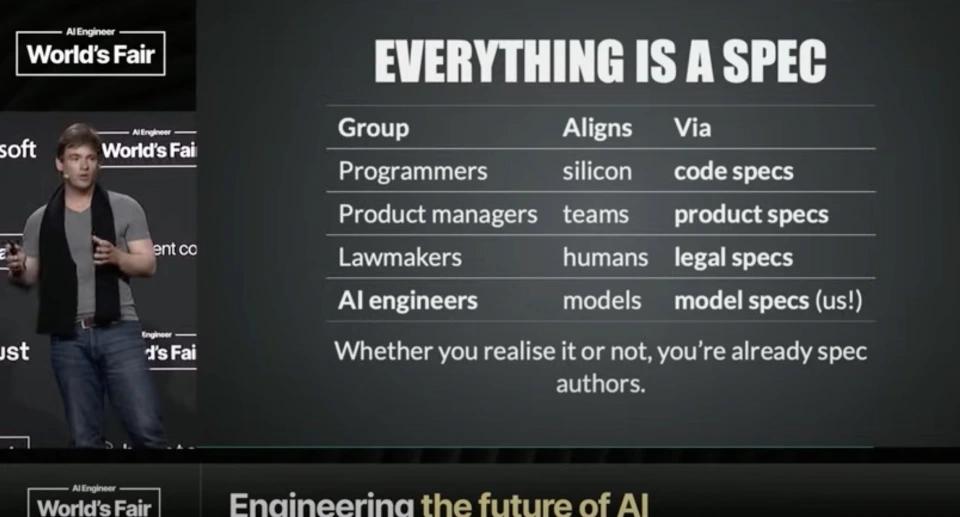

总结来说,两位专家虽都反对传统提示词工程,但解决方案思路迥异。卡帕西的上下文工程专注于“如何更好地与AI沟通”,认为智能体失败源于“上下文的失败”,即无法在恰当时机、以恰当格式提供恰当信息。其核心是系统化收集、组织和传递信息,通过优化输入提升AI表现,强调 “长期记忆”对动态管理历史数据的作用。这是“输入优化”思路,假设目标明确,关键是高效传达。格罗夫的“规范化编程”则聚焦“如何明确我们真正想要什么”,认为AI开发的问题源于人类对自身目标的模糊认知。

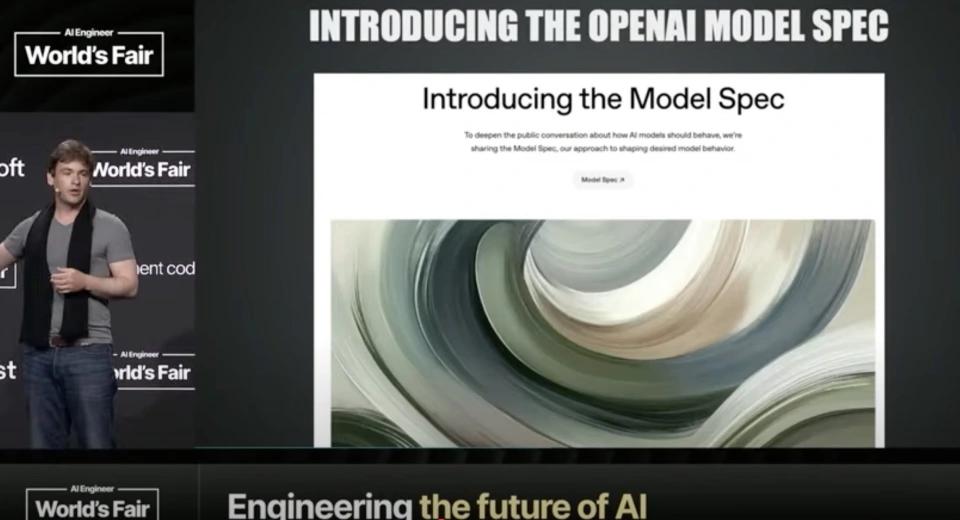

OpenAI内部实践:Model Spec的成功验证

本文来自微信公众号“腾讯科技”,作者:无忌,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com