Meta 推出 CATransformers 框架,AI 减排新利器

IT 世家 5 月 15 科技媒体日新闻 marktechpost 昨日(5 月 14 日本)发布博文,报道称 Meta AI 旗下 FAIR 团队与佐治亚理工学院合作,合作开发 CATransformers 框架,以碳排放为核心设计考虑,通过联合优化模型架构和硬件性能,显著降低总碳足迹,是可持续的 AI 发展迈出重要一步。

机器学习技术的普及推动了从推荐系统到自动驾驶的创新,但其环境成本不容小觑。这些系统需要强大的计算资源,经常依靠定制的硬件加速器运行。实践和推理阶段的高能耗直接导致运行碳排放的增加。

此外,硬件从制造到报废的整个生命周期也产生了“隐含碳”,增加了生态负担。随着全球各行业的加速选择 AI 技术、处理和操作以及隐含碳的多重来源已成为迫切需要。

目前的减排方法主要是提高运营效率,比如优化训练和推理的能耗,或者提高硬件利用率。但这些方法往往忽略了硬件设计和制造阶段的碳排放,未能整合模型设计和硬件效率之间的相互作用。

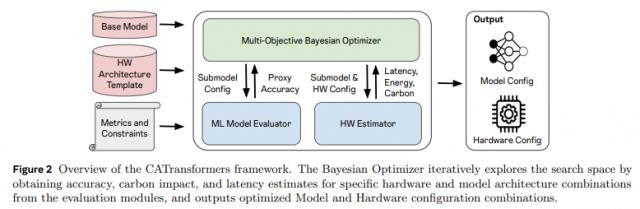

Meta 的 FAIR 由佐治亚理工学院联合推出的团队 CATransformers 框架,将碳排放纳入核心设计考虑。该框架通过多目标贝叶斯优化引擎,共同评估模型架构和硬件加速器的性能,平衡延迟、能耗、精度和总碳足迹。

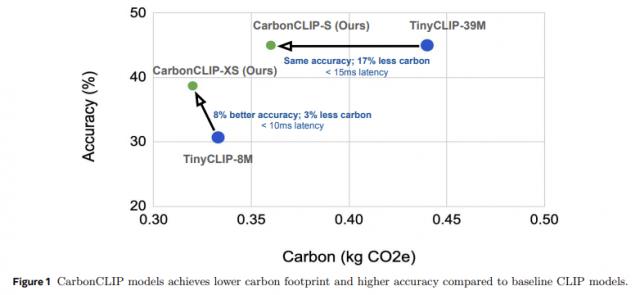

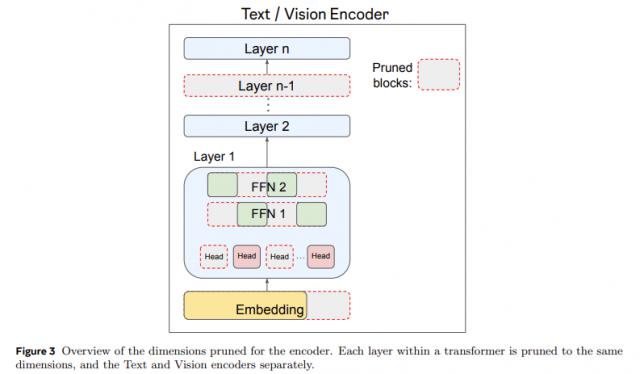

尤其针对边缘推理设备,CATransformers 大规模修枝 CLIP 结合硬件估算工具,模型生成组合,分析碳排放和性能。其成果 CarbonCLIP-S 与 TinyCLIP-39M 虽然精度相当,但是碳排放减少了 延迟保持在17% 15 ms内;CarbonCLIP-XS 则比 TinyCLIP-8M 精度提高 碳排放减少8% 延迟低于3% 10 ms。

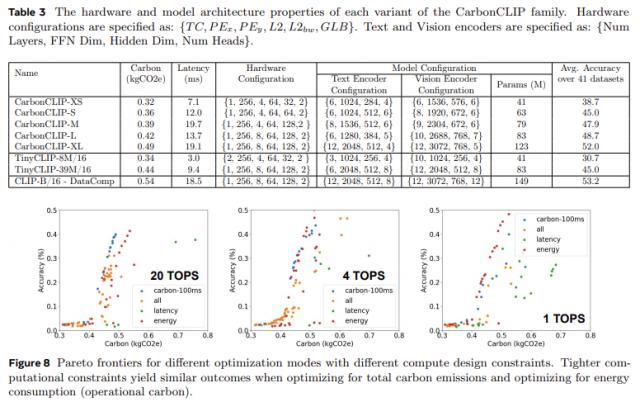

研究表明,简单的推迟设计可能会导致隐含碳增加高达 2.4 两倍,综合提高碳排放和延迟的策略可以实现 19-20% 总排放减少,延迟损失极小。

CATransformers 为可持续机器学习系统的设计奠定基础,通过嵌入环境指标。这表明,AI 如果从一开始就考虑到硬件能力和碳的影响,开发可以实现性能和可持续性的双赢。伴随着 AI 随着规模的不断扩大,这一框架为行业提供了有效的减排路径。

IT 这个家庭还附有一个参考地址

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com