Gemma33,谷歌宣布开源多模式。 堪比DeepSeek

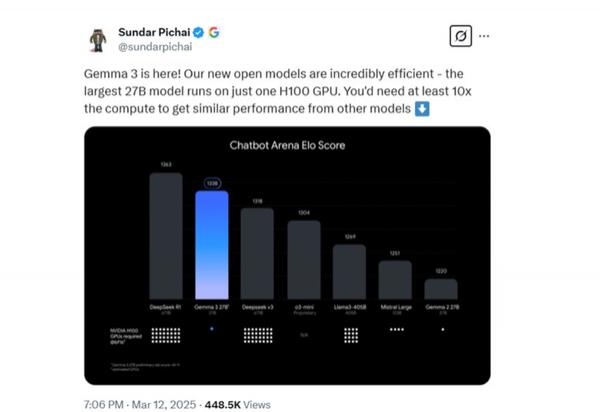

【CNMO 技术新闻:谷歌CEO日前 Sundar Pichai 宣布开源最新多模式大模式 Gemma-主要推广低成本和高性能。Gemma-3 提供四种不同参数的规模版本, 10 亿、40 亿、120 亿和 270 亿参数。即使是参数最多的 270 在1亿版本中,只需要一个 H100 高效推理可以通过显卡来实现。相比之下,如果同类模型想要达到类似的效果,至少需要改进。 10 倍算率。因此,Gemma-3 这是目前性能最强的小参数模型之一。

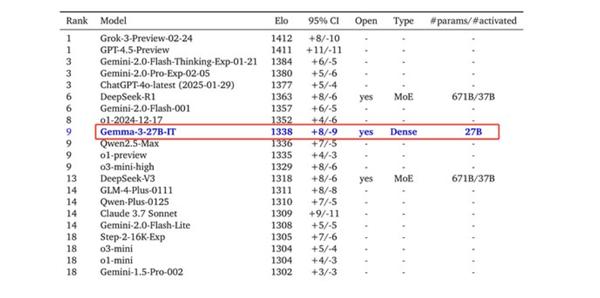

就功能测试而言, LMSYS ChatbotArena 盲测数据,Gemma-3 仅次于表现 DeepSeek 的 R1-671B,优于 OpenAI 的 o3-mini 和 3-405BLlama3- 等待知名模型。

就架构模式而言,Gemma-3 前两代通用解码器的延续 Transformer 结构,并进行了多项创新和优化。为了解决长前后文带来的内存占用问题,Gemma-3 采用局部和全局自注意层交错的结构: 5 插入一个局部层 1 全局层,局部层的跨度仅为 1024 个 token。由于只有全局层负责处理长前后文,局部层只关注。 1024 个 token 小跨度,从而有效减少内存占用。

多模态能力是 Gemma-3 技术亮点之一。该模型可同时处理文本和图像,并集成定制版本 SigLIP 视觉编码器。这个编码器是基于 Vision Transformer 架构,通过 CLIP 结合损失进行练习。

为了评定 Gemma-3 性能,谷歌在 MGSM、Global-MMLU-Lite、WMT24 、RULER、MRCR 等待多个主流平台进行测试。数据显示,Gemma-3 比如在多模态任务中表现出色, DocVQA、InfoVQA 和 TextVQA 在其他任务中,其性能明显优于上一代模型。就长文本处理而言,270 十亿参数版本 Gemma-3 在 128KRULER 这项任务已经完成 66.0% 的准确率。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com