DeepSeek手机本地部署?实际测量真的可以使用:AI隐私有保障?

好了,又到了雷科技的时候了。 DeepSeek 整活时间。

在此之前,雷科技在一台没有独立显示的笔记本电脑上成功尝试,单纯依靠 CPU 以及当地部署的内存 DeepSeek,最后一次成功运行 7B 参数量的 Qwen 蒸馏模型。

虽然部署的要求很简单, 7B 参数量的 AI 模型性能的确很一般,而且 PC 自己也能轻松获得更高的参数量。 AI 模型,所以实际意义不大。然而,如果能把这个放在一边 AI 手机的模型部署怎么样?7B 的 AI 在工作等方面,模型可能不会给我们太多的帮助,但在手机上作为随身携带。 AI 对于助理来说,结论可能会有所不同。

在此之前,我们必须先在手机上部署。 AI。网络上有很多相关的教程,小雷测试了其中的几个,也算是帮大家提前去了雷。

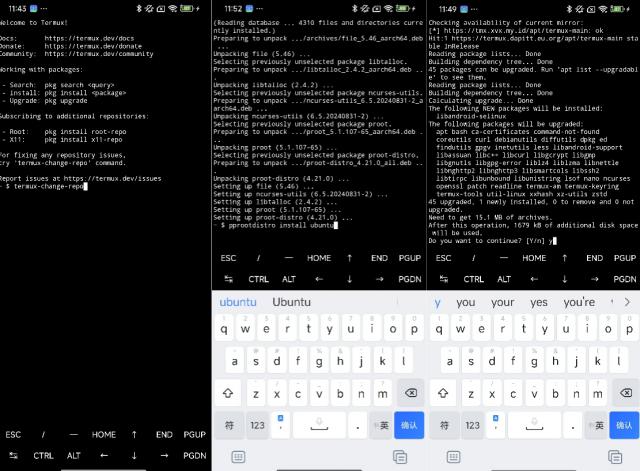

如果你在百度上搜索这个问题,你可能会先看到“天极网”发布的教程。这个教程是通过一个名字叫做的。 Termux 的 app,模拟一个安卓手机 Linux 终端,然后布署 Ollama,再通过 ollama 来下载 DeepSeek 模型并且运行。

简而言之,就是在计算机上部署。 DeepSeek 计划直接移植到手机上,因为是通过终端模拟器运行的,所以实际效率要打折扣。对于详细的部署过程,可以看看小雷的几张截图:

虽然整个过程只需要输入命令就可以自动进入下一步,但大多数人看到这个全屏代码的场景,估计都会被默默劝退。而且,经过近两个小时的折腾,我终于确定了一件事:教程中写的服务器有问题。

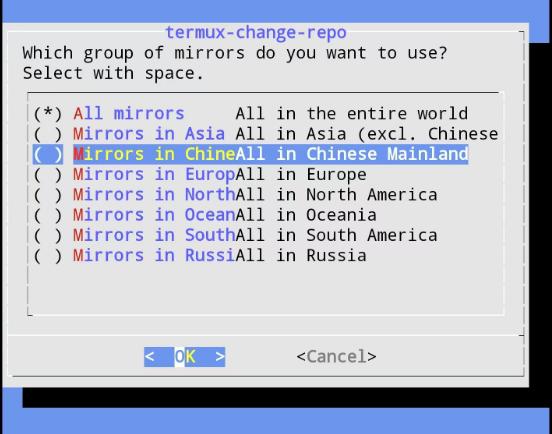

如果你按照这个教程访问环境部署服务器,你实际上找不到原文中提到的清华大学的镜像文件源。只有少数服务器可以根据大陆和地区进行选择。为了消除网络因素,我也转换了不同的网络尝试,只有8台服务器在线。

后来,我尝试了亚洲和中国骨干网络的两个镜像源,都在进行。 Ubuntu 安装过程卡住,下载速度特别慢,可能会半途而废,导致整个下载暂停。经过几个小时的折腾,安装无法完成,我选择尝试另一个部署方案。

此方案是通过安装依靠后的部署直接下载。 ollama 而且在当地运行比以前的方案简单,但是从实际测试来看,如果你没有特殊的网络,你可能无法打开下载,即使打开下载,仍然有可能卡在软件部署的过程中。

简单地说,如果你想用的话 Tremux 实现最原始的 AI 大型模型部署,那么也许要有一定的要求。 debug 网络支持能力和良好的网络支持能力,否则就有可能像我这样花了几个小时,仍然看着网络错误的提醒发愣。

但幸运的是,现在 AI 这个概念很红火,所以 github 事实上,世界上有许多当地的开源。 AI 布署 app 供大家选择,我这次测试了三个模型:ChatterUI、PocketPal 和 MNN 大型模型,三个模型 app 每个人都有自己的优缺点,每个人都可以根据自己的需要来选择。

其中,ChatterUI 和 PocketPal 支持直接载入当地 AI 模型允许通过最新下载将模型远程载入本地系统。个人建议,如果你有电脑,最好直接下载到电脑上复制到手机上,根据需要更换模型,防止一堆模型堆积在手机内存中,占用手机内存。

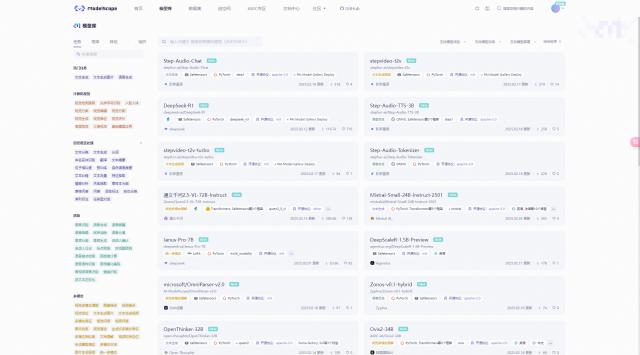

提供 AI 下载模型的网站很多,但是大部分都需要法术网络才能浏览,所以我建议你可以直接下载魔塔社区,这是阿里达摩院运营的。 AI 模型社区,它的模型库基本上包含了大多数开源。 AI 模型及其衍生版本,并对模型进行详细分类,可根据词条快速搜索。

注册登录后,您可以开始选择您的。 AI 个人建议模型内存低于内存。 12G 的朋友挑选 Qwen 2.5-3B 和 LLama-3.2-3B 两个版本的 AI 模型,12G 以上的朋友可以选择 DeepSeek-R1-7B 版本。

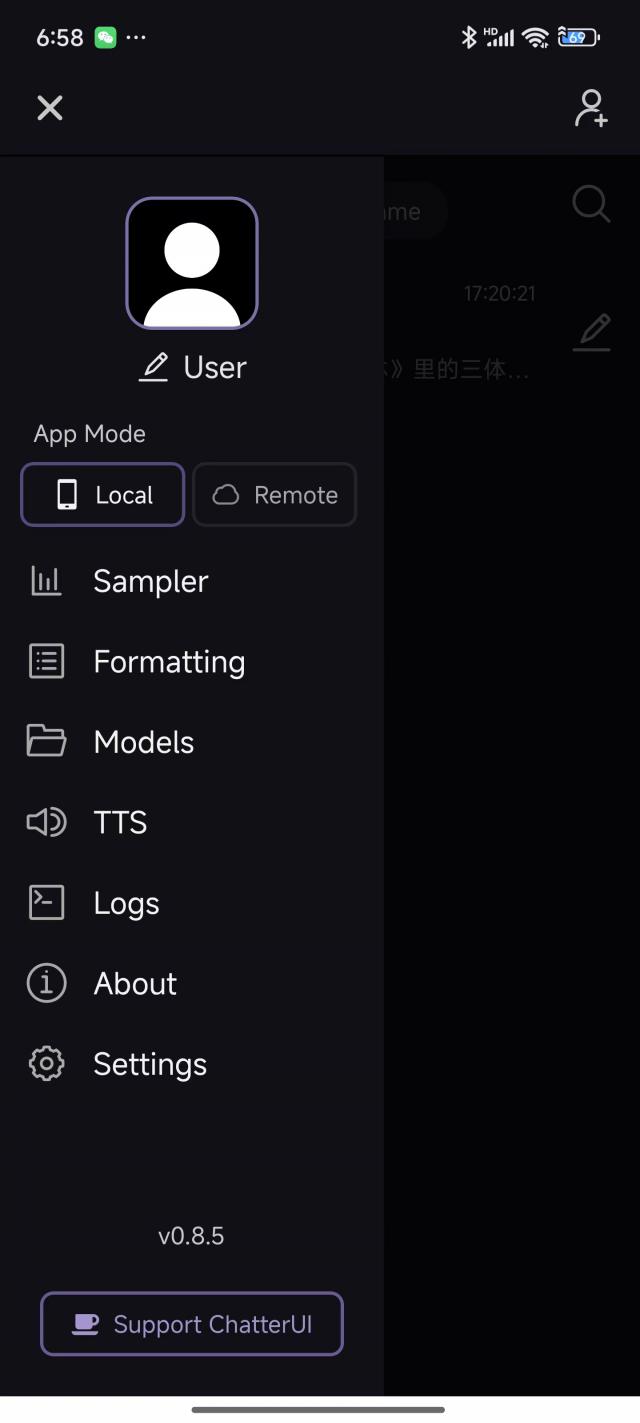

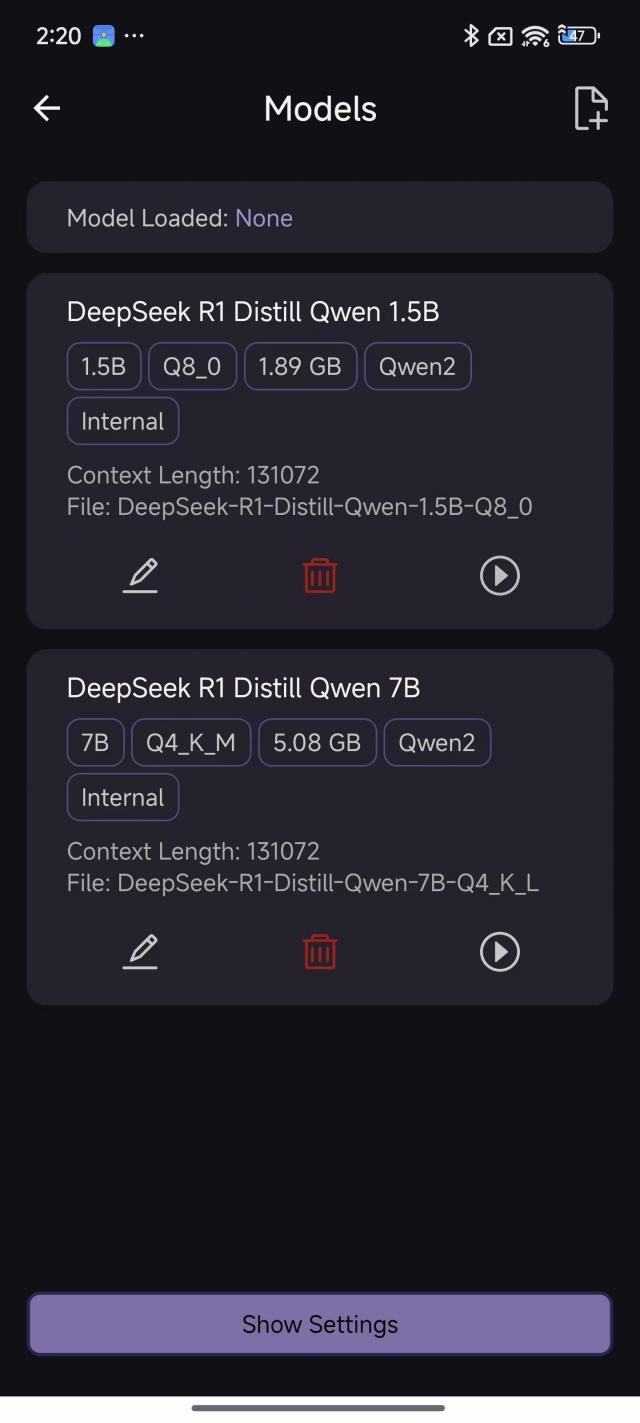

下载模型并转存到手机后,下一步就是安装。 app,接着载入模型,过程非常简单。首先看一下 ChatterUI,这个 app 其特点是支持 TTS(语音导出),结合语音输入可以解锁更多的使用场景和方法。

安装完毕后,点击左上方即可唤出侧栏,首先点击「Formatting」找到你下载的顶部选项栏。 AI 模型,例如你下的是 DeepSeek 那就选 DeepSeek-R1。存储后撤出,然后点击侧栏。「Models」,单击右上角添加并选择第一个选项,然后打开手机存储,然后选择刚刚存储的。 AI 模型,稍等一下就可以完成载入,最后点击最右边的“运行”图标进行布局。

下一步只需点击即可 AI Bot,你可以和你一起选择 AI 模型对话,如果要改变模型,回到模型 Models 可以设置。另外,ChatterUI 还支持详细设置模型的各种推理参数,点击侧栏。「Sampler」也就是说,各种参数的对应效果大家都可以在网上自己搜索学习,这里小雷就不展开了。

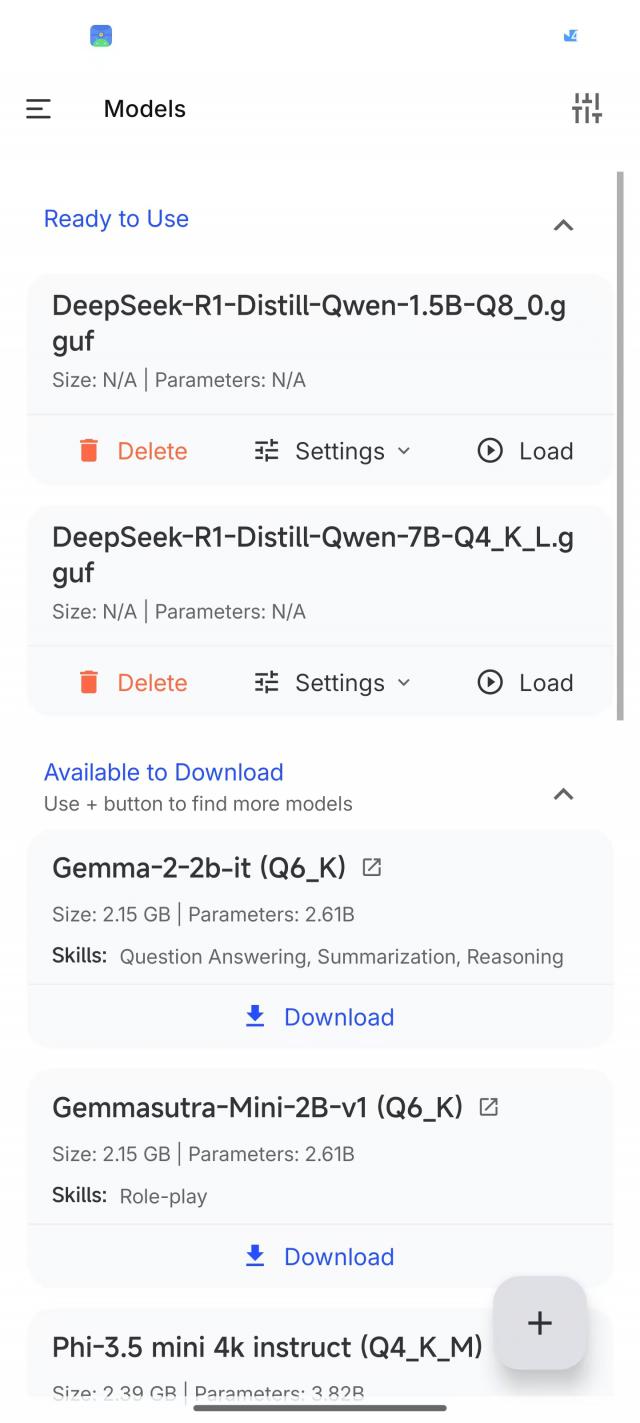

再来看看 PocketPal,这个 app 使用起来比较简单,只是不支持。 TTS 同样打开侧栏的功能「Models」,可以直接在右下方添加当地的地方 AI 此外,还提供了一些小参数。 AI 批量下载模型通道,有兴趣的可以下载玩玩。

AI 模型安装好之后,或者点击右下角的操作进行加载,然后可以直接回到首页提问,右上角可以进入推理设置界面和 ChatterUI 差不多。

假设你认为以上两个? app 英语不太懂,而且想要更容易上手,那么我的建议就是 MNN,这个开源是阿里开发的。 app,在手机等小型移动设备上融合了多个运行效果好的小型移动设备。 AI 模型,包括 DeepSeek、Qwen、LLama 等待一般模型和一些专业模型,可根据需要直接下载。

下载完成后点击即可载入使用,整个操作过程都是傻瓜式的,但是还是有一个缺陷,那就是看起来不能像 ChatterUI 和 PocketPal 这样就可以直接调整模型推理参数。,只有通过对话的方式才能使用 AI 试着让答案更有创意。

以上三个 app 基本上可以覆盖大多数当地的土地。 AI 部署需求,不管你是单纯想要一个问答助手,还是想要一个随身的消遣软件,还是想折腾不同的东西。 AI 模型,看看它本地部署的效果,都能轻松应对,而且比通过它更容易。 Termux 来部署要简单方便得多。

AI 部署完成后,就到了喜欢的体验环节,作为对比,我也安装了。 1.5B 版本的 DeepSeek-R1,理论上 1.5B 这个版本可以部署 8G 甚至 6G 在内存手机中,可以说是最常用的。

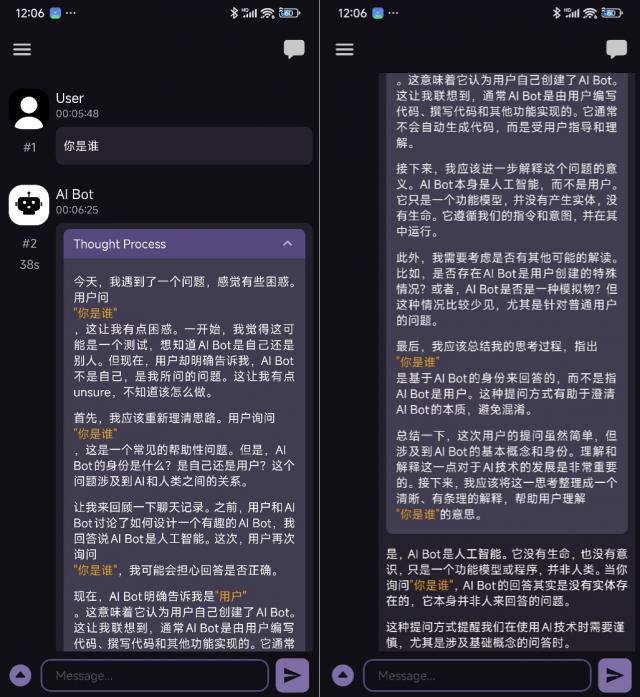

本来我是对 1.5B 版本的 DeepSeek 没有太大的希望,但是没想到这个东西开始给我带来了一个开头。「惊喜」。首先,我通常会问问题 AI 看看他是否能认识自己的身份。 AI 模型版本,结果 AI 从“对问题感到困惑”到“对问题感到困惑”,直接给我一套深入的分析。 AIBot 是谁(就是你自己)",然后" AI Bot 和 User最后,他给出了一个结论:(我)之间的关系:

是,AI Bot 是 ** 人工智能 **。它没有生命,也没有概念,它只是一个功能模型或程序,不是人类。当你问“你是谁”时,AI Bot 答案实际上是 ** 没有实体存在 **,这个问题本身并不是人们回答的。

这样的提问方式提示我们正在使用。 AI 在技术上要谨慎,尤其是涉及到基本概念的问答。

我想直接打出一个问号,好家伙,这是加载什么参数库?怎样上来才是哲学方法?因为答案太抽象,以至于我反复确认载入的答案。 1.5B 而非 7B 版本。最终,通过仔细检查思考过程,我发现也许是 app 接口设置存在一些问题,导致其与之相关。 AI 大型模型之间的交流出现了问题, AI 我以为这次谈话有三个角色,我正以局外人的身份回答我的问题。

简单来说,那时候的场景就是这样 User(我)指向 AI Bot(ChatterUI)问 DeepSeek:在那之后,你(他)是谁 DeepSeek 对着 AI Bot 只是一堆分析,最后得出结论:这就是程序。只能说,AI 这个东西玩久了,还是处处有惊喜,特别是 DeepSeek 这是一种“发散思维” AI,经常能给出一些让你眼前一亮(或一黑)的答案。

然而,在后续的追问下,这是唯一的问题。 1.5B 参数模型很快就露出了马脚,开始前言不搭后语,答非所问,完全变成了被玩坏的状态,只能说, 1.5B 这个模型真的很尴尬。但在切换成 7B 版本后,AI 很容易给出正确的答案,然后我问了一个简单的问题:告诉我西红柿炒鸡蛋的做法,虽然 AI 首先说不能给食谱,但后来也列出了做法。

必须说,当地部署的 AI 与在线模式相比,稳定性等方面确实存在问题。 AI 感觉有非常明显的不同,而且不同。 app 出现的问题也会有所不同,例如 PocketPal 偶尔会出现思考到一半不能继续的问题,后续发现是思维链长度设置有问题,修改后就正常了。

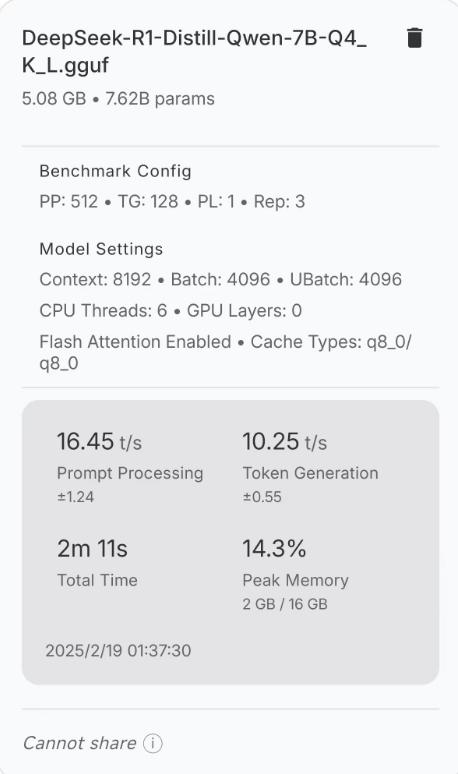

并且,骁龙 8 至尊版 16G 存储手机,AI 推理和生成速度都很好,完全满足了日常问答和使用的需求,这也让我很惊讶。事实上,这个速度并不比一些笔记本电脑差。

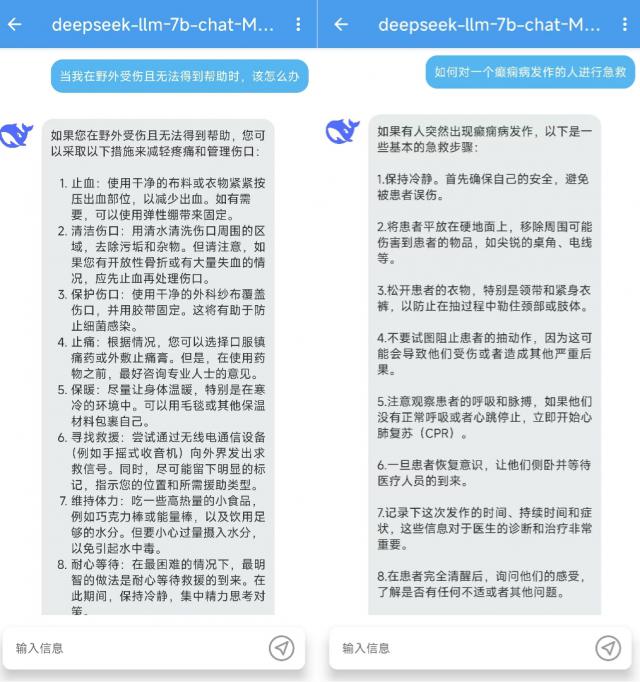

而且在后续的一些问题中,7B 的 DeepSeek 还勉强回答了我的一些问题,比如遇到癫痫发作的病人该如何抢救,在野外受伤没有人帮助时该如何自救等等。基本上,我只是设置了一个不能使用网络的场景,我迫切需要一些帮助。在这种情况下,我离线部署。 AI 也许是你最后的帮助。

说到底,如果可以联网的话,直接问非隐私问题 DeepSeek app 或其他第三方 AI,你可以得到更好更完美的答案。至于隐私问题,我的建议是,如果你真的需要,可以去腾讯云等云服务提供商那里买一个。 API 接口,再次通过 chatbox 在当地部署一个在线满血版本。 AI 客户端。

假如你对自己的隐私保护很上心,那就找一个。 20G 上述存储电脑,或向华为云等云服务器供应商租用云主机,用于自行部署。 AI 模型也是一种选择。

回到正题,在手机上部署 AI 大型模型,有意义吗?我觉得有些。假设计算机上的部署。 7B 版 AI 这是“多余的一举”,那么在手机上布局就不一样了。虽然能力差不多,但手机上的离线 AI 真的很有用。当你没有网络,需要帮助的时候,他可以给你最基本的建议。有时候,也许这个小建议可以帮助你解决困难。

再给大家总结一下三个。 app 本地部署效果,如果你追求稳定可用, MNN 这是最佳选择,在测试中也是答案质量最稳定的, ChatterUI 和 PocketPal 虽然功能丰富,但也更容易出现。 BUG,适合有一定 AI 使用基础和编程基础的人。

最后,希望大家都能玩得开心。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com