六晨尤洋:GPT-4时刻的视频生成,3年后可见证。

奥特曼说,Sora 它代表了视频生成的大模型 GPT-1 时刻。

从年初到现在,从国内外,从创业独角兽到互联网厂商,都投身于视频生成领域,带来了新的模式。与此同时,视频和影视行业也发生了巨大的变化。

不可否认,目前的视频生成模型还存在很多问题,比如对空间和物理规律的认知,大家都在期待视频生成。 GPT-3.5/4 时刻来临。

国内有这样一家从加快培训开始的创业公司,正在努力工作。

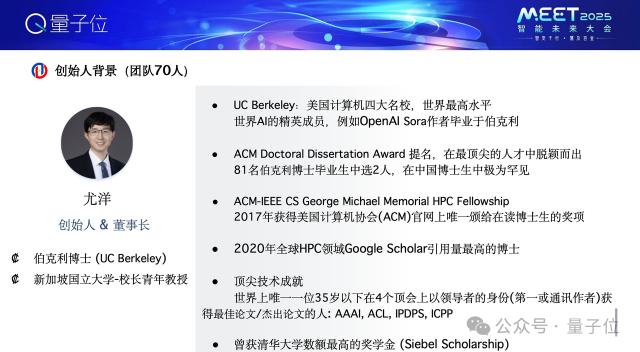

创始人尤洋博士毕业于六晨科技。 UC 后来到新加坡国立大学担任校长青年教授伯克利。

除了加速计算,今年六晨科技还开发了视频生成模型。 VideoOcean,为行业带来更具性价比的选择。

在 MEET 2025 现场,尤洋博士还与我们分享了今年对视频生成领域的理解和认识。

MEET 2025 智能化未来大会是由量子位举办的行业峰会,20 剩下的行业代表参加了会议。线下观众 1000 ,在线观众直播 320 万 ,得到了主流媒体的高度关注和报道。

整理核心观点

视频生成模型应实现文本控制的精细化,随机位置 / 任意角度,角色一致,定制风格

3 也许年后就可以迎来视频生成了。 GPT-3.5/GPT-4 时刻

大模型视频生成的直接实用价值之一就是突破现实的限制,大大降低真实场景再现的难度。

(为了更好地表达尤洋的观点,量子位在不影响初衷的基础上做了如下整理)

3 或者视频大模型之后 GPT-3.5 时刻

今日特别高兴来到量子位大会,特别高兴与大家交流,今日就来谈谈我们在视频大模型领域所做的一些工作。

第一,介绍我和我的创业企业六晨科技。 UC 毕业于新加坡国立大学的伯克利教练,很荣幸成立了六晨科技。

以前我们做过算率优化。2018 年度谷歌创造了世界上第一个千卡集群。 TPU Pod,那时世界上最大的模型仍然是 BERT。我们协助谷歌将(当时)世界上最大的模型训练时间从 3 天压缩到 76 分钟。

同样令人荣幸的是,去年华为盘古大模型的一项工作也是我们一起做的,并且得到了。 ACL 最佳论文。我们的技术帮助华为盘古模型在训练中更有效率。微软、英伟达等公司团队也使用我们的技术进行一些分布式训练,希望大模型训练更快,成本更低。

进入今天的话题,重点介绍视频生成的大模型。

我们创造了一种叫做商品的商品Video Ocean,现在正处于测试阶段。首先要介绍商品,然后再讨论我认为视频大模型将如何发展。

第一,我认为视频大模型的第一个重要方面是,它应该能够实现精细化的文本控制。

事实上,我们今天都在使用它 AI 要生成一个大模型,我们一定希望它能准确地反映我们想要的东西。但是很遗憾,比如现在用文生图。 APP 在生成图片的时候,仍然会发现许多图片内容无法实现精确的控制,因此我认为这方面还有很大的发展空间。

在 Video Ocean 在模型训练过程中,我们做了一些初步的探索。一个更好的例子,我们可以准确地提供一些欧洲男人的描述,他们戴着墨镜,长着胡茬。不言而喻,这个视频真的是我们想要的感觉。蓝天、海岸、海滩、背光、单手相机和黑色 T t恤,还有面对镜头的演讲。

我觉得 AI 未来视频大模型 3 也许每年最重要的还是实现视频大模型 Scaling Law。

这个过程不需要很酷的产品能力,最重要的是把它的模型和现实世界的连接能力做到极致。我觉得最终的形式是人们说一段话,给一个描述,可以通过视频准确呈现描述。

因此,我认为未来 3 年,AI 视频模型就像山姆一样 · 奥特曼说,今天是这样, Video 的 GPT-1 时刻,可能 3 年后到达视频大模型 GPT-3.5、GPT-4 时刻。

在这里展示一下 Video Ocean 的 Demo,现在我们已经达到了这个水平。

其次,未来视频大模型如何实现任意机位、任意角度。

现在拍电影、拍纪录片都能拿着手机、相机不停地晃动,想怎么晃就怎么晃,这样才能真正控制镜头。将来 AI 视频模型,首先要做到这一点,同样的描述,换个角度,换个镜头,它的形象不应该改变,它就是同一个物体。

进一步说,将来 AI 视频大模类型也可以颠覆各行各业。例如现在看足球,看篮球比赛,我们看到的镜头就是现场编导给我们看的画面。他向我们展示了远景,特写。

将来是否可以依靠 AI 视频模型,人们控制镜头,决定自己想看哪里,相当于在体育场瞬间移动,移动到教练席、最后一排、第一排。随机位置和任何角度的控制。我认为未来 AI 在这方面,视频大模型也很重要,当然当然, Video Ocean 现在做了一些尝试,初步的效果还是不错的。

人物一致性是我认为的第三点。

由于作出 AI 视频模型最终必须产生收入并实现实现。谁会愿意为此付费,比如广告工作室、广告主、电商博主、影视行业。如果你深入这些行业,一个关键点就是角色一致性。

举例来说,一个产品的广告,一定是从头到尾这段视频中的衣服、鞋子、汽车,外观不能有太大的变化,物体角色保持一致。

拍一部电影,从开头到结尾,主演的样子,关键配角的样子肯定是无法改变的,在这方面, Video Ocean 还要做一些好的探索。

另外一个是风格的定制。现在我们知道演员的人工成本很高,道具成本也很高。

将来 3 一年之内,如果 AI 视频模型正常发展,我觉得会有一个需求。比如一个导演可以让一个演员在游泳池里拍一部戏,然后通过素材获得。 AI 将其转化为泰坦尼克场景中的游水,转化为阿凡达场景中的游水,这种能力反而是 AI 最好的。给人电影感,艺术感的画面。

总而言之,大模型是一个直接应用程序。价值就是突破现实的限制,可以大大降低真实场景再现的难度。

也许你之前听过一个笑话。好莱坞导演想制造一个爆炸性的场景。他计算了一下预算。第一个方案是建一座城堡炸掉它。第二个方案是用计算机模拟这张图片。计算成本后发现这两个方案的成本都很高,当时用计算机模拟的成本更高。现在, AI 就是要大大降低大模型生成电影的成本。

假如这个实现之后,不受场所、天气等外部因素的限制,我们可以,减少对真正演员的依赖。这不是抢演员的工作,因为有些关键场景很危险,比如演员跳飞机跳楼,演员救爆炸弹。这种场景只需要未来演员的身份和肖像权。AI 能把这种镜头做好,所以对于电影行业来说,可以大大降低成本。

正如昆仑万维方汉先生刚才所说,尽管我们的计算资源有限,但是我们发现,通过更好的算法优化,可以培养出更好的效果,比如 Meta 使用 6000 多个 GPU 训练 30B 模型,最近我们会在一个月内发送一个 10B 我们只使用了版本模型。 256 卡。

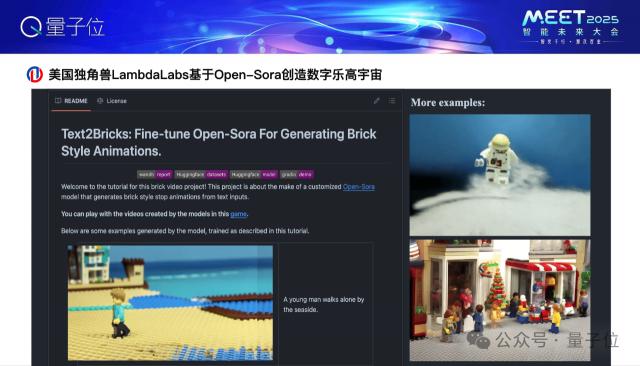

Video Ocean 前身首先为我们的团队打造了一个Open-Sora开源产品,这种开源产品是完全免费的, Github 世界上,效果很好,比如美国独角兽 Lambda labs 数字乐高已经成为一种流行的应用,事实上,这种数字乐高是基于数字乐高。 Open-Sora 做的。

今年初 Sora 出来之后,各种短视频巨头都比较重视视频模型这一块,比如中国的快手、抖音、美国就是这一块, Instagram、TikTok、SnapChat,这能够看见 SnapChat 早些时候还发布了视频模型,叫做 Snap Video,它的官方论文就是这样,他们就引用了我们训练视频大模型的技术,所以说这些技术也有助于一些巨头真正把视频大模型训练得更快、更精确、更智能。

谢谢大家!

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com