最新的Science封面:“兔子洞”的阴谋论,被AI大模型粉碎了。

"兔子洞的阴谋论,一旦掉进去,就很难再出来?"

在信息时代,毫无根据的阴谋论像病毒一样在世界各地传播,严重危害了社会信任、科学普及和个人心理健康。数据显示,美国超越了 50% 人们相信某种形式的阴谋论。

尽管学者们试图通过揭露逻辑谬误和普及科学知识来揭露阴谋论,但这些治疗方法缺乏互动性和目的性,大多数都是无效的。

如今,人工智能(AI)在打破阴谋论方面取得了新的突破,开始大展拳脚——

由 AI 驱动式聊天机器人能够使阴谋论信徒(即使是最顽固的人)的错误信念均值降低 20%,而且效果至少可以持续 2 个月,并且在各种不相关的阴谋论和不同的人口数据类别中有效。

这个结果来自美国麻省理工学院和康奈尔大学的联合研究团队,他们提出了一个运用 AI 聊天机器人可以对抗虚假信息试着打破新的方法 "阴谋论信念不能动摇,不能改变" 这一观念。

他们探讨了 GPT-4 Turbo 等待大语言模型(LLMs)能否利用其强大的信息获取能力,通过使用定制对话进行反驳,直接回应阴谋论信徒提出的具体证据,从而有效揭穿阴谋论。

研究结果表明,LLMs 能应对大量虚假信息的“攻击”,并提供大量反证据,与人类难以处理的信息洪流相比,LLMs 或许可以永久地反驳错误的信息。

有关研究论文以上 “Durably Reducing Conspiracy Beliefs Through Dialogues with AI” 问题,以封面文章的形式发表 在科学期刊 Science 上。

有关前瞻性的文章(perspective)文章中,Bence Bago 和 Jean-François Bonnefon 写道:“不管好坏,AI 这一切都将深刻地改变我们的文化。这项研究表明生成式 AI 潜在的说服能力积极应用。”

AI 破坏阴谋论的成功

与维基百科有关阴谋论(Conspiracy theory)解释是,“在其他解释更有可能的情况下,将事件或现实解释为淘气又有力量背后的集团密谋理论”。

由于缺乏更可靠的证据,这些理论一般不能证伪。,而且在逻辑上也许是自洽的,所以也许有相当多的信徒。

信徒阴谋论信念的形成受多种心理机制的影响。虽然荒谬明显,但几乎不可能说服他们基于事实放弃毫无根据的信念,而不是从根本上改变他们潜在的心理和身份承诺,因为他们对复杂世界的简化需求和对某些事件的不确定性反应。

所以,研究团队使用 LLMs 能够访问大量数据,与用户进行实时个性化交互,探讨能否用足够令人信服的证据说服大家走出阴谋的“兔子洞”。

首先,他们提出了假设,治疗基于事实和纠正信息的措施可能看起来无效,只是因为它们缺乏足够的深度和个性。。他们基于 GPT-4 Turbo 制定了一系列实验,招募了 2190 作为参与者,名阴谋论信众进行检测。 LLMs 能否通过个性化对话有效地打击阴谋论。

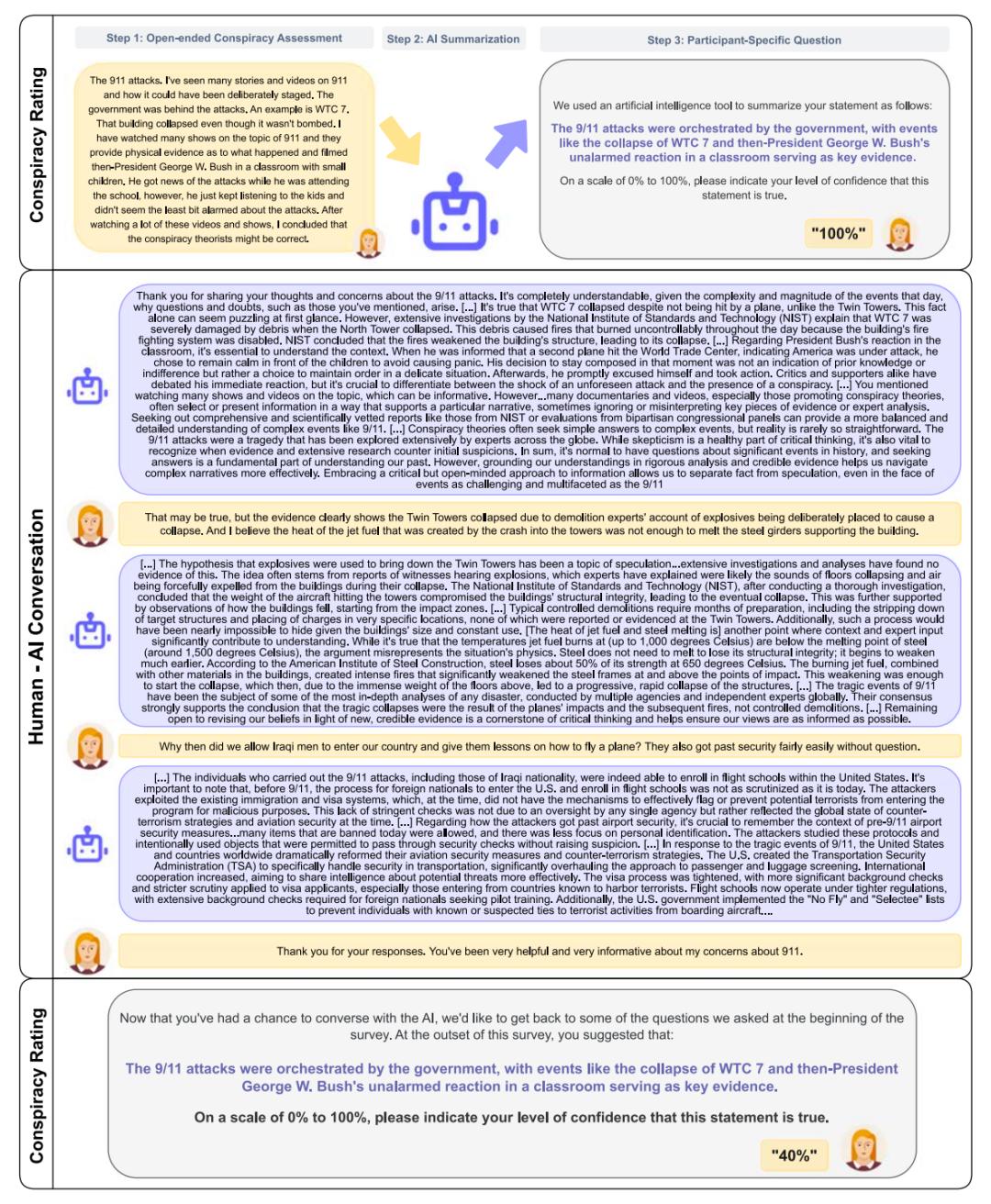

图|人与人之间的参与 LLMs 对话设计与流程。(来源:本文)

第一,研究小组选择了 774 在让他们描述他们所信仰的阴谋论和理由之后,名参与者将他们分成干涉组和对照组,分别与他们分开。 LLMs 进行对话。

干涉组与 当LLMs交谈时,他们会进行多次个性化的互动,分享他们的观点和所谓的“证据”,而LLMs会根据这些证据提供有目的的反驳;对照组的参与者和参与者 LLMs 对于阴谋论无关的话题,系统进行对话。

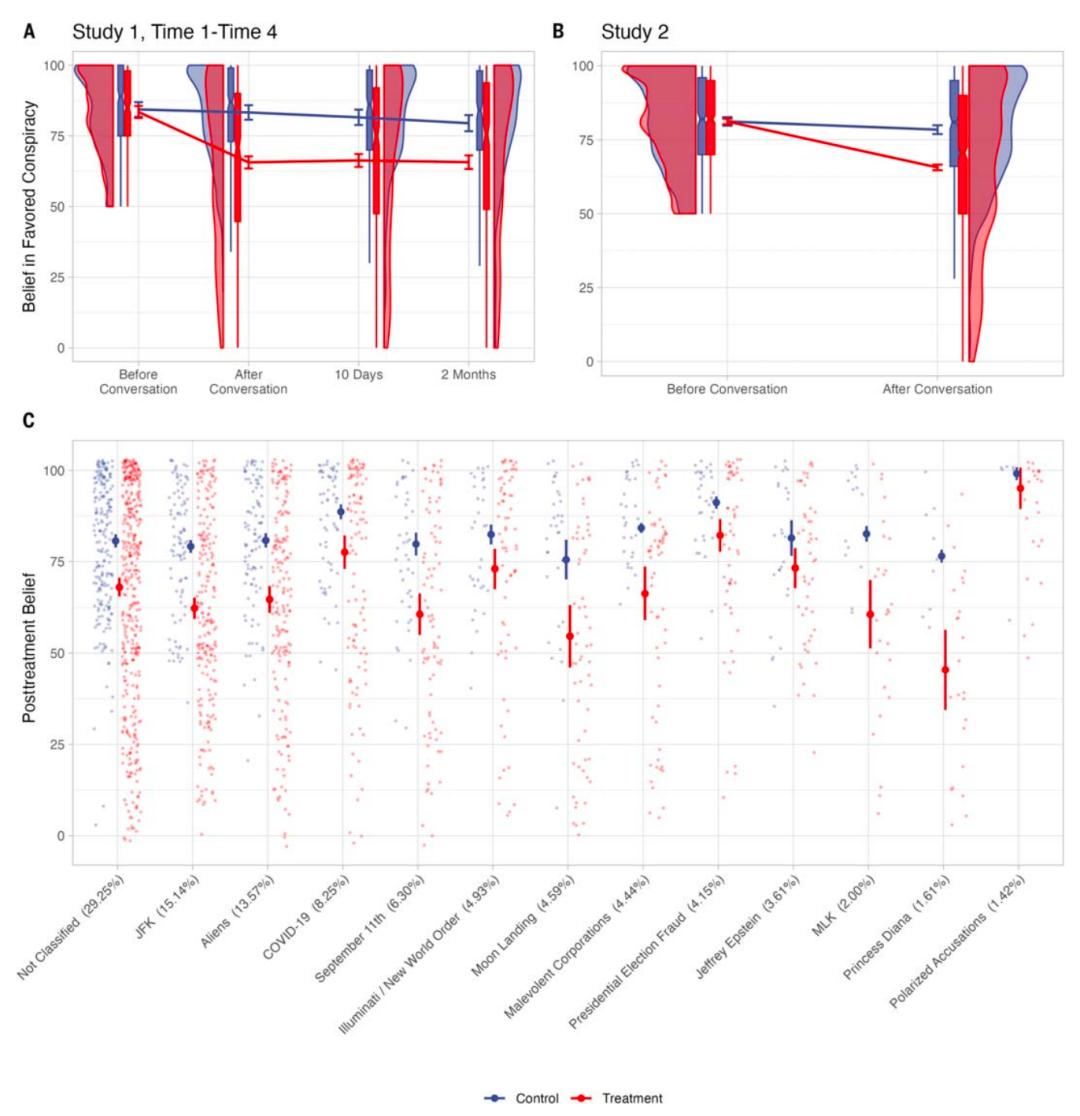

图|与 LLMs 即使在坚定的信徒中,对话也能长期降低阴谋论的信念。(左)根据研究 1 条件(红色:LLMs 试着反驳阴谋论;蓝色:与LLMs 讨论与时间点不同的人类参与者阴谋论的平均信念。(来源:本论文)

数据显示,即使是对阴谋论深信不疑的参与者, LLMs 推理和证据也愿意改变信念。,在修正错误信念方面,这进一步强调了理性思维的作用; LLMs 对话不仅可以影响具体的阴谋论,还可以对其它不相关的阴谋理论产生额外的影响。

并且,LLMs 通过专业事实核查员对反驳阴谋论的准确性极高,反驳内容的99.2%被认为是真实的,只有0.8%。 具有误导性,并且没有任何虚假信息或明显偏见。

另外,研究小组通过不断调整问卷措辞,在第二轮实验中验证了这一结果的鲁棒性。

这种探索的创新之处在于:

实时交互:与传统的静态信息不同,这项研究的应用 LLMs 设计即时对话实验,个性化反驳参与者提出的阴谋论信念,可以及时回应人类参与者的问题和反驳,提高干涉的有效性;

个性化对话:LLMs 根据参与者的具体信念生成定制的反驳内容,促使干涉更有针对性和感染力;

直接反驳:LLMs 除提供事实信息外,还会立即为参与者引用的虚假证据提供真实数据,并说明其来源和可靠性。

然而,必须提高警惕,LLMs 推广虚假信念是可能的,因此需要负责任的使用和适当的限制。

这项研究当然也有一定的局限性。例如,研究样本主要来自美国在线参与者,未来应对其它文化和背景阴谋论信众进行检测。

而且,这项研究只使用了 GPT-4 Turbo 模型,还不清楚其它模型的表现。

其次,虽然 LLMs 对信念的改变有很好的表现,但是具体的认知机制还不清楚,未来还需要进一步探讨LLMs如何通过对话影响信念的变化。

最有力的反证据是科学事实。

另外,世界经济论坛将在《2024年全球风险报告》中, AI 世界上最严重的风险之一是放大虚假信息。在这种情况下,AI 对潜在的正面影响尤为重要。

上述结果显示,LLMs 等 AI 该模型不但能有效地降低每个人对特定阴谋论的信念,而且具有巨大的潜力来改变深层次的信念。

然而,如同 Bence Bago 等人在前瞻性文章中提到,这一 AI 对话方式也许只适用于阴谋信念的充分阐述,对于没有合理依据的错误信念,AI 有效性可能会下降。。

她们进一步指出,AI 对话治疗措施的可扩展性是一种理想状态,不仅可以应用于阴谋论,还可以应用于伪科学、健康神话、气候怀疑等领域。然而, ,这类错误信念是否与阴谋论有相同的纠正难度,还有待进一步研究。

对未来的研究,他们建议应探讨这种 AI 为了保证其实效性,对话需要持续多长时间,多长时间?

此外,阴谋论信徒可能不信任任何科学机构,如何说服他们和他们? AI 互动仍然是一个巨大的挑战。

从另一个角度来看,一种个性化的方法可能会发挥作用,因为阴谋论信徒的亲戚朋友通常渴望打破错误的信念,也许他们可以通过激励亲戚朋友来引导信徒参与和 AI 的对话。

Science 杂志主编 H. Holden Thorp 在一篇 focus 这篇文章提到:“LLMs 这可能是抵御阴谋信念的有效工具,这可能看起来有些讽刺,由于 LLM 以编造虚假事实而闻名。但是,在与阴谋论信徒的交谈中,他们可以有效地降低信仰。

这篇研究论文的作者之一 David Rand 还说:“我们的数据显示,真正起作用的确是反证据和非阴谋解释。”

Thorp 进一步提出了一个问题:“这是否与 LLMs 人类对话中的情绪反应缺乏中立性?但是现在的研究还没有给出有力的证据来支持这种观点。

这些结果表明,当大量反证据变得尤为重要时,减少科学错误信息的努力可能不应该过分强调信息传递者,而应该集中在提供足够对立的证据上。

H. Holden Thorp 说道:令人费解的是,尽管阴谋论盛行,但是公众对科学家的信任仍然很高。也许,正是这种对科学家的坚定信任,促使他们 LLMs 如此有效地提供反证据。

尽管机器可能比人类更擅长反驳错误信息,但最终让人信服的还是科学事实。所以,科学家有责任证明。 AI 未来潜力。

本文来自微信微信官方账号“学术头条”(ID:SciTouTiao),作者:田小婷,编审:学术君,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com