用谷歌TPU训练AI的苹果,都怪英伟达太贵?

这两天,Apple Intelligence 上线已经成为最大的科技新闻之一。

虽然相比 1 一个多月前公布的完整版本 Apple Intelligence,苹果 iOS 18.1 beta 1 中引入的 Apple Intelligence 功能不全,Image Playground、Genmoji、具有屏幕感知功能的优先通知 Siri 和 ChatGPT 整合...所有这些都还没有。

但是总的来说,苹果还是带来了。 Writing Tools(写作工具)、电话录音(包括转录)和新设计的 Siri。

其中,Writing Tools 支持重写、系统化、简单化等功能,可用于聊天、发朋友圈、小红书笔记、文字写作等场景;电话录音不仅可以记录通话,还可以自动转录成文字,方便用户复习。

此外,Siri 也获得了「升级」,遗憾的是,目前仅限于设计,包括全新的设计。「跑马灯」特殊效果和键盘输入支持。

但是引人注目的是,苹果在一篇名为《《Apple Intelligence Foundation Language Models》在论文中披露,苹果并没有使用常见的英伟达 H100 等 GPU,而是选了「老对手」谷歌的 TPU,训练 Apple Intelligence 基本模型。

图/苹果

用谷歌 TPU,炼成 Apple Intelligence

众所周知,Apple Intelligence 共分为三层:一层是苹果设备本地运行的端侧。 AI,一层是基于「私有云计算」在苹果自有数据中心的云中运行技术 AI。根据供应链的消息,苹果将大量制造。 M2 Ultra 建立自己的数据中心。

另外还有一层,就是接入第三方云的大模型,比如 GPT-4o 等。

然而,这就是推理。苹果是如何训练自己的? AI 模型,一直是业界关注的焦点之一。根据苹果的官方论文,苹果是 TPUv4 和 TPUv5p 集群硬件训练了两个基本模型:

一是达到参数规模 3 设备端模型亿元 AFM-on-device,使用 2048 块 TPU v5p 经过训练,当地运行在苹果设备上;一种是参数较大的服务器端模型 AFM-server,使用 8192 块 TPU v4 芯片训练,最终在苹果自己的数据中心运行。

图/苹果

这个很奇怪,毕竟我们都知道,英伟达 H100 等 GPU 现在正在进行训练 AI 主流选择,甚至可能有「AI 训练仅用 Nvidia GPU」的说法。

相反,谷歌 TPU 就显得有些「没名气」。

但是事实上,谷歌 TPU 它是一种专门为机器学习和深度学习任务设计的加速器,可以提供卓越的性能优势。谷歌凭借其高效的计算能力和低延迟的网络连接 TPU 经过大型模型训练任务的处理,表现出色。

比如,TPU v4 可以提供高达每一个芯片 275 TFLOPS 峰值算率,并通过快速互联将会 4096 个 TPUv4 芯片组合成一个大规模的芯片 TPU 超级计算,从而实现算率规模的倍增。

而且不只是苹果,其它大型企业也采用了谷歌。 TPU 来训练他们的大模型。Anthropic 企业的 Claude 这是一个典型的例子。

聊天机器人试炼场排名,图/LMSYS

Claude 现在算得上是 OpenAI GPT 最具竞争力的模型, LMSYS 聊天机器人竞技场,Claude 3.5 Sonnet 与 GPT-4o 始终是「卧龙凤雏」(褒义)。而据披露,Anthropic 英伟达一直没有购买 GPU 为了建造超算,就是使用超算。 Google Cloud 上 TPU 集体练习和推理。

去年底,Anthropic 而且官方宣布率先使用 Google Cloud 上的 TPU v5e 集群来训练 Claude。

Anthropic 长期使用,以及 Claude 所有的效果,都充分展示了谷歌 TPU 在 AI 高效可靠的训练。

另外,谷歌的 Gemini 而且完全依赖于自主研究。 TPU 练习芯片。Gemini 该模型旨在促进自然语言理解和生成技术的前沿,其训练过程需要处理大量的文本数据,并进行复杂的模型计算。

而 TPU 强大的计算能力和高效的分布式训练架构,促进了 Gemini 训练可在相对较短的时间内完成,并在性能上取得显著突破 。

但如果说 Gemini 还可以理解,那从 Anthropic 为什么要选择谷歌来苹果? TPU,而非英伟达 GPU?

TPU 和 GPU,与谷歌英伟达的暗战

计算机图形学顶级会议于本周一举行。 SIGGRAPH 2024 上,英伟达创始人兼 CEO 黄仁勋透露,本周英伟达将发送。 Blackwell 结构样品,这是英伟达的最新一代。 GPU 架构。

2024 年 3 月 18 日,英伟达 GTC 最新一代在大会上发布。 GPU 架构——Blackwell,还有最新一代 B200 GPU。B200就性能而言 GPU 在 FP8 及新的 FP6 上可以达到 20 petaflops(每秒千万亿个浮点计算)的计算率,进而处理复杂性 AI 在模型中表现出色。

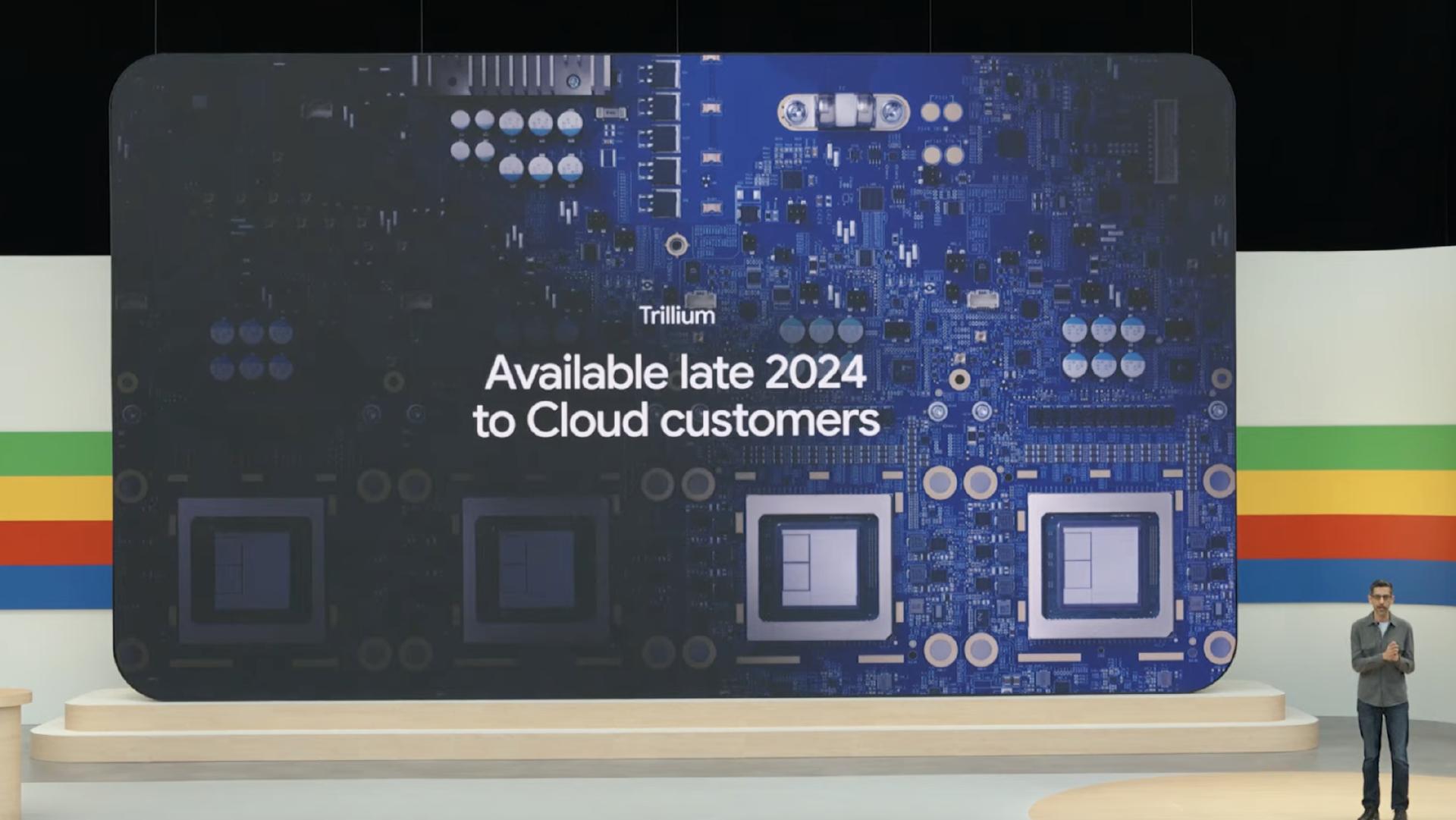

Blackwell 经过两个月的发布,谷歌还发布了第六代。 TPU(Trillium TPU),每块芯片在 BF16 下面可以提供接近 1000 TFLOPS谷歌还将其评价为峰值算率(每秒万亿次)「到目前为止,性能最高,节能最多。 TPU」。

图/谷歌

对比谷歌的 Trillium TPU,英伟达 Blackwell GPU 高带宽内存(HBM3)和 CUDA 在生态系统的支持下,在高性能计算方面仍有一定的优势。Blackwell可以在单个系统中并行连接。 576 个 GPU,实现强大的计算能力和灵活的扩展。

相比之下,谷歌 Trillium TPU 在大规模分布式训练中,重视高效率和低延迟。TPU 该设计可以使其在大规模模型训练中保持高效率,并通过快速的网络连接来减少通信延迟,从而提高整体计算效率。

而不只是在最新一代。 AI 芯片上,在谷歌和英伟达之间「暗战」事实上已经存在了 8 年,从 2016 年谷歌自研 AI 芯片 TPU 便开始。

到目前为止,英伟达 H100 GPU 在当前主流市场中,它是最受欢迎的 AI 芯片,不仅提供高达的芯片 80GB 高带宽内存,也支持 HBM3 内存,并且通过 NVLink 互连实现多 GPU 高效率通信。基于 Tensor Core 技术,H100 GPU 对深度学习和推理任务具有较高的计算效率。

但是同时,TPUv5e 具有明显的性价比优势,非常适合中小型模型训练。TPUv5e 其优点在于其强大的分布式计算能力和优化能耗比,从而在处理大规模数据方面表现良好。另外,TPUv5e 同时也是通过谷歌云平台提供的,方便用户进行灵活的云练习和布局。

图/谷歌数据中心

总的来说,英伟达和谷歌 AI 芯片策略各有侧重:英伟达通过提供强大的计算能力和普遍的开发者支持,推动其发展 AI 模型性能极限;谷歌通过高效的分布式计算架构,大规模改进 AI 模型训练的效率。这两种不同的路径选择,促使他们在各自的应用范围内展现出独特的优势。

但更重要的是,能够击败英伟达的,也只能选择软硬件协同设计策略,同时拥有强大的芯片能力和软件能力。

谷歌就是这样一个对手。

最强挑战者英伟达霸权

Blackwell 是继 Hopper 英伟达未来的又一重大升级,具有强大的计算能力,专为大型语言模型而设计。(LLM)和生成式 AI 而设计。

据介绍,B200 GPU 使用台积电 N4P 工艺制造,拥有高达 2080 一亿次晶体管,由两个 GPU 选择芯片互连技术「构成」,并配置高达 192GB 的 HBM3e(高带宽内存),带宽可以达到 8TB/s。

而且就性能而言,谷歌 Trillium TPU 相比上一代 TPU v5e 在 BF16 下提高了 4.7 倍,HBM 容量和带宽,芯片互连带宽也都翻了一番。另外,Trillium TPU 另外还配备了第三代SparseCore,可以加快对新一代基础模型的训练,延迟更低,成本更低。

Trillium TPU 非常适合大规模语言模型和推荐系统的训练,可以扩展数百个 收集,通过每一秒 PB 等级网络互连技术连接数以万计的芯片,实现了另一个很好的方面。「计算机」,大幅度提高计算效率,减少网络延迟。

图/谷歌

从今年下半年开始,Google Cloud 顾客可以率先使用这个芯片。

总体而言,谷歌 TPU 硬件的优点在于其高效的计算能力和低延迟的分布式训练架构。这样做 TPU 在大规模语言模型和推荐系统的训练中表现出色。不过,谷歌 TPU 优点也在于与众不同 CUDA 另外一种完整的生态,以及更深层次的垂直整合。

通过 Google Cloud 平台,用户可灵活地在云端进行练习和部署。这一云端服务模式不仅减少了企业对硬件的投资,而且提高了企业的投资 AI 模型训练效率。Google、 Cloud 同时也提供了一系列的支持 AI 开发工具服务,如 TensorFlow 和 Jupyter Notebook,使开发者能够更方便地进行模型训练和测试。

谷歌用于苹果 TPU v5p,图/谷歌

谷歌的 AI 生态系统还包括许多开发工具和框架,例如 TensorFlow,它是一种广泛使用的开源机学习框架,可以充分利用 TPU 硬件加速功能。谷歌还提供其它支持 AI 开发工具,如 TPU Estimator 和 Keras,这类工具的无缝集成大大简化了开发过程。

另外,谷歌的优势在于:谷歌本身就是对的。 TPU 计算能力需求最大的用户。 YouTube 处理大量的视频内容, Gemini 每次练习和推理,TPU 早已融入谷歌的业务体系,也满足了谷歌大量的计算能力需求。

可以说,谷歌的垂直整合远比英伟达完整,几乎完全掌握了从模型训练到应用再到用户体验的重要节点,这其实给了谷歌更多的可能性,效率可以从底层根据技术和市场趋势进行优化。

因此,虽然在芯片性能参数方面,Trillium TPU 仍然难以和 Blackwell GPU 但是,在大模型训练方面,谷歌仍然可以系统地优化效率,并且可以比肩甚至超越英伟达 CUDA 生态。

在 Google Cloud 用 TPU,这是苹果的最佳选择

简而言之,谷歌 TPU 集群性能、成本和生态的优势使其成为大规模的 AI 理想的模型训练选择。相反, Google Cloud 用 TPU 这也是苹果现阶段的最佳选择。

基于 TPU v4 苹果也使用了超级计算。图片/谷歌

一是性能和成本。TPU 在处理了大规模分布式训练任务之后,苹果表现出色,提供了高效、低延迟的计算能力,满足了苹果的需求 AI 模型训练中的需求。并且使用 Google Cloud 平台、苹果可降低硬件成本,灵活调整计算资源,提高计算资源 AI 整体开发成本。

另外一个方面是生态。谷歌的 AI 开发生态系统还提供了大量的工具支持,使苹果能够更有效地开发和部署它。 AI 模型,加上 Google Cloud 强大的基础设施和技术服务也为苹果提供 AI 这个项目提供了坚实的保障。

今年 3 月,曾在英伟达任职,IBM 和谷歌的 Sumit Gupta 加入苹果,领导云基础设施。据报道,Sumit Gupta 于 2021 每年都加入谷歌 AI 基础设施队伍,最终成为谷歌 TPU、自研 Arm CPU 产品经理等基础设施。

Sumit Gupta 大多数人比苹果内部更了解谷歌。 TPU的优点是。

本文来自微信微信官方账号“雷科技”,作者:雷科技,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com