剑指Sora,AI视频模型120秒免费开玩玩。

近日,Picsart AI 像Resarch这样的团队联合发布了StreamingT2V,它可以生成长达1200帧,持续2分钟的视频,一举超越Sora。StreamingT2V作为开源世界的强大组成部分,可以无缝适应SVD和animatediff等模型。

AI视频模型120秒更长!不但比Sora长,而且免费开源!

近日,Picsart AI Resarch等团队联合发布了StreamingT2V,可生成长达1200帧、长达2分钟的视频,同时质量也很好。

论文地址:https://arxiv.org/pdf/2403.14773.pdf

此外,作者表示,两分钟不是模型的极限,就像Runway的视频可以延长一样,StreamingT2V理论上可以实现无限长度。

在Sora之前,Pika、Runway、Stable Video Diffusion(SVD)等待视频生成模型,一般只能生成几秒钟的视频,最多延长到十秒钟,

Sora一出,60秒的时间直接杀死了所有的模型,Runway的模型。CEO Cristóbal 当天,Valenzuela发了一条推言:比赛开始了。

——没有,超长AI视频120秒就来了。

尽管这并不能立刻撼动Sora的统治地位,但至少在时间上扳回了一座城市。

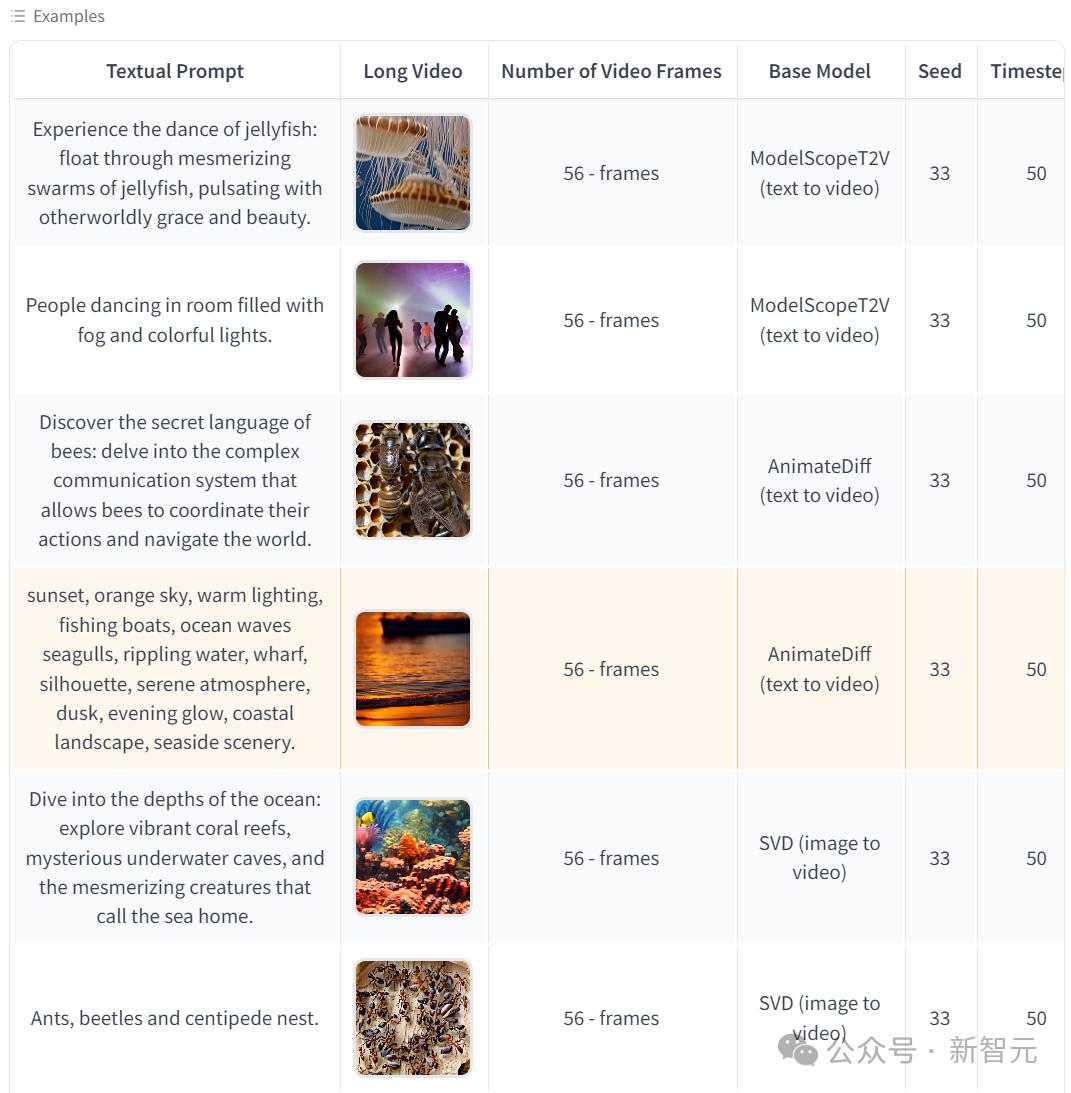

此外,StreamingT2V作为开源世界的强大组成部分,可以适应SVD和animatediff等特点,更好地促进开源生态的发展:

就释放的例子而言,目前兼容性的效果仍然略显抽象,但是技术进步只是时间问题,卷起来才是最重要的~

总有一天我们可以使用它。「Sora开源」,——你说是吧?OpenAI。

免费开玩

现在,StreamingT2V已经在GitHub开放源码,同时在huggingface上提供免费试用,等不及了,小编马上开始测试:

但是看起来服务器负荷太大,上面这个不知道是不是等待时间,反正小编也没有成功。

现在试用的页面可以输入文字和图片两个提醒,后者需要在下面的高级选项中打开。

在两个生成按钮中,Faster Preview是指分辨率较低、时间较短的视频。

所以小编进入了另一个测试平台(https://replicate.com/camenduru/streaming-t2v),最后得到一个测试机会,下面是文字提醒:

A beautiful girl with short hair wearing a school uniform is walking on the spring campus

但也许是因为小编的要求比较复杂,所以产生的效果有些恐怖,大家可以根据自己的经验自己去尝试。

下面是huggingface上的一些经典案例:

01 StreamingT222V

Sora的诞生曾经带来了巨大的震惊,促使Pika在前一秒闪闪发光。、Runway、SVD等模型,直接变成了「前Sora时代」的作品。

但正如StreamingT2V的作者所说,pre-Sora days模型也有其独特的魅力。

模型架构

StreamingT2V是一种先进的自回归技术,在不停滞的情况下,可以创建运动动态丰富的长视频。

保证了整个视频的时间一致性,与描述性文本紧密对齐,保持了高帧图像质量。

从目前的文字到视频传播模式,主要集中在高质量的短视频生成(一般为16或24帧)上。当直接扩展到长视频时,会出现质量下降、表现僵硬或停滞等问题。

通过引进StreamingT2V,可以将视频扩展到80、240、600、1200帧,甚至更长,并且有平滑的过渡,在一致性和运动性方面优于其它模型。

StreamingT2V的关键部件包括:

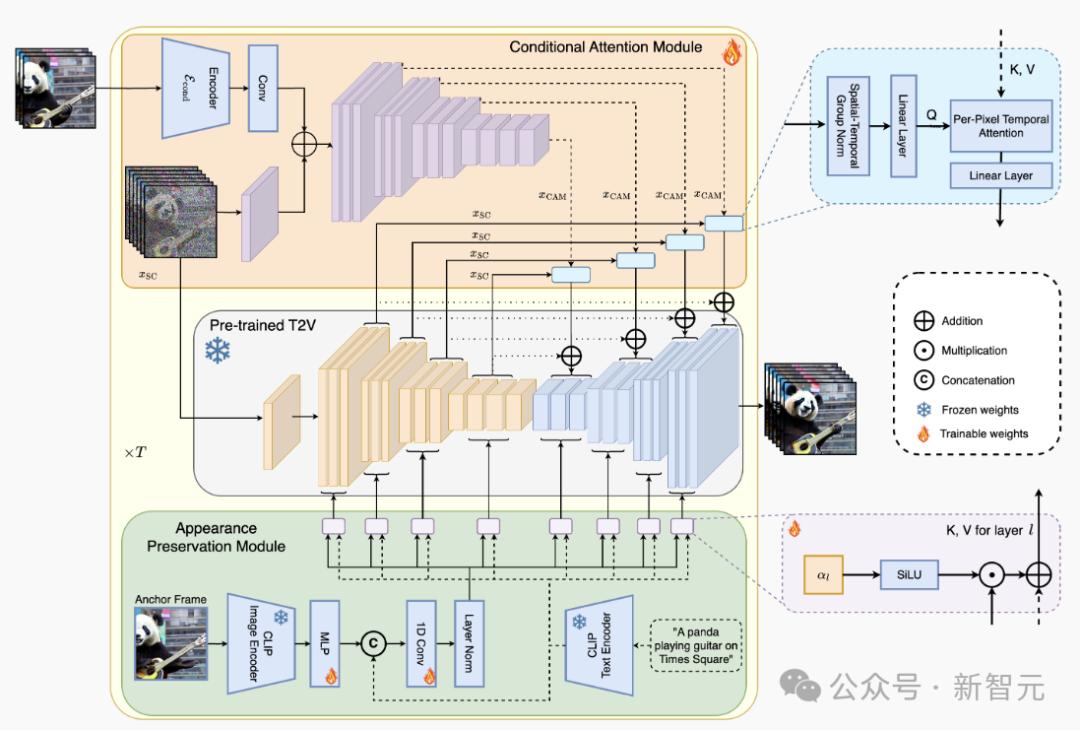

(i)它被称为条件注意模块(CAM)短期记忆块,它根据从前一块中提取的特点,通过注意机制对当前一代进行调整,从而实现一致的块过渡;

(ii)这就是所谓的外观保留模块(APM)长时间记忆块,它从第一个视频块中获得先进的情境和目标特征,以避免模型忘记初始情景;

(iii)一种随机混合的方法,在不出现块与块之间不一致的情况下,可以自动将无限长的视频重新应用到视频增强器中。

以上是StreamingT2V的整体流水线图。在初始阶段,从文本到视频模型生成的第一个16帧。流程处理 T2V 在这个阶段,更多帧的新内容将自动重新生成。

最后,在流量提升阶段,通过将高分辨率文本应用到短视频模型中,并配备上述随机混合方法,生成长视频(600、1200帧或更多帧将自动回归增强。

图片显示了StreamingT2V方法的整体结构:条件注意模块(CAM)外观保留模块作为短期记忆。(APM)扩展到长期记忆。CAM利用帧编码器将视频扩散模型扩展到前一块。(VDM)进行条件处理。

CAM的注意机制保证了块与视频之间的平滑过渡,同时具有较高的运动量。

APM从锚帧中获取高级图像特征,并将其注入VDM的文本交叉注意力,这有助于在视频生成过程中保留目标/场景特征。

注意模块的条件

研究人员首先预先训练一个文本到(短)视频模型(Video-LDM),接着,使用CAM(前一块的一些短期信息),对Video-LDM进行自回归调整。

CAM由特征提取器和特征注入器组成,集成到Video-LDM的UNet中。特征提取器使用逐帧图像编码器。 E。

对特征注入,作者使UNet中的每一个远程弹跳连接,都关注CAM通过交叉注意产生的相应特征。

CAM使用前一块的最后一个Fconditional帧作为输入,交叉注意可以将基本模型的F帧调整为CAM。

相比之下,稀疏编码器使用卷积注入特征,因此需要额外的F − 为了将导出添加到基本模型的F帧中,Fzero值帧(和掩码)作为输入。这样就会导致SparseCtrl的输入不一致,导致视频产生严重不一致。

外观存储模块

回归视频生成器通常会忘记最初的目标和场景特征,从而导致外观发生严重变化。

针对这一情况,外观保留模块(APM)利用固定锚帧中包含的第一块信息来整合长期记忆。这样有利于维护视频块生成之间的情境和目标特征。

为使APM能够平衡锚帧的指导和文本指令的指导,作者建议:

(i)将锚帧中的CLIP图像标记与文本指令中的CLIP文本标记混合,方法是利用线性层将编辑图像标记扩展到k。 = 8, 将文本和图像编码连接到标记维度,并使用投射块;

(ii) 将权重引入每一个交叉注意层。α∈R(初始化为0),用来自加权总和X的键和值来执行交叉注意。

视频自动回归增强

为进一步提高文本到视频结果的质量和分辨率,本文采用高分辨率(1280x720)文本到(短)视频模型。(Refiner Video-LDM)24帧块自动回归增强生成视频。

使用文本到视频模型作为细化器/增强器的24帧,通过向输入视频块添加大量噪音,并使用文本到视频扩散模型的噪音来实现。

但是,单独加强每一块的简单方法会导致不一致的过渡:

作者利用连续块间的共享噪声,并采用随机混合的方法来解决这一问题。

对比测试

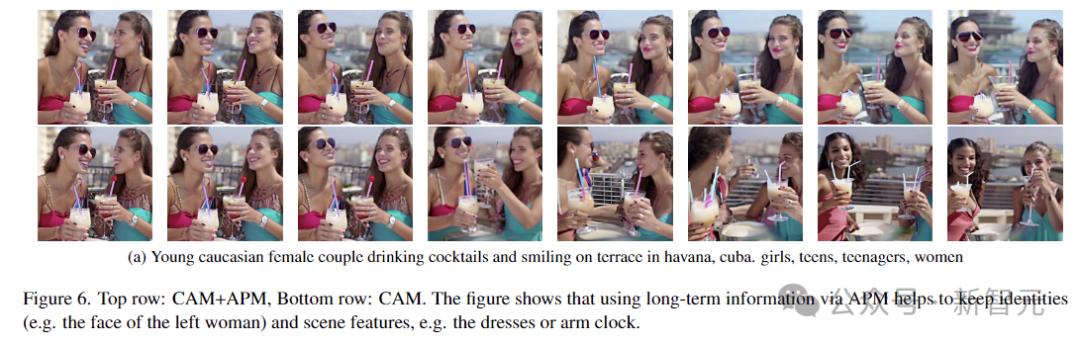

上面的图片是DynamiCrafter-XL和StreamingT2V的视觉对比,使用了同样的提醒。

X-T切片可视化显示,DynamiCrafter-XL有严重的块状不一致和重复运动。相比之下,StreamingT2V可以无缝过渡和持续发展。

当前方法不仅容易出现时间不一致和视频停滞,而且随着时间的推移,它会受到物体外观/特征的变化和视频质量下降的影响(如下图中的SVD)。

理由是,由于只调整了前一块的最后一帧,他们忽略了自回归过程的长期依赖。

StreamingT2V在上面的视觉比较(80帧长度,自回归生成视频)中生成的长度视频不会出现运动停滞。

02 AI长视频可以做些什么

每个家庭都在滚动视频生成,最直观的应用领域,可能是电影或游戏。

电影片段由AI产生。(Pika,Midjourney,Magnific):

Runway甚至举办了一个AI电影节:

但是另外一个答案是什么?

世界模型

Agent和人形机器人最好的训练环境是由长视频创建的虚拟世界,当然前提是它足够长,足够真实(符合物理世界的逻辑)。

也许在未来的某一天,也将是我们人类的生存空间。

参考资料:

https://github.com/Picsart-AI-ResearchT22StreamingT2V

本文来自微信微信官方账号“新智元”(ID:AI_era),作者:新智元,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com