老黄赢了麻,英伟达H100的订单排到了24年,马斯克并不淡定。

最好的GPU炼大模型英伟达H100,全部卖空了!

即便是现在马上买,也要等着。2024年Q1甚至Q2才能用上。

它是CoreWeave向华尔街日报透露的最新动态,与英伟达密切相关。

供应从四月初开始变得异常紧张。仅仅一个星期,预期交货日期为从合理水平跳到年底。

世界上最大的云制造商亚马逊AWS也证实了这一消息,CEO Adam 最近Selipsky说:

A100和H100是最先进的…即使对AWS来说,也很难得到。。

早些时候,马斯克还在一次采访节目中说:现在GPU比d品更难获得。。

要是找“黄牛”买,溢价高达25%。

例如Ebay上的价格已经从出厂价格约36000美元上涨到45000美金,而且供应稀缺。

在这种情况下,国内百度,字节,阿里,腾讯等待大型科技公司也向英伟达下台总计50亿美金芯片订单,如A800。

这些商品中只有10亿美元可以在今年内交付,另外80%也要等到2024年。

那现在高档GPU都卖给谁了?这波产能又卡在哪里了?

H100卖给谁,老黄说了算。

自ChatGPT爆发以来,英伟达A100一直擅长训练大模型。、H100成了热门商品。

即使是H100也可以作为创业公司的一种资产,寻找投资基金来获得抵押贷款。

OpenAI、以Meta为代表AI企业,以亚马逊、微软为代表的云计算公司,私人云Coreweave和Lambda,以及所有想要提炼自己大模型的人。各类科技公司,需求量极大。

不过卖给谁,基本上是英伟达CEO黄仁勋说了算。

据The H100如此紧缺,英伟达达,Information消息,将大量的新卡分配给CoreWeave,对于亚马逊微软等老牌云计算公司限量供应。

(英伟达也直接投资了CoreWeave。)

外部分析是因为这些老牌企业正在开发自己的AI来加速芯片,希望减少对英伟达的依赖,那么老黄也会满足他们。

在英伟达内部,老黄还控制了企业日常经营的各个方面,甚至包括审查销售代表要对小潜在用户说些什么?。

全公司大约40名高管向老黄报告。,这个比Meta小扎和微软小纳的直接下属加起来还要多。

一位英伟达前主管透露,“在英伟达,事实上,黄仁勋是每个产品的首席产品。。”

前阵子,还传出老黄做了一件夸张的事情:要求一些小型云计算公司提供他们的客户列表,想知道GPU的最终用户是谁。

外部分析,这一举动将使英伟达更好地了解客户对其产品的需求,同时也引起了对英伟达利用这些信息获取额外利益的焦虑。

还有人认为,还有一个原因就是老黄想知道谁真的在刷卡,而谁只是囤卡不用。

为什么英伟达和老黄现在有这么大的话语权?

基于GPU的GPU供需过于不平衡, 计算Utils网站,H100有43万个缺口。

Clay作者 根据各种已知信息和传闻,Pascal估计近期AI行业的H100参与者数量。

AI企业方面:

GPT-55,000可能需要50,000的H100来训练GPT-5

据说Meta需要10万元

已经公布了InflectionAI的22,000卡算率集群计划

Anthropic等主要AI创业公司、Character.ai、MistraAI和HelsingAI在欧洲的需求是10,000。

云计算公司方面:

大型公共云中,亚马逊、微软、谷歌、甲骨文均按3万计算,共计12万。

以CoreWeave和Lambda为代表的私有云总共需要10万元

加起来就是43.2万。

这个还没有算上摩根大通,Two Sigma等金融公司和其他行业的参与者也在逐步部署自己的计算集群。

问题来了,这么大的供应缺口,难道不能多生产点吗?

老黄也想啊,可是生产能力被卡住。

这次产能卡在哪里?

事实上,台积电已经调整了英伟达的生产计划。

但仍然无法填补这样一个巨大的缺口。

Charlierlieie英伟达DGX系统副总裁兼总经理 Boyle说,这次不要卡在晶圆里,而是台积电CoWoS封装技术生产能力遇到瓶颈。

正是苹果与英伟达抢台积电产能,要在9月份的新闻发布会前完成下一代iPhone所需的A17芯片。

而且台积电方面最近表示,预计需要1.5年才能使封装工艺积压恢复正常。

CoWoS封装技术是台积电的看家本领,台积电之所以能够战胜三星成为苹果的独家芯片代工厂。

该技术包装的产品特性高,可靠性强,H100可以拥有3TB/s带宽(甚至更多)正是由于这个原因。

CoWoS的全名是Chip-on-Wafer-on-Substrate,是一种从晶圆角度来看芯片集成技术。

该技术可将多个芯片封装到多个芯片中薄厚仅有100μm硅中介层上。

根据介绍,下一代中介层面积将达到6倍reticle,即大约5000毫米。²。

到目前为止,除了台积电,没有一家厂商有这种级别的封装能力。

虽然CoWoS的确很强大,但是没有它就不行吗?其它厂家可以代工吗?

先不说老黄已经说过“不顾新增第二家H100代工厂”。

就现实而言,也许真的不行。

在此之前,英伟达与三星合作过,但是后者从来没有为英伟达生产过H100系列产品,甚至是其它5nm工艺芯片。

因此,三星的技术水平可能无法满足英伟达对尖端GPU的技术要求。

对英特尔来说...他们的5nm商品似乎还没有出现。

因为让老黄换厂家不行,那么客户直接改用AMD怎么样?

AMD,Yes?

假如单论性能的话,AMD的确是慢慢追上来的。

最新推出的MI300XAMD,HBM3内存192GB,5.2.TB带宽/s,可运行800亿参数模型。

DGXX刚刚在英伟达发布。 HBM3e,GH200,内存141GB,带宽5TB//s。

但是,这并不意味着AMD可以立即填补N卡空缺。——

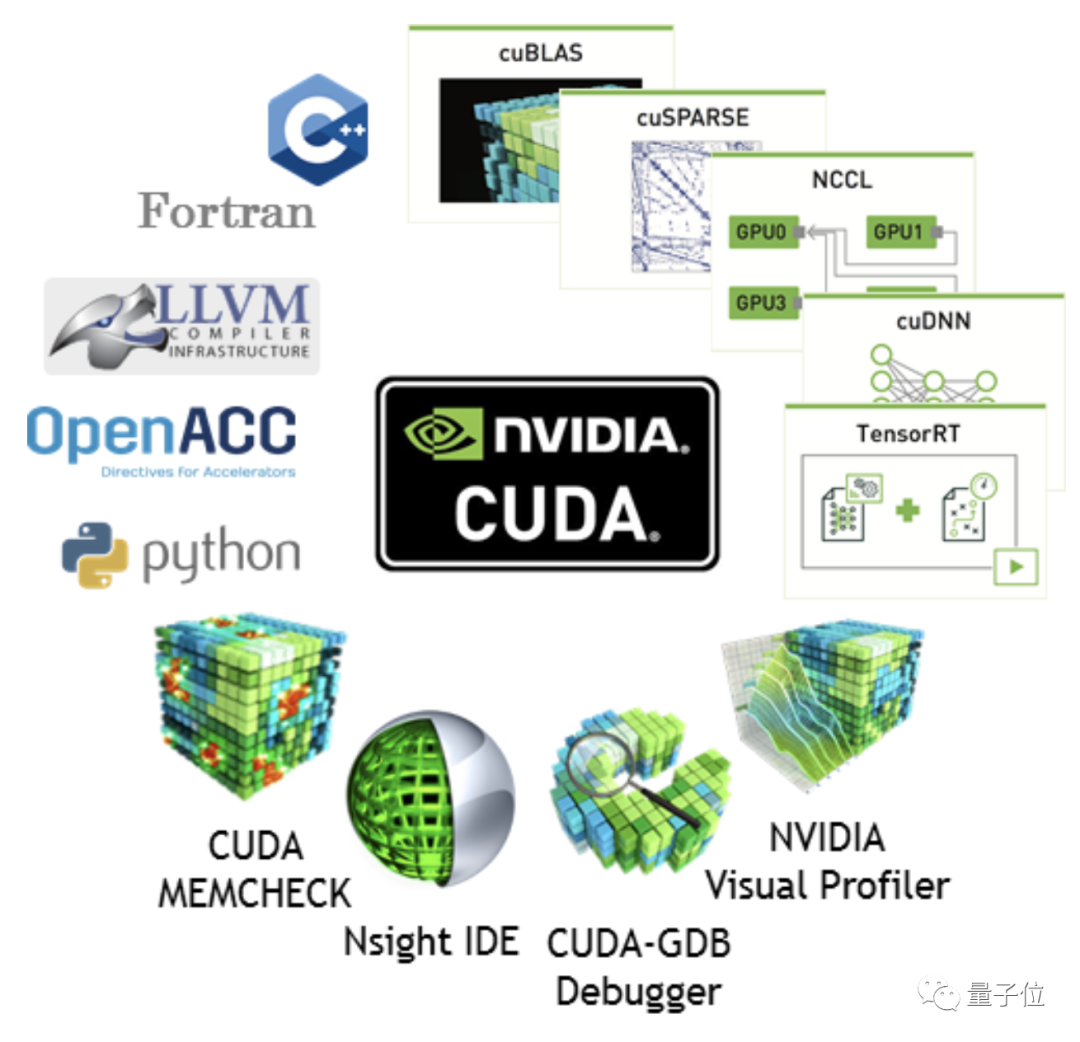

在CUDA平台上,英伟达真正的“环城河”。

CUDA建立了一套完整的开发生态系统,这意味着顾客在购买AMD商品时需要更长的时间来调整。

某私有云企业的一位高管表示,没有人敢冒险花费3亿美元进行测试,安排1万个AMD。 GPU。

这位高管认为,开发调整周期可能至少需要两个月。

对于任何一家厂商来说,在AI商品快速升级的大环境下,两个月的空档期都是致命的。

但微软却向AMD伸出了橄榄叶。

以前有传言说 ,AI芯片由微软和AMD联合开发,代号为“雅典娜”。

而且早些时候,MI200发布的时候,微软首次宣布采购,并在其云平台Azure上部署。

举例来说,前阵MSRA的新型系统架构RetNet就是512个AMDD MI200训练有素。

在英伟达几乎占据了整个AI市场的情况下,人们可能需要带头冲锋。只有在整个大型AMD计算率集群打样之前,人们才有勇气跟进。

然而,在短时间内,英伟达H100、A100仍然是最主流的选择。

One More Thing

前阵子苹果发布了192GB内存最高支持。新款M2 Ultra芯片此时,还有不少从业者享受着用它来微调大模型。

归根结底,苹果M系列芯片的内存存储是统一的,192GB内存就是192GB显存。,但是80GB 2.4倍的H100,或24GB 8倍于RTX4090。

但是,在有人真正购买了这台机器之后,实际测试训练速度。还不如英伟达RTX3080TI0,微调不划算,训练就更不用说了。

归根结底,M系列芯片计算率部分并非专门针对AI计算进行优化,光大显存也没有用。

炼制模型,看起来主要还是要靠H100,而H100又要求。

面临这样的情况,网络上甚至流传着一首歌。神奇的“GPU之歌”。

非常洗脑,谨慎进入。

GPU之歌本家 https://www.youtube.com/watch?v=YGpnXANXGUg

参考链接:

[1]https://www.barrons.com/articles/nvidia-ai-chips-coreweave-cloud-6db44825

[2]https://www.ft.com/content156-4870-4ca4-b67d-bb5a285d855ca4-9dfee

[3]https://www.theinformation.com/articles/in-an-unusual-move-nvidia-wants-to-know-its-customers-customers

[4]https://www.theinformation.com/articles/ceo-jensen-huang-runs-nvidia-with-a-strong-hand

[5]https://gpus.llm-utils.org/nvidia-h100-gpus-supply-and-demand/#which-gpus-do-people-need

[6]https://3dfabric.tsmc.com/english/dedicatedFoundry/technology/cowos.htm

[7]https://developer.nvidia.com/blog/cuda-10-features-revealed/

[8]https://www.theverge.com/2023/5/5/23712242/microsoft-amd-ai-processor-chip-nvidia-gpu-athena-mi300

[9]https://www.amd.com/en/press-releases/2022-05-26-amd-instinct-mi200-adopted-for-large-scale-ai-training-microsoft-azure

本文来自微信微信官方账号“量子位”(ID:QbitAI),作者:梦晨 经授权发布的克雷西36氪。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com